Llamar “inteligente” a un producto vende, y aparentar ser un directivo en videollamada abre puertas. Los reguladores ya persiguen a quienes exageran sus capacidades de IA, mientras el crimen organizado explota la misma tecnología para engañar a empleados y bancos.

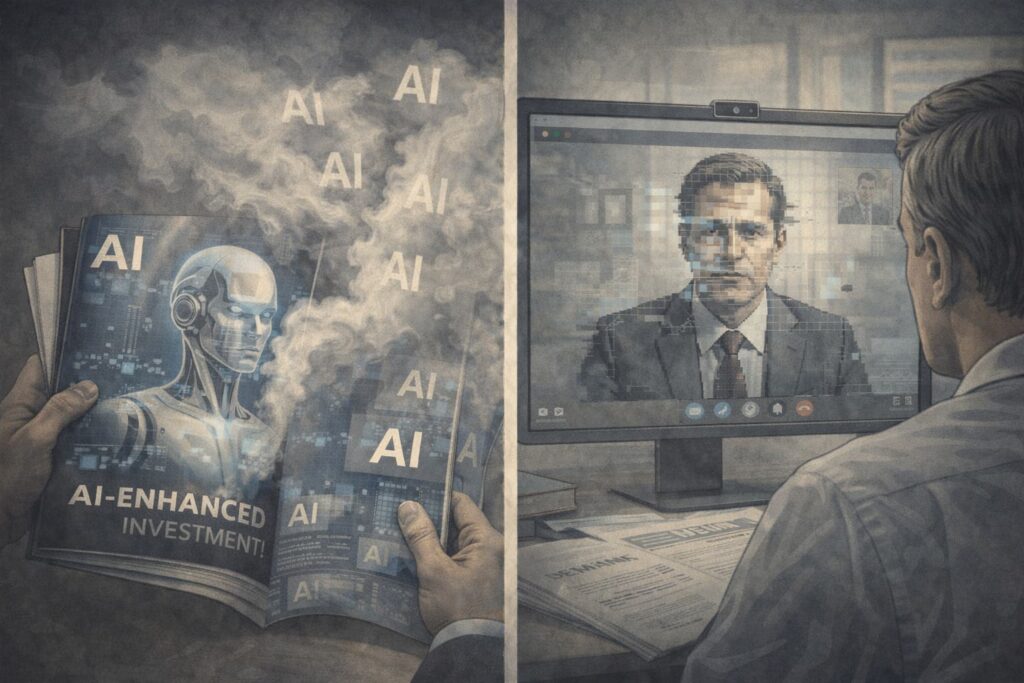

“AI washing”: cuando la IA existe solo en el folleto

En 2024, la Comisión de Bolsa y Valores de Estados Unidos (SEC) sancionó a Delphia (USA) Inc. y Global Predictions Inc. por hacer afirmaciones engañosas sobre el uso de IA en sus servicios de inversión. Según la investigación, ambas compañías se presentaban como plataformas que utilizaban algoritmos avanzados y machine learning para anticipar tendencias y ofrecer una supuesta ventaja competitiva basada en datos.

En el caso de Delphia, los materiales promocionales aseguraban que la firma analizaba datos de sus propios clientes para predecir qué empresas iban a destacar y “adelantarse” al mercado. Sin embargo, la SEC constató que, en la práctica, esos datos no se estaban usando como se afirmaba. Global Predictions, por su parte, llegó a describirse como “el primer asesor financiero de IA regulado”, sin que esa etiqueta reflejara de forma veraz la realidad de su modelo de negocio.

Ambas compañías aceptaron pagar multas (225.000 dólares en el caso de Delphia y 175.000 en el de Global Predictions) y corregir su documentación, sin admitir ni negar expresamente los hechos. El presidente de la SEC, Gary Gensler, aprovechó el caso para popularizar el término “AI washing”, comparándolo con el “greenwashing” en materia de sostenibilidad.

Cómo detectar el humo en la IA

Los reguladores recomiendan a los inversores desconfiar de las promesas vagas sobre IA. Preguntas simples como “¿qué datos utiliza exactamente el modelo?”, “¿qué decisiones toma de forma automatizada?” o “¿qué parte del proceso sigue siendo humana?” ayudan a distinguir entre innovación real y marketing vacío.

Cuando una empresa usa de manera prominente la etiqueta “IA” pero no puede describir con claridad su función concreta, es una señal de alarma similar a las proclamaciones exageradas sobre rentabilidades futuras.

El deepfake que convenció a un empleado de enviar 25 millones

Mientras los reguladores se ocupan del “AI washing”, la misma tecnología alimenta fraudes cada vez más sofisticados. En 2024, la policía de Hong Kong reveló un caso que ha dado la vuelta al mundo: un empleado de finanzas de una multinacional transfirió unos 25 millones de dólares tras participar en una videollamada con su supuesto director financiero y otros directivos… que en realidad eran deepfakes.

Los estafadores empezaron con un correo que imitaba el estilo del CFO y solicitaba una operación confidencial. Ante las dudas del trabajador, organizaron una reunión por vídeo. Allí aparecieron varias caras conocidas para el empleado, recreadas a partir de vídeos públicos mediante herramientas de generación de imagen y voz. Durante la llamada, los “directivos” le dieron instrucciones precisas para realizar una serie de transferencias a distintas cuentas.

Convencido de que estaba obedeciendo una orden legítima, el empleado ejecutó quince transferencias que sumaban unos 200 millones de dólares hongkoneses. Solo después, al hablar con el CFO real, la empresa descubrió el fraude. Informes posteriores de firmas de ciberseguridad y del Foro Económico Mundial han analizado este caso como ejemplo de una nueva generación de estafas empresariales basadas en suplantación visual y sonora.

Cuando ya no basta con “reconocer la cara”

Los expertos en seguridad señalan que estos ataques explotan no solo la tecnología, sino también la cultura corporativa: obediencia a la jerarquía, urgencia, confidencialidad y miedo a cuestionar a un superior. Recomendaciones habituales incluyen:

- Establecer procedimientos de doble verificación para transferencias grandes o inusuales (segunda firma, llamada a un número verificado, código acordado).

- Formar al personal en la existencia de deepfakes y legitimar que se cuestione una orden si algo “no cuadra”.

- Limitar la cantidad de información sensible y material audiovisual disponible públicamente sobre directivos clave.

Una misma advertencia: la IA no es neutra

Los casos de “AI washing” y de fraude con deepfakes podrían parecer extremos opuestos, uno exagerar capacidades y otro explotarlas al máximo, pero comparten un hilo conductor: la percepción pública de la IA como algo casi mágico. Ese halo se presta tanto a vender humo como a engañar a empleados bienintencionados.

Frente a ello, la respuesta no pasa por demonizar la tecnología, sino por desmitificarla. La IA es una herramienta poderosa que puede aportar valor real… o convertirse en vehículo de fraude, según quién la use y bajo qué reglas. Exigir transparencia, establecer protocolos y fomentar el pensamiento crítico son, de momento, las mejores defensas.