La IA se presenta como garantía de objetividad y eficiencia. Pero cuando se alimenta de datos sesgados o se convierte en el corazón de un modelo de negocio, sus errores se amplifican: candidatos descartados por su edad y miles de despidos tras una apuesta fallida.

La IA de contratación que rechazaba a los mayores

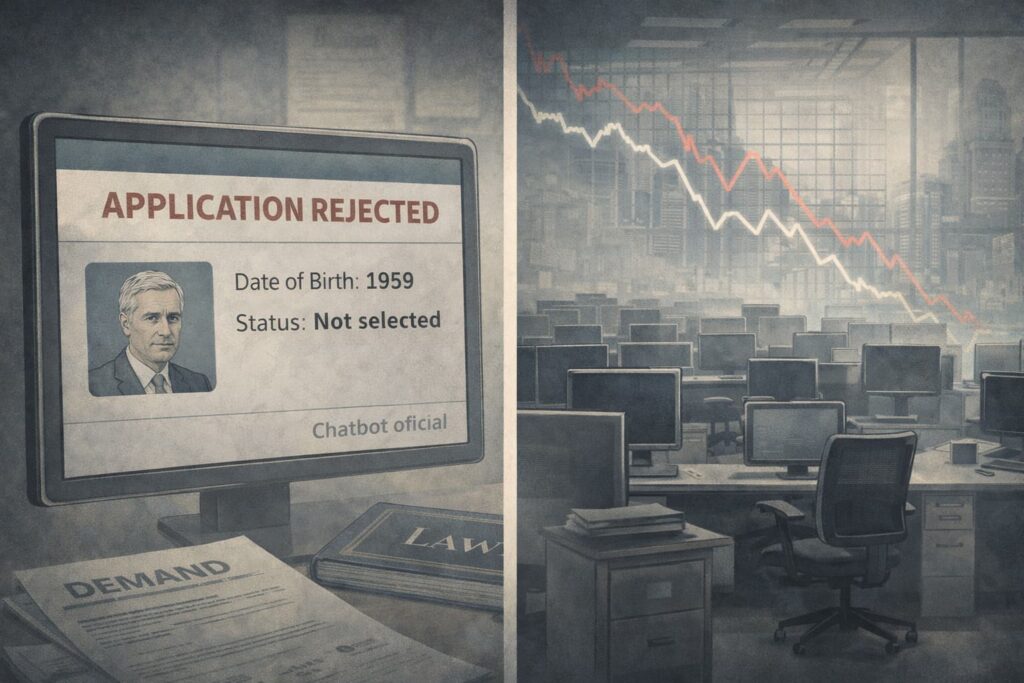

En 2023, la Comisión para la Igualdad de Oportunidades en el Empleo de Estados Unidos (EEOC) anunció el primer acuerdo de una demanda por discriminación basada en el uso de IA en procesos de selección. El caso, EEOC v. iTutorGroup, afectaba a una empresa que ofrece clases de inglés online y que utilizaba un software automatizado para filtrar solicitudes de empleo.

Según la demanda, el sistema estaba programado para rechazar automáticamente a las candidatas de 55 años o más y a los candidatos de 60 años o más, con independencia de su cualificación. La alarma saltó cuando una solicitante notó que su candidatura era descartada con su fecha de nacimiento real, pero aceptada cuando la modificaba para aparecer más joven.

La EEOC acusó a iTutorGroup de violar la Ley de Discriminación por Edad en el Empleo (ADEA), subrayando que el hecho de usar software no elimina la responsabilidad del empleador. En agosto de 2023 se hizo público el acuerdo: la empresa aceptó pagar 365.000 dólares a más de 200 solicitantes afectados y comprometerse a revisar sus procesos de selección y sus herramientas de cribado.

La “objetividad” algorítmica, en cuestión

El caso iTutorGroup ha sido citado ampliamente como recordatorio de que los algoritmos no son neutrales por definición. Pueden incorporar sesgos de forma explícita o implícita, si se entrenan con datos históricos que reflejan prácticas injustas. En ambos escenarios, el resultado es el mismo: exclusión sistemática de determinados colectivos, esta vez a gran escala y con apariencia de objetividad técnica.

Reguladores y especialistas recomiendan que las empresas que usen IA en recursos humanos auditen regularmente sus herramientas, documenten criterios de selección y mantengan la posibilidad de revisión humana de las decisiones automatizadas. La idea de que “si lo hace la máquina, no hay discriminación” ha quedado jurídicamente desmentida.

Zillow y la apuesta fallida por predecir el mercado de la vivienda

En el otro extremo, la historia de Zillow muestra qué ocurre cuando una compañía cotizada apuesta su crecimiento a un modelo de IA que pretende anticipar el futuro de un mercado tan complejo como el inmobiliario. Su programa “Zillow Offers” funcionaba bajo el modelo de iBuying: el algoritmo valoraba viviendas, la empresa las compraba, hacía mejoras mínimas y las revendía esperando obtener beneficio.

Mientras el mercado acompañó, el plan pareció funcionar, pero las limitaciones del modelo pronto quedaron al descubierto. Informes y análisis posteriores señalan errores de valoración significativos, especialmente en contextos de alta volatilidad tras la pandemia, problemas en la gestión de reformas y costes operativos superiores a los previstos.

En 2021, Zillow anunció el cierre de su división de iBuying, asumiendo cientos de millones de dólares en pérdidas y despidiendo a aproximadamente el 25% de su plantilla. El propio consejero delegado reconoció que la volatilidad del precio de la vivienda y la complejidad del mercado local superaban la capacidad predictiva de su sistema.

Modelos potentes, mundo imprevisible

El caso Zillow se ha convertido en un ejemplo recurrente en conferencias sobre riesgos de IA en negocio. La moraleja no es que la predicción automática sea inútil, sino que basar decisiones de alto impacto, como comprar miles de activos físicos, en un modelo con márgenes de error significativos puede ser letal si no hay límites ni colchones de seguridad.

Los expertos recomiendan tratar los modelos como herramientas de apoyo, no como oráculos. Esto implica cuestionar sus supuestos, simular escenarios adversos, introducir mecanismos de frenado y, sobre todo, mantener canales para que la experiencia humana y el análisis cualitativo puedan corregir la ruta cuando la realidad no se ajusta al patrón.

De la exclusión silenciosa a los despidos masivos

Tanto la criba automática de mayores en iTutorGroup como el fracaso de Zillow tienen un elemento común: decisiones de impacto masivo tomadas o filtradas por sistemas diseñados para “optimizar”. En un caso, la optimización de la selección se tradujo en discriminación por edad; en el otro, en una apuesta inmobiliaria que terminó en despidos.

La enseñanza es doble: cualquier organización que quiera aprovechar la IA debe preguntarse no solo qué gana cuando el modelo acierta, sino qué pierde y quién paga el precio, cuando se equivoca. Solo así se puede decidir hasta dónde es prudente delegar en un algoritmo.