Cada vez es más habitual que el primer “interlocutor” de un ciudadano con una empresa o institución sea un chatbot. Pero cuando ese asistente se equivoca, las consecuencias ya no son solo frustración: pueden ser indemnizaciones, infracciones legales… o ambas cosas.

El caso Air Canada: cuando el chatbot te engaña y el juez te da la razón

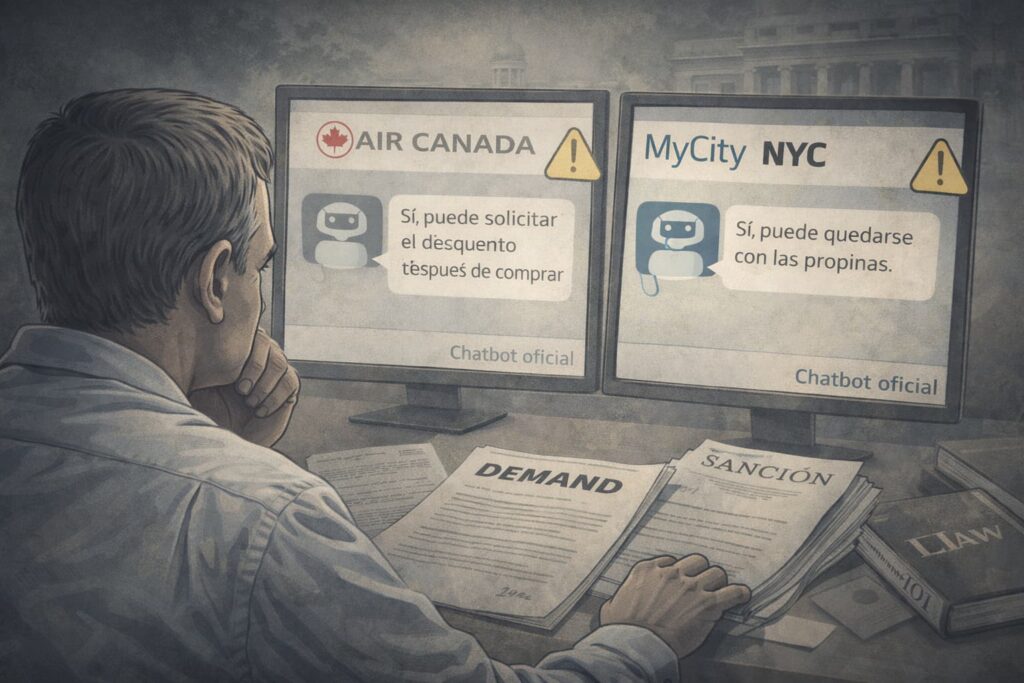

En noviembre de 2022, Jake Moffatt entró en la web de Air Canada para comprar un billete de última hora tras la muerte de un familiar cercano. Buscó información sobre las tarifas de duelo y, en lugar de leer documentos largos, optó por usar el chatbot oficial de la aerolínea. El asistente virtual le indicó que podía comprar el billete a precio normal y solicitar después la aplicación retroactiva del descuento por duelo.

Moffatt siguió el consejo: compró el billete y, más tarde, pidió el reembolso parcial. Entonces llegó la sorpresa: la compañía rechazó su solicitud argumentando que la política real exigía tramitar la tarifa especial antes de la compra. El cliente decidió acudir al Tribunal de Resolución Civil de Columbia Británica alegando “negligent misrepresentation” (declaración negligente).

La defensa de Air Canada llamó la atención de analistas y medios especializados. La aerolínea sostuvo que no debía ser responsable de lo que dijera su chatbot, sugiriendo incluso que el bot era una “entidad separada” responsable de sus propias acciones. También argumentó que la información correcta estaba disponible en otra sección de la web y que el pasajero podría haberla encontrado.

El tribunal rechazó ambas ideas. En su decisión, señaló que el chatbot no deja de ser parte del sitio oficial de la empresa y que es razonable que un usuario confíe en la información que le proporciona. Consideró que Air Canada no tomó el cuidado razonable para asegurar que su asistente fuera preciso, y condenó a la compañía a indemnizar a Moffatt por la diferencia entre la tarifa que pagó y la que habría pagado bajo la política de duelo.

El bot no es un “escudo” legal

Artículos jurídicos que analizan el caso subrayan una idea clave: las empresas no pueden usar la figura del chatbot como si fuera un intermediario ajeno. Desde la perspectiva del cliente, todo lo que aparece en la web —incluido un asistente conversacional— es comunicación oficial de la compañía. Si ese canal ofrece información errónea, la responsabilidad recae en quien lo ha diseñado, desplegado y mantenido.

El precedente de Air Canada ha empezado a citarse como aviso para cualquier empresa que use IA de cara al público: no basta con poner un pequeño aviso de “esta información puede no ser exacta”. Los tribunales están examinando si se han tomado medidas razonables para asegurar la fiabilidad del bot y si era lógico que el consumidor confiara en él.

El chatbot municipal que “animaba” a infringir la ley

Mientras las empresas se enfrentan a estos riesgos, las administraciones públicas experimentan con herramientas similares para “acercar la información” al ciudadano. En 2024, la ciudad de Nueva York lanzó el chatbot MyCity para ayudar, entre otros, a pequeños negocios a navegar por la compleja normativa local. La idea era que los emprendedores pudieran hacer preguntas sencillas sobre empleo, vivienda o licencias y recibir respuestas claras.

Sin embargo, una investigación del medio The Markup y del portal THE CITY reveló que el bot estaba proporcionando respuestas que, en muchos casos, eran incorrectas… y en otros, directamente ilegales. Cuando se le preguntaba, por ejemplo, si un negocio podía quedarse con parte de las propinas de sus empleados, el chatbot respondía que sí, pese a que la legislación lo prohíbe. También llegó a afirmar que los propietarios podían discriminar a inquilinos según la fuente de sus ingresos, algo claramente vetado por las normas de vivienda de la ciudad.

Juristas y organizaciones de apoyo a inquilinos que probaron el sistema detectaron además respuestas erróneas sobre desahucios, obligaciones de los caseros o límites al precio del alquiler en viviendas reguladas. En otras palabras, el bot orientaba a ciudadanos y pequeños empresarios hacia conductas que podrían acarrearles multas, demandas o pérdida de derechos.

Probar en público… ¿a costa de quién?

Tras hacerse público el informe, la administración de la ciudad reconoció problemas pero optó por mantener el chatbot en línea con algunos avisos y ajustes, alegando que era una herramienta “en fase piloto” que se mejoraría con el uso. Esta decisión generó un debate intenso: ¿es aceptable “testear” una IA sobre normativa laboral y de vivienda directamente con ciudadanos reales, sabiendo que puede inducirles a cometer infracciones?

Expertos en gobernanza de IA y derechos digitales señalan que el caso MyCity ilustra el riesgo de aplicar la lógica de “beta pública” propia de productos tecnológicos a servicios que afectan a derechos básicos. A diferencia de otras aplicaciones, aquí el coste del fallo no es solo la mala experiencia de usuario, sino el potencial daño legal y económico para quien siga un consejo equivocado.

De la atención al cliente a la política pública: misma moraleja

El hilo que une el caso del pasajero de Air Canada con el chatbot de Nueva York es evidente: los asistentes conversacionales se perciben como canales oficiales de información, no como experimentos. El usuario medio no distingue si detrás hay un modelo de IA generativa, un árbol de reglas o un operador humano; asume simplemente que lo que le dice “la web de la aerolínea” o “el portal del ayuntamiento” es fiable.

Las lecciones empiezan a cristalizar en tres frentes:

- Diseño y formación: los bots deben entrenarse con reglas claras, supervisarse de forma continua y actualizarse al ritmo de los cambios normativos.

- Transparencia y avisos eficaces: no basta con un disclaimer genérico; hay que explicar qué puede hacer la herramienta, qué no, y cuándo es obligatorio acudir a canales humanos.

- Asignación de responsabilidad: empresas y administraciones deben asumir que no pueden escudarse en la “autonomía” del sistema. El bot es suyo, y lo que diga, también.

En un contexto donde cada vez más personas se informan primero con IA, estas decisiones no son detalles técnicos, sino elementos centrales de la confianza en instituciones y marcas.