Reconocer un deepfake de voz en breve

Detectar una voz creada por inteligencia artificial se ha convertido en una habilidad clave en la era digital. Las voces sintéticas son tan realistas que engañan incluso a profesionales del audio. Sin embargo, todavía existen señales sutiles que delatan su origen artificial.

Señales auditivas

- Entonación monótona: carece de emoción y matices naturales.

- Ritmo mecánico: pausas perfectamente regulares o sin respiraciones audibles.

- Errores de acentuación: énfasis en sílabas incorrectas o palabras funcionales.

- Ausencia de imperfecciones humanas: sin chasquidos, vibratos o respiraciones.

Pruebas técnicas

El análisis forense permite detectar microvariaciones imposibles de replicar por IA:

- Jitter y shimmer: pequeñas fluctuaciones en tono y volumen presentes en toda voz humana.

- Formantes “demasiado perfectos”: picos de frecuencia estables que no se dan naturalmente.

- Textura tímbrica: las voces sintéticas suelen sonar más “planas” o limpias de lo normal.

Estrategias para usuarios

- Rompe el guion: pide repetir frases o trabalenguas.

- Introduce ruido: interrumpe o habla encima para ver si responde naturalmente.

- Verifica por otro canal: ante una llamada sospechosa, cuelga y devuelve tú la llamada a un número verificado.

Estudio sobre el reconocimiento del agente de IA por voz

- El auge de la voz sintética y la necesidad de discernir

- El detector humano: pistas auditivas para desenmascarar a la IA

- Las huellas digitales técnicas de la voz sintética

- Combatir IA con IA: herramientas y modelos de detección automática

- La detección es una carrera armamentista sin fin

- Tendencias y contramedidas

El auge de la voz sintética y la necesidad de discernir

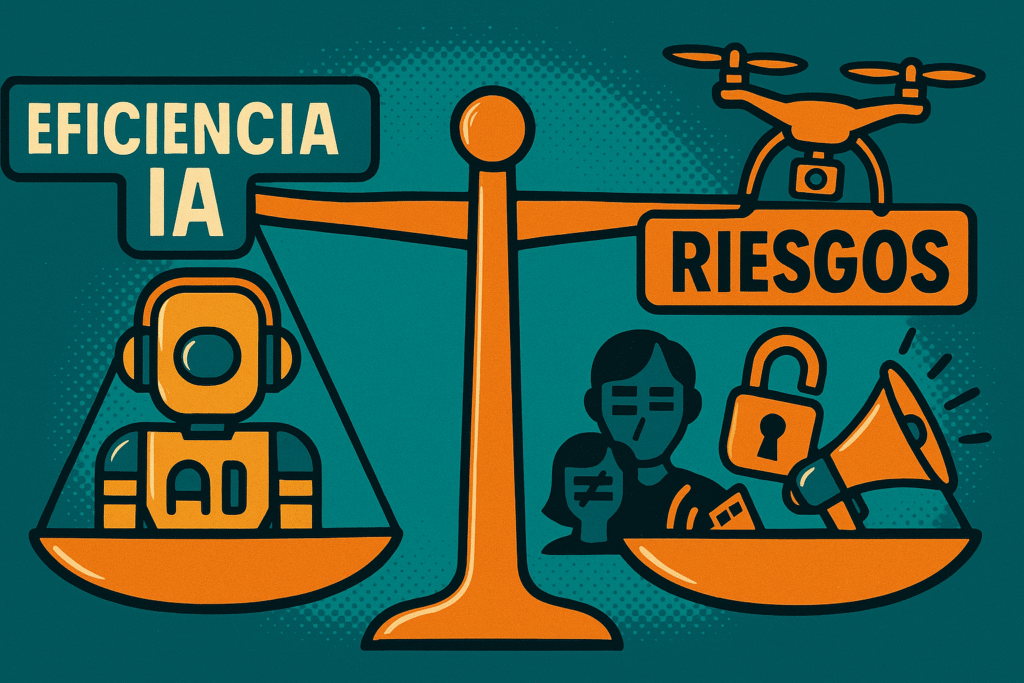

En enero de 2024, en vísperas de las primarias de New Hampshire en Estados Unidos, miles de votantes demócratas recibieron una llamada automática. La voz, que instaba a no votar, era indistinguible de la del presidente Joe Biden. Sin embargo, no era él. Se trataba de un *deepfake* de audio, una réplica sintética creada por un consultor político utilizando tecnología de clonación de voz de la empresa ElevenLabs, accesible por apenas unos dólares al mes. Este incidente, documentado en la revista Nature, no es una anécdota aislada, sino el presagio de una nueva realidad donde la línea entre la voz humana y la artificial se ha vuelto peligrosamente borrosa.

El mercado global de la voz por inteligencia artificial (IA) está experimentando un crecimiento exponencial. En 2024, alcanzó un valor de 5.400 millones de dólares, un 25% más que el año anterior, según informes citados por Forbes. Las proyecciones indican que el sector de la autenticación de voz, por sí solo, crecerá a una tasa anual compuesta del 23.7% hasta 2027 . Este auge se debe a los enormes beneficios que prometen los agentes de voz por IA.

Un agente de voz por IA es, en esencia, un sistema de software que utiliza reconocimiento de voz, inteligencia artificial conversacional y síntesis de voz para interactuar verbalmente con los usuarios . Sus aplicaciones son transformadoras: desde mejorar la accesibilidad para personas con discapacidades o bajo nivel de alfabetización, hasta optimizar la atención al cliente y, de manera crucial, apoyar en la detección temprana de enfermedades. Estudios han demostrado que el análisis de biomarcadores vocales puede identificar signos de Parkinson, diabetes tipo 2 o afecciones cardiovasculares antes de que los síntomas físicos sean evidentes.

Sin embargo, esta misma tecnología abre la puerta a riesgos significativos. La suplantación de identidad para cometer fraudes financieros, la difusión de desinformación a gran escala y la manipulación de pruebas en contextos legales son amenazas reales y crecientes. Un caso notorio, reportado por Sophos en 2019, implicó el uso de un *deepfake* de voz para imitar a un CEO, logrando que un subordinado transfiriera 243.000 dólares a una cuenta fraudulenta. La IA no solo replicó el timbre, sino también el acento y las pausas características del ejecutivo, convenciendo por completo a la víctima.

Ante este panorama dual, la capacidad de discernir entre una voz humana y una sintética deja de ser una curiosidad técnica para convertirse en una habilidad esencial para la seguridad personal, empresarial y social. Este artículo presenta una guía exhaustiva, fundamentada en estudios académicos recientes y análisis de expertos forenses, para que tanto usuarios como profesionales puedan aprender a identificar una voz generada por IA. Exploraremos desde las pistas sutiles que podemos captar con una escucha activa hasta las herramientas técnicas y contramedidas que definen el futuro de la autenticación de voz.

El detector humano: pistas auditivas para desenmascarar a la IA

A pesar de la creciente sofisticación de los modelos de IA, el oído humano, entrenado para reconocer los matices de la comunicación, sigue siendo la primera línea de defensa. Las voces sintéticas, aunque cada vez más realistas, a menudo tropiezan en la replicación de las imperfecciones y la complejidad del habla natural. Esta sección se enfoca en las señales que una persona puede detectar mediante la escucha atenta, proporcionando consejos prácticos para una evaluación en tiempo real.

La prosodia como delator principal

La prosodia es el conjunto de elementos fónicos que dotan al habla de su musicalidad y expresividad: la entonación (melodía de la frase), el ritmo (la cadencia), el acento (el énfasis en sílabas) y la intensidad (el volumen). Es aquí donde los modelos de IA, incluso los más avanzados, suelen cometer sus errores más evidentes. Como advierte un experto de la Universitat Oberta de Catalunya (UOC), "la mayoría de los *deepfakes* de voz fallan en cómo suena la conversación —prosodia— más que en la textura del timbre". Las anomalías más comunes son:

- Entonación plana o monótona: El habla humana está llena de variaciones tonales que transmiten emociones y matices (duda, ironía, certeza). Una voz de IA puede sonar robótica, apática o carente de esta variación emocional. Este fenómeno es similar a lo que en logopedia se conoce como trastorno prosódico apático, donde el habla carece de color emocional.

- Ritmo y pausas antinaturales: El ritmo del habla humana es irregular. Hacemos pausas para respirar, para pensar o para dar énfasis. Las voces sintéticas pueden exhibir latencias (tiempo de respuesta) sospechosamente regulares entre frases, como si un metrónomo invisible dictara el tempo. También pueden insertar pausas en lugares gramaticalmente incorrectos o, por el contrario, carecer de las pausas naturales para la respiración, creando un flujo de habla ininterrumpido y poco natural.

- Acentuación incorrecta: El énfasis en la sílaba o palabra equivocada es un claro indicador. Un modelo de IA puede fallar en comprender el contexto semántico y, por tanto, acentuar una palabra funcional (como "un" o "el") en lugar de la palabra clave de la frase, alterando el significado o la naturalidad de la misma.

La ausencia de "ruido" humano

El habla humana está lejos de ser perfecta. Es un proceso biológico que involucra pulmones, cuerdas vocales, lengua y labios, generando una serie de "ruidos" orgánicos que damos por sentados. La ausencia de estas imperfecciones es, paradójicamente, una señal de artificialidad. Un perito forense señalaría la importancia de buscar la "ausencia de microvariaciones fisiológicas" como un marcador técnico de una voz sintética. Las señales a las que prestar atención incluyen:

- Falta de ruidos orgánicos: Las voces humanas están salpicadas de sonidos como respiraciones entre frases, chasquidos sutiles de labios, carraspeos o la saliva. Los modelos de IA, entrenados a menudo con audio "limpio", pueden omitir por completo estos elementos, resultando en un discurso extrañamente pulcro.

- Perfección anómala: Un sonido que es demasiado claro, sin ningún tipo de ruido de fondo ambiental o las ligeras variaciones de un micrófono, puede ser una bandera roja. Expertos en acústica forense apuntan a que una "perfección anómala" es uno de los signos más evidentes de una voz generada por IA.

- Ausencia de microtensiones y vibratos: La tensión emocional o el simple esfuerzo físico de hablar introducen microvariaciones en el tono (vibrato) y la tensión de las cuerdas vocales. Una voz sintética puede carecer de esta textura dinámica, sonando demasiado estable y controlada.

Artefactos y distorsiones sutiles

A pesar de los avances, los algoritmos de síntesis de voz todavía pueden dejar pequeñas "cicatrices" técnicas en el audio, conocidas como artefactos. Estos son errores sutiles que, aunque difíciles de detectar, pueden delatar el origen artificial de la voz.

- Sonido "metálico" o espectral: A veces, las voces de IA tienen una cualidad ligeramente robótica o un timbre "metálico", especialmente en los bordes de las palabras o en las sibilantes (sonidos como la 's'). Esto se debe a imperfecciones en el proceso de reconstrucción de la señal de audio.

- Errores en fonemas complejos: Ciertos sonidos del habla son particularmente difíciles de sintetizar. Un estudio de análisis fonético publicado en Scielo encontró que la vibrante múltiple /r/ en español (como en "perro") es mucho más rica y variable en la voz natural que en su contraparte artificial, que tiende a ser más simplificada o inconsistente.

- Diferenciar de una mala conexión: Es crucial no confundir estos artefactos con los problemas de una mala conexión a internet o telefónica. La clave está en la consistencia. Como explica el experto de la UOC, los fallos de una IA tienden a ser consistentes (por ejemplo, las latencias son siempre iguales o el tono metálico aparece en fonemas similares), mientras que los problemas de una mala conexión son erráticos e irregulares (el sonido se corta, fluctúa y el desfase es impredecible).

Caja de herramientas prácticas: cómo poner a prueba a la IA en directo

Si durante una llamada sospechas que estás hablando con una IA, no te limites a escuchar pasivamente. Puedes realizar una serie de "tests de estrés" para forzar al modelo a salirse de su zona de confort y revelar su naturaleza artificial. Estas tácticas, recomendadas por expertos en ciberseguridad, están diseñadas para romper la inercia del algoritmo:

- Romper el guion: Pide al interlocutor que repita una frase inesperada, compleja o con un juego de palabras (ej. "Tres tristes tigres…"). Los modelos de IA, especialmente los más simples, pueden tener dificultades para procesar y repetir correctamente solicitudes que se salen de su guion predefinido.

- Introducir interrupciones y ruido: El habla humana es conversacional e interactiva. Intenta hablar encima de tu interlocutor o interrumpirle a mitad de una frase. Un humano se detendrá o reaccionará de forma natural. Una IA podría seguir hablando como si nada o detenerse y reanudar con una latencia extraña. También puedes introducir ruido de contexto, como teclear fuerte o dar una palmada cerca del micrófono, para observar cómo reacciona el sistema de cancelación de ruido del modelo.

- Verificación por un segundo canal (Callback): Esta es la defensa definitiva y la más recomendada en entornos corporativos o ante peticiones sensibles (transferencias de dinero, contraseñas). Cuelga la llamada con una excusa natural ("La calidad es mala, te devuelvo la llamada"). A continuación, llama tú mismo a un número de teléfono verificado previamente (el que tienes en tu agenda, no el número entrante). Este simple paso desarma la mayoría de los intentos de fraude, ya que obliga al atacante a controlar también el segundo canal de comunicación.

- Usar una "Safe Word" (Palabra de seguridad): En entornos empresariales, se puede establecer una palabra clave o frase de seguridad acordada previamente para autenticar peticiones urgentes o sensibles. Si el interlocutor no la conoce o duda, es una señal de alarma inmediata.

El análisis forense: las huellas digitales técnicas de la voz sintética

Cuando el oído humano llega a su límite, la ciencia toma el relevo. El análisis acústico forense utiliza herramientas computacionales para medir y visualizar características del sonido que son imperceptibles para nosotros, pero que actúan como huellas digitales para diferenciar el habla real de la sintética. Este campo se adentra en la física del sonido y aplica técnicas de procesamiento de señales y aprendizaje profundo para encontrar los patrones que delatan al algoritmo. Esta sección profundiza en los métodos técnicos y científicos que sustentan la detección automática, adoptando un enfoque más técnico.

Introducción al análisis acústico forense

La acústica forense es la disciplina que aplica la ciencia del sonido a investigaciones legales. Tradicionalmente se ha usado para identificar hablantes o verificar la autenticidad de una grabación. Con el auge de los *deepfakes*, su rol se ha expandido para incluir la detección de manipulación por IA. El principio fundamental es que, aunque un modelo de IA pueda imitar el resultado perceptible del habla (las palabras), a menudo falla en replicar el proceso físico subyacente con todas sus micro-irregularidades. Los expertos en este campo no solo escuchan, sino que analizan la "anatomía" de la onda sonora en busca de inconsistencias.

El proceso implica descomponer la señal de audio en sus componentes fundamentales y analizar sus propiedades estadísticas y espectrales. Se buscan patrones que se desvíen de la norma biológica. Mientras que una voz humana es producto de un sistema complejo y algo caótico (flujo de aire, vibración de tejidos, resonancia en cavidades), una voz sintética es el resultado de un modelo matemático que, por muy avanzado que sea, tiende a la regularidad o a cometer errores de un tipo muy particular.

Análisis de características acústicas basadas en la percepción auditiva

La investigación académica, especialmente en el campo de la defensa contra ataques de voz *deepfake*, se ha centrado en un conjunto de características acústicas que están íntimamente ligadas a la fisiología y percepción del habla. Un estudio exhaustivo publicado en el IEICE Transactions on Information and Systems clasifica estas características en varios grupos clave, que se han convertido en el estándar de facto para la detección.

Jitter y Shimmer (Fluctuación y Brillo)

Estos dos parámetros son quizás los indicadores más potentes de la naturalidad de una voz. Miden las micro-irregularidades inherentes a la vibración de las cuerdas vocales humanas.

- Jitter (Fluctuación): Se define como la variabilidad o perturbación en la frecuencia fundamental (F0) de la voz entre ciclos de vibración consecutivos. En términos sencillos, mide las minúsculas variaciones en el tono de la voz. Una voz humana siempre presenta un cierto nivel de jitter debido a la imposibilidad de mantener una vibración perfectamente constante.

- Shimmer (Brillo): De forma análoga, el shimmer mide la variabilidad en la amplitud (intensidad o volumen) de la voz entre ciclos consecutivos. Refleja las pequeñas fluctuaciones en la energía del flujo de aire que atraviesa la glotis.

¿Por qué son indicadores clave? Porque los modelos de IA tienen dificultades para replicar estos patrones de forma realista. Una voz sintética puede presentar un jitter y shimmer demasiado bajos (sonando excesivamente estable y robótica) o, por el contrario, patrones de inestabilidad que no se corresponden con los de un humano. El citado estudio demuestra que el análisis de estas perturbaciones de amplitud y frecuencia (conocidas como AFP) y su fusión con modelos de Deep Learning, como redes LCNN-BLSTM, mejora significativamente la tasa de detección de *deepfakes*. Otra investigación reciente confirma que Jitter y Shimmer se encuentran entre las características prosódicas con mayor impacto en la decisión de un modelo detector.

En el gráfico adjunto, se puede observar una representación conceptual de cómo se comportan el Jitter y el Shimmer. La voz humana muestra una variabilidad natural y contenida. En cambio, una voz de IA de baja calidad puede ser excesivamente estable (valores muy bajos), mientras que una IA que intenta simular naturalidad puede introducir artefactos que resultan en picos de variabilidad anómalos y poco realistas. El análisis de estas distribuciones es una poderosa herramienta forense.

Atributos tímbricos

El timbre es lo que nos permite distinguir entre un violín y una trompeta tocando la misma nota con la misma intensidad. Es el "color" o la "calidad" del sonido, y está determinado por la composición armónica de la señal. El análisis forense descompone el timbre en una serie de atributos perceptuales que, en conjunto, definen la textura de una voz. El proyecto Audio Commons ha estandarizado la extracción de varios de estos atributos, que son utilizados para detectar voces sintéticas:

- Dureza (Hardness): La sensación de un sonido percusivo y metálico.

- Profundidad (Depth): La percepción de que el sonido emana de una fuente grande, asociada a la presencia de bajas frecuencias.

- Brillo (Brightness): La claridad y vivacidad del sonido, relacionada con la energía en las altas frecuencias.

- Aspereza (Roughness): Una sensación de zumbido o textura áspera, causada por rápidas fluctuaciones de amplitud.

- Calidez (Warmth): Una cualidad agradable asociada a una rica estructura de armónicos medios y bajos.

Los modelos de IA pueden replicar el tono y el ritmo básicos de una persona, pero recrear la interacción compleja y dinámica de todos estos atributos tímbricos que conforman una voz natural y emocionalmente resonante es un desafío mucho mayor. Los estudios demuestran que el análisis individual de estas características, como la "profundidad", puede alcanzar una precisión de detección superior al 77%.

Análisis espectral y de formantes

El espectrograma es una herramienta visual fundamental en el análisis de audio. Representa la energía de una señal de voz a lo largo del tiempo (eje X) y la frecuencia (eje Y), usando colores para indicar la intensidad. Para un analista forense, un espectrograma puede revelar mucho sobre el origen de una voz.

Un análisis forense riguroso busca "inconsistencias espectrales: discontinuidades o patrones de energía poco naturales en el espectrograma" como una de las principales marcas técnicas de una voz sintética. – Perite.pro, Análisis Acústico Forense

Dentro del espectro, los formantes son de especial interés. Son picos de energía concentrada en ciertas frecuencias, determinados por la forma del tracto vocal. Los formantes son los que nos permiten distinguir las vocales (la 'a', la 'e', la 'i' tienen estructuras de formantes diferentes). En el habla humana, la transición entre formantes es fluida pero imperfecta. En una voz de IA, estos formantes pueden ser anómalamente "perfectos", estables o mostrar transiciones abruptas y poco naturales que no se corresponden con la fisiología humana. La "perfección anómala en los formantes" es, por tanto, otra huella digital del algoritmo.

Puntos clave del análisis forense

- El análisis forense va más allá de la escucha, midiendo características físicas del sonido.

- Jitter y Shimmer son indicadores cruciales de la micro-variabilidad natural del habla humana, algo que la IA lucha por replicar de forma auténtica.

- Los atributos tímbricos (dureza, brillo, etc.) describen la "textura" de la voz, y su compleja interacción es difícil de sintetizar.

- El análisis espectral mediante espectrogramas puede revelar patrones de energía antinaturales, discontinuidades y formantes demasiado "perfectos".

Combatir IA con IA: herramientas y modelos de detección automática

Dado que el oído humano es falible y el análisis forense manual es lento y costoso, la defensa más escalable contra los *deepfakes* de voz consiste en utilizar la misma tecnología que los crea: la inteligencia artificial. El campo de la detección automática se basa en entrenar modelos de *Machine Learning* para que actúen como "sabuesos" digitales, capaces de identificar los patrones técnicos de la síntesis de voz a una velocidad y escala imposibles para un ser humano.

El paradigma de la detección basada en Machine Learning

El concepto es sencillo en su planteamiento pero complejo en su ejecución. Consiste en alimentar a un algoritmo de aprendizaje (un clasificador) con una vasta cantidad de datos de audio, etiquetando cada muestra como "real" o ";sintética". A través de este proceso de entrenamiento, el modelo aprende a discernir las características estadísticas y espectrales que diferencian ambos tipos de audio. Con el tiempo, puede generalizar este conocimiento para clasificar nuevas muestras de audio que nunca antes ha "escuchado".

La eficacia de estos detectores depende de dos factores clave: la calidad y diversidad de los datos de entrenamiento y la sofisticación de la arquitectura del modelo. Las arquitecturas de *Deep Learning* (aprendizaje profundo) más comunes en este campo, según investigaciones de vanguardia, incluyen:

- Redes Neuronales Convolucionales (CNN): Originalmente diseñadas para el análisis de imágenes, las CNN son extremadamente eficaces para analizar espectrogramas. Tratan la representación tiempo-frecuencia del audio como una imagen, utilizando filtros para detectar patrones locales, texturas y formas (como las bandas de formantes o artefactos espectrales) que pueden delatar a una voz sintética.

- Redes Neuronales Recurrentes (RNN) y LSTM: A diferencia de las CNN, las RNN y sus variantes más avanzadas como las *Long Short-Term Memory* (LSTM) están diseñadas para procesar datos secuenciales. Analizan el audio como una serie temporal, capturando las dependencias y la evolución de las características a lo largo del tiempo, lo que las hace ideales para analizar el ritmo, la cadencia y otras características prosódicas.

- Transformers: Son la arquitectura más moderna y potente. Gracias a sus mecanismos de "atención", los Transformers pueden analizar la totalidad de una secuencia de audio a la vez, capturando relaciones a largo plazo entre diferentes partes del discurso de manera muy eficiente. Esto les permite detectar inconsistencias sutiles que podrían pasar desapercibidas para otros modelos.

A menudo, los sistemas más avanzados combinan estas arquitecturas en modelos híbridos (por ejemplo, CNN-LSTM) para aprovechar tanto el análisis espacial del espectrograma como el análisis temporal de la secuencia.

Catálogo de herramientas de detección

El mercado de la detección de *deepfakes* está en plena ebullición, con soluciones que van desde herramientas gratuitas de acceso público hasta plataformas empresariales de alta seguridad. A continuación, se presenta una clasificación de algunas de las herramientas más destacadas:

Plataformas "todo en uno" (Generación y Detección)

Irónicamente, algunas de las mejores herramientas de detección provienen de las mismas empresas que lideran la generación de voz sintética. Motivadas por la necesidad de combatir el uso malicioso de su propia tecnología, han desarrollado clasificadores robustos.

- ElevenLabs AI Speech Classifier: Creada por ElevenLabs, una de las plataformas de clonación de voz más populares y potentes (usada en el caso de la robocall de Biden), esta herramienta está diseñada específicamente para identificar audio generado por su propia tecnología. Según análisis del sector, es una de las soluciones más avanzadas para la clonación y detección.

- Resemble AI Detect: Resemble AI ofrece tanto generación de voz como una herramienta de detección llamada *Detect*. Presume de una precisión superior al 98% y funciona analizando el audio en busca de pistas sutiles de fabricación a nivel de tiempo-frecuencia, creando incrustaciones similares a espectrogramas que luego son evaluadas por un clasificador.

Soluciones de seguridad y forenses

Estas herramientas están orientadas a empresas, gobiernos y profesionales forenses, ofreciendo análisis en tiempo real, monitoreo a gran escala e integración con flujos de trabajo de seguridad.

- Sentinel: Es una solución basada en la nube que ofrece detección de *deepfakes* en tiempo real. Según descripciones técnicas, utiliza una combinación de algoritmos avanzados, incluyendo análisis de puntos de referencia faciales (en vídeo), comprobaciones de coherencia temporal y detección de parpadeo, aplicables también a la consistencia del audio.

- Sensity: Esta plataforma se especializa en el monitoreo en tiempo real de grandes volúmenes de contenido online. Es utilizada por agencias gubernamentales y grandes corporaciones para identificar campañas de desinformación visual y auditiva a escala .

- Sonix.ai: Enfocada específicamente en el sector legal y forense, Sonix no solo transcribe audio, sino que ofrece funciones clave para la autenticación, como identificación avanzada de hablantes y sellado de tiempo (timestamping) de alta precisión para cada palabra. Su arquitectura está diseñada con seguridad de nivel empresarial para garantizar la integridad de las pruebas.

Herramientas de acceso público

Para usuarios individuales o pequeñas empresas, existen opciones gratuitas que permiten un primer nivel de verificación.

- Undetectable AI Voice Detector: Esta herramienta se promociona como una solución gratuita y fácil de usar. Según su propia descripción, funciona con clips de audio cortos (incluso de 7 segundos), soporta múltiples formatos (MP3, WAV, notas de WhatsApp, etc.) y puede detectar voces clonadas de plataformas populares como ElevenLabs.

La importancia de la verificación cruzada

A pesar de la sofisticación de estas herramientas, los expertos son unánimes en su advertencia: no se debe confiar ciegamente en el veredicto de un único detector. La naturaleza cambiante de los modelos generativos significa que ninguna herramienta es infalible.

"Los resultados deben considerarse solo una pista inicial, no como prueba definitiva. Ninguna herramienta debe ser usada como único criterio, lo ideal es combinar los resultados con la evaluación de un perito especializado en acústica forense." – Experta citada en Yahoo Noticias

La recomendación profesional es clara: si la autenticidad de un audio es crítica, se debe practicar la verificación cruzada. Esto implica procesar el mismo archivo de audio a través de múltiples detectores y comparar los resultados. Si varias herramientas de diferentes proveedores coinciden en que el audio es probablemente sintético, el nivel de confianza en esa conclusión aumenta significativamente. Sin embargo, incluso en ese caso, el resultado debe ser tratado como un indicador fuerte, no como una certeza absoluta, especialmente en contextos legales donde el estándar de prueba es mucho más alto.

La detección es una carrera armamentista sin fin

La idea de tener un detector de *deepfakes* 100% fiable es atractiva, pero la realidad es que nos encontramos en medio de una carrera armamentista tecnológica. Por cada avance en las técnicas de detección, surge un modelo generativo más sofisticado que aprende a eludirlo. Comprender las limitaciones inherentes a la detección es fundamental para adoptar una postura realista y desarrollar estrategias de defensa efectivas. Esta sección aborda los principales obstáculos que hacen que la detección perfecta sea, por ahora, una meta inalcanzable.

El error del oído humano está científicamente probada

Aunque la escucha activa es la primera línea de defensa, la ciencia ha demostrado de manera concluyente que el oído humano ya no es un juez fiable frente a la tecnología de clonación de voz de última generación. Los modelos actuales han superado un umbral de realismo que engaña sistemáticamente nuestra percepción.

Un estudio fundamental publicado en la prestigiosa revista Nature y replicado en análisis de Lawfare Media, arrojó resultados contundentes. En un experimento, se pidió a los participantes que escucharan pares de clips de audio. Cuando se les presentó la voz real de una persona y una clonación de esa misma persona generada con ElevenLabs, los participantes juzgaron que se trataba de la misma persona en aproximadamente el 80% de las ocasiones. Es decir, fueron engañados 4 de cada 5 veces. Aún más revelador, una cuarta parte de los participantes fue engañada por cada uno de los clones de IA utilizados en el estudio.

En una segunda parte del estudio, se pidió a los oyentes que juzgaran explícitamente si un clip de audio era real o generado por IA. Aunque el rendimiento fue superior al azar (50%), la precisión media fue de solo un 64%, muy por debajo de lo que se consideraría fiable. Esto demuestra que, incluso cuando estamos prevenidos y nuestra atención está centrada en detectar el engaño, nuestra capacidad para hacerlo es limitada.

La rápida evolución de los modelos generativos

La tecnología de síntesis de voz avanza a un ritmo vertiginoso. Modelos como VALL-E de Microsoft, capaces de simular una voz con solo 3 segundos de audio de muestra , o las continuas mejoras de plataformas como ElevenLabs, están constantemente aprendiendo a corregir los artefactos que antes los delataban. Las imperfecciones prosódicas, los sonidos metálicos o la falta de "ruido" humano son problemas que los desarrolladores están abordando activamente.

Esto nos lleva a un problema crítico en el campo de la detección: la generalización. Un modelo detector se entrena con un conjunto de datos de voces sintéticas existentes en un momento dado. Sin embargo, cuando aparece un nuevo modelo generativo con una arquitectura diferente, el detector puede no ser capaz de reconocer sus patrones. Esto se conoce como un fallo en la detección *zero-shot* (detección de un tipo de ataque nunca antes visto). Como señalan investigadores en el desafío ADD2022, la aparición continua de nuevos métodos de síntesis dificulta que los modelos de detección identifiquen patrones comunes y se mantengan robustos.

El problema de los "audios híbridos" y los ataques adversariales

Los creadores de *deepfakes* no se limitan a usar la salida directa de un modelo de IA. A menudo emplean técnicas más sutiles para burlar a los detectores, creando lo que se conoce como "audios híbridos".

Un estudio sobre la lingüística forense en la era de la IA destaca que los textos (y por extensión, audios) híbridos, donde un humano edita o ajusta fragmentos del contenido generado por IA, representan uno de los mayores desafíos para los detectores actuales. Un atacante puede generar una frase con IA y luego mezclarla con una grabación real, o editar manualmente las pausas y la entonación para hacerla parecer más natural. Estas composiciones mixtas confunden a los algoritmos de detección, que están entrenados para identificar patrones de IA puros.

Además, existe el concepto de ataques adversariales. Se trata de manipulaciones sutiles y a menudo imperceptibles en la señal de audio, diseñadas específicamente para engañar a un modelo de *Machine Learning*. Un atacante puede añadir una capa de "ruido" cuidadosamente calculado que, aunque inaudible para un humano, es suficiente para que el clasificador de IA clasifique erróneamente un audio sintético como real. Esto convierte la detección en un juego del gato y el ratón, donde los atacantes explotan activamente las debilidades de los sistemas de defensa.

Limitaciones de las herramientas actuales

Incluso las herramientas de detección más avanzadas no son perfectas y presentan una serie de limitaciones inherentes que los usuarios deben conocer:

- Falsos positivos y negativos: Ninguna herramienta tiene una precisión del 100%. Un falso positivo ocurre cuando un audio humano real es incorrectamente clasificado como sintético. Esto puede tener graves consecuencias, como acusar injustamente a alguien de manipulación. Un falso negativo ocurre cuando un *deepfake* no es detectado, dando una falsa sensación de seguridad.

- Dependencia de la calidad y duración del audio: La precisión de la mayoría de los detectores disminuye con audios de corta duración, ya que hay menos datos para analizar. De manera similar, el audio de baja calidad, con mucho ruido de fondo o comprimido en exceso, puede ocultar los artefactos que los detectores buscan, o introducir nuevas distorsiones que confundan al algoritmo .

- Falta de transparencia y estándares: Muchas herramientas comerciales son "cajas negras", lo que significa que no revelan cómo funcionan sus algoritmos ni en qué datos fueron entrenados. Esta falta de transparencia, junto con la ausencia de estándares metodológicos consensuados para la evaluación, hace difícil comparar la fiabilidad real de diferentes herramientas .

Puntos clave de los desafíos de detección

- La percepción humana ya no es fiable para detectar voces sintéticas de alta calidad, con tasas de error de hasta el 80%.

- Los modelos generativos evolucionan más rápido que los detectores, creando un problema de generalización (*zero-shot*).

- Los audios híbridos (mezcla de real y sintético) y los ataques adversariales están diseñados específicamente para engañar a los algoritmos de detección.

- Las herramientas actuales tienen limitaciones, incluyendo falsos positivos/negativos y una menor precisión en audios cortos o de baja calidad.

Parte 5: El futuro de la autenticación de voz: tendencias y contramedidas

Ante la creciente sofisticación de las voces sintéticas y las limitaciones de los métodos de detección actuales, la comunidad tecnológica y de seguridad está explorando nuevas fronteras para garantizar la autenticidad en las comunicaciones por voz. El futuro no reside en una única solución mágica, sino en un enfoque multifacético que combina el análisis biométrico avanzado, contramedidas proactivas y una colaboración interdisciplinar sin precedentes.

La voz como biomarcador: el lado positivo de la IA

Paradójicamente, la misma tecnología de análisis de voz por IA que se utiliza para detectar *deepfakes* también está abriendo caminos revolucionarios en campos como la medicina. Al cambiar la perspectiva, podemos ver que la capacidad de la IA para analizar matices imperceptibles en la voz no solo sirve para detectar fraudes, sino también para identificar indicadores de salud. Esto se conoce como el estudio de la voz como biomarcador.

Investigaciones recientes, como las destacadas por Avahi.ai, han demostrado que el análisis de características vocales como el tono, el ritmo, las pausas y la tensión vocal puede detectar signos tempranos de diversas afecciones, a menudo antes de que los síntomas físicos se manifiesten:

- Enfermedad de Parkinson: Cambios en la fluidez y modulación de la voz pueden ser detectados con una precisión de hasta el 99%.

- Diabetes tipo 2: Un estudio encontró que la IA puede detectar la enfermedad con una precisión del 89% en mujeres y 86% en hombres a partir de una grabación de 6-10 segundos.

- Problemas cardiovasculares: La tensión vocal y los patrones de respiración pueden indicar afecciones cardíacas.

- Salud mental: Patrones de habla monótonos o un ritmo irregular pueden ser indicadores de depresión o ansiedad.

Este campo no solo demuestra el poder de la tecnología de análisis de voz, sino que también subraya un punto fundamental: la voz humana es un sistema biológico increíblemente complejo y rico en información. Es precisamente esta complejidad la que, por ahora, los modelos sintéticos aún no pueden replicar en su totalidad, y es en esa brecha donde residen las oportunidades para la detección.

Contramedidas tecnológicas en desarrollo

En lugar de jugar siempre a la defensiva, la industria está desarrollando contramedidas proactivas diseñadas para "marcar" el contenido sintético desde su origen o detectarlo en tiempo real.

Marcas de agua de audio (Audio Watermarking)

El concepto de marca de agua digital, utilizado durante mucho tiempo en imágenes y vídeos, se está adaptando al audio. Consiste en insertar una señal o patrón imperceptible para el oído humano dentro del archivo de audio generado por IA. Esta "marca" no afecta a la calidad del sonido, pero puede ser leída por un software específico para confirmar el origen sintético del audio.

Empresas líderes ya están implementando esta tecnología:

- Meta ha desarrollado AudioSeal, una técnica que no solo identifica un audio como generado por IA, sino que puede detectar qué partes específicas de una grabación han sido alteradas .

- Microsoft, en su característica de "Voz Personal", agrega marcas de agua a las voces neuronales personalizadas que se crean, permitiendo identificar si la voz fue sintetizada con Azure AI Speech.

La principal limitación de este enfoque es que depende de la cooperación de los desarrolladores. Los actores maliciosos simplemente migrarán a herramientas de código abierto o plataformas que no implementen este protocolo de seguridad, como advierte el estudio de Nature.

Desarrollo de detectores en tiempo real

La mayoría de las técnicas forenses operan de forma asíncrona, es decir, analizan un archivo de audio después de que ha sido grabado. El gran desafío es desarrollar sistemas que puedan operar en tiempo real, durante una llamada telefónica o una videollamada. Esto plantea enormes retos técnicos en términos de latencia (el análisis debe ser casi instantáneo) y precisión. Además, como señalan los investigadores, surgen serias preocupaciones sobre la privacidad, ya que un sistema de este tipo necesitaría analizar el flujo de audio de la llamada en vivo. Un sistema de este tipo tendría que tener una precisión extremadamente alta para evitar tanto las falsas alarmas como el dar una falsa sensación de seguridad.

La necesidad de un enfoque multidisciplinar

La complejidad del problema de los *deepfakes* de voz trasciende la tecnología. Una defensa robusta requiere una colaboración estrecha y continua entre diferentes campos del conocimiento. Como concluye un artículo sobre los retos de la lingüística forense, la evolución en esta era no es opcional, sino una necesidad urgente.

- Colaboración interdisciplinar: Lingüistas forenses, expertos en IA, científicos de datos, juristas y legisladores deben trabajar juntos. Los lingüistas aportan el conocimiento profundo del habla humana; los ingenieros de IA construyen los modelos; y los expertos legales establecen los marcos para que las pruebas sean admisibles y se utilicen de forma ética en los tribunales.

- Creación de estándares y marcos legales: Actualmente, no existe un consenso global sobre las metodologías o los estándares para el análisis de pruebas generadas por IA. Es imperativo desarrollar protocolos replicables y validados que puedan ser aceptados en investigaciones judiciales. Organizaciones como la UNESCO ya están promoviendo directrices para que la adopción de IA en los tribunales respete los derechos humanos y garantice la equidad.

- Formación y concienciación: Los profesionales de sectores críticos (banca, legal, periodismo) y el público en general necesitan formación para entender tanto las capacidades como los riesgos de esta tecnología. La concienciación es un componente clave de la defensa.

Conclusión: escepticismo y verificación como la mejor defensa

Nos encontramos en un punto de inflexión. Las voces generadas por inteligencia artificial han alcanzado un nivel de realismo que desafía nuestra percepción y pone en jaque los cimientos de la confianza en las comunicaciones digitales. Como hemos explorado, aunque estas voces son cada vez más indistinguibles para el oído no entrenado, todavía dejan huellas, tanto auditivas como técnicas. La detección se ha convertido en un ejercicio complejo que combina la escucha crítica, centrada en las anomalías de la prosodia y la ausencia de imperfecciones humanas, con el análisis técnico de características como el jitter, el shimmer y los patrones espectrales.

Sin embargo, es crucial aceptar la realidad de la situación: la detección es una carrera armamentista sin una línea de meta clara. La sofisticación de los modelos generativos avanza a un ritmo implacable, y por cada nueva técnica de detección, surge una contramedida. No existe, ni existirá en el futuro previsible, una solución infalible o un "detector de verdad" mágico. La falibilidad del oído humano ha sido probada, y las herramientas automáticas, aunque potentes, tienen sus propias limitaciones, especialmente frente a audios híbridos y ataques adversariales.

Ante este panorama, la estrategia de defensa más robusta y universalmente aplicable no es tecnológica, sino humana. Se basa en dos pilares fundamentales: el escepticismo informado y la verificación por canales alternativos. Debemos abandonar la suposición de que lo que oímos es necesariamente auténtico y adoptar una mentalidad de verificación por defecto, especialmente cuando la comunicación implica peticiones sensibles, urgentes o emocionalmente cargadas.

La llamada a la acción es, por tanto, sorprendentemente analógica en un mundo digital. Ante la más mínima duda, ante una petición de dinero, una contraseña o una acción inusual, la tecnología más fiable a nuestra disposición sigue siendo colgar el teléfono y devolver la llamada a un número de confianza que tengamos verificado previamente. En la era de la voz sintética, el escepticismo no es pesimismo, sino una forma esencial de prudencia digital. La verdad ya no solo se escucha; se verifica.

¿Y si la voz que reconoce el deepfake es también un deepfake?

Entonces, ¿Cómo sabes si este comentario no es un deepfake? ¡Todo es posible!

Ah, pues me ha dejado pensando este artículo, ¿eh? No sé, igual me estoy liando, pero parece que buscar señales auditivas para detectar un deepfake de voz es más complejo de lo que creía. Por cierto, ¿esas pruebas técnicas de las que hablan son accesibles para todos? Ahora que lo pienso, sería genial que las estrategias para usuarios fueran más simples. O sea, ¿no están pidiendo un poquito demasiado de nosotros, los ciudadanos curiosos? Y bueno, ¿cómo podríamos hacer esas pruebas más sostenibles?

¿No creen que las pruebas técnicas deberían ser más accesibles para el público general? Es fundamental para identificar los deepfakes.

Totalmente de acuerdo, la lucha contra los deepfakes es responsabilidad de todos.

¿No creen que en lugar de evitarlos, deberíamos aprender de los deepfakes?

Absolutamente, los deepfakes son una amenaza real, pero también una oportunidad para aprender.

¿No creen que la IA por voz puede ser beneficiosa en ciertos aspectos, a pesar de los riesgos de deepfakes de voz?

Claro, la IA por voz puede ser útil, pero el riesgo de deepfakes sigue siendo preocupante.

Interesante artículo, pero ¿realmente podemos confiar en las pruebas técnicas para detectar deepfakes de voz? Parece un desafío enorme.

Claro, es un desafío, pero ¿no es mejor intentar luchar contra los deepfakes que rendirse?

¿Realmente creen que un usuario promedio tiene tiempo para analizar deepfakes de voz?

No todos somos expertos, pero el sentido común y la cautela nunca sobran.

¿No creen que las estrategias para usuarios deberían estar enfocadas en prevenir en lugar de solo reconocer deepfakes de voz?

Totalmente de acuerdo. Prevenir siempre será mejor que curar en el tema de deepfakes.

¿Y si en realidad los deepfakes son solo una exageración mediática? ¿Alguna prueba real?

Vaya, este artículo sobre cómo reconocer un agente de IA por voz me ha dejado pensando. Me parece curioso lo de las señales auditivas y las pruebas técnicas, aunque, a ver, no sé si yo sería capaz de detectar un deepfake de voz en el acto. ¿Vosotros creéis que es fácil? Y, por cierto, igual me estoy liando, pero no acabo de pillar cómo se aplican estas estrategias para los usuarios normales… ¿Alguien podría explicarme un poco más?

Hombre, la verdad es que esto de detectar la IA por voz me parece un tema complejo. Es como… como un juego de detectives, ¿no? Mirando las señales auditivas y todo eso. ¿Y las pruebas técnicas? Vaya, me he quedado un poco pillado, la verdad. No sé, igual me estoy liando pero ¿no es un poco paranoico esto de andar desconfiando de cada voz que escuchamos? ¿Y si la tecnología simplemente avanza y ya está? Por cierto, ¿cómo creéis que este avance afectará a nuestra comunicación cotidiana?

¿No creen que deberíamos ir un paso más allá y exigir que los agentes de IA se identifiquen automáticamente? ¡Evitaríamos tantos problemas!

¿Y qué si prefiero interactuar con IA sin saberlo? ¡Deberíamos tener esa libertad!

¿No creen que la verdadera pregunta es cómo garantizar la seguridad de nuestros datos ante estos agentes de IA por voz?

Mmm, este artículo sobre cómo identificar a un agente de IA por voz es un poco complicado, ¿no? Sí, me refiero a la parte de las pruebas técnicas, creo que lo entendí bien… pero, ¿todos tendríamos que convertirnos en expertos en sonido para detectar un deepfake, no? Por cierto, me ha dejado pensando eso de las estrategias para usuarios. ¿Crees que se están tomando suficientes medidas para protegernos del impacto de estas IA?

Pues, por cierto, nunca me había parado a pensar en las señales auditivas que mencionan en el artículo para detectar un deepfake de voz. Aunque, igual me estoy liando, ¿no creéis que algunas pruebas técnicas podrían ser demasiado complicadas para el usuario medio? Ahora que lo pienso, ¿no sería más sencillo que las empresas de tecnología se encargaran de esto en vez de los usuarios? Además, ¿qué hay de la sostenibilidad de estas estrategias a largo plazo? No sé, solo pregunto.

¿No creen que es más fácil simplemente no creer en nada online?

¿No creen que las pruebas técnicas para detectar deepfakes de voz deberían ser más accesibles para el usuario promedio?

¿Por qué no usar deepfakes para imitar a famosos en audiolibros? Sería genial.

Porque imitar sin permiso es invasión de privacidad, ¿no crees?

Vaya, este artículo sobre cómo reconocer un agente de IA por voz es bastante interesante, ¿no? Me ha llamado la atención eso de las señales auditivas. Ahora que lo pienso, me pregunto cómo serían esas pruebas técnicas en la vida real… Por cierto, tengo una duda, ¿cómo distingo una voz deepfake en una llamada telefónica? Y, ¿qué papel juegan las estrategias para usuarios en todo esto? Igual me estoy liando un poco, pero parece un tema clave para la sostenibilidad digital, ¿verdad?

¿No sería más útil enfocarnos en cómo prevenir la creación de deepfakes en lugar de aprender a reconocerlos?

Oye, ¿no os parece un poco… no sé, escalofriante esto de los deepfakes de voz? En serio, es como algo sacado de una peli de ciencia ficción. Pero bueno, lo que me resultó interesante del artículo es cómo nos enseña a detectar estas cosas. Las señales auditivas, las pruebas técnicas, todo eso. Ahora que lo pienso, ¿qué tan efectivas son estas estrategias para usuarios normales como yo? Y además, ¿no os parece que deberíamos centrarnos más en prevenir que estos deepfakes se creen en primer lugar? No sé, igual me estoy liando.

Muy interesante el artículo, pero ¿realmente las pruebas técnicas son suficientes para detectar un deepfake de voz? 🤔

¿Y si en lugar de identificarlos, empezamos a disfrutar las IAs por voz?

Hmm, vale, creo que estoy entendiendo un poco mejor esto de los agentes de IA por voz. Me ha dejado pensando el rollo ese de las señales auditivas, o sea, ¿cómo distingo yo una voz humana de una IA? ¿Es algo que se pueda aprender o requiere de un oído súper entrenado? Ah, y por cierto, las pruebas técnicas que mencionan, ¿son realmente accesibles para un usuario medio? Igual me estoy liando, pero, ¿no sería más fácil que las empresas de IA se encargaran de esto?

¿No creen que, en lugar de enseñarnos a reconocer deepfakes, deberían trabajar en impedir su creación? Solo una idea.

¿Y limitar la innovación tecnológica? ¿No sería eso censura? ¡Piénsalo bien!

Vaya, este artículo sobre cómo reconocer agentes de IA por voz es, digamos, bastante interesante, ¿verdad? Pero, por cierto, ¿no es un poco inquietante pensar en la sostenibilidad de estas pruebas técnicas? Me refiero a, ¿qué pasa si los deepfakes mejoran y se vuelven indetectables? Y bueno, hablando de las estrategias para los usuarios, ¿pensáis que son lo suficientemente efectivas en un contexto real? Ahora que lo pienso, igual me estoy liando un poco, ¿no?

Mmm, este tema de los deepfakes de voz… Es complicado, ¿no? Por un lado, veo que técnicamente son muy avanzados. Buah, me resulta fascinante cómo usan esas señales auditivas para engañarnos. Por otro, me pregunto cómo podemos protegernos. ¿No sería mejor que los usuarios normales tuviéramos más estrategias para reconocerlos? Ah, y otra cosa, me parece curioso que no hablen del impacto en la sostenibilidad. ¿Qué pasa con el consumo energético de estas tecnologías? ¿No deberíamos preocuparnos por eso también?

¿No creen que las estrategias para usuarios deberían ser más simplificadas? A veces parecen más complicadas que el propio deepfake.

Claro, pero a veces la complejidad garantiza una mayor seguridad. ¿No crees?

Ostras, este artículo sobre reconocer a un agente de IA por voz me ha dejado un poco… ¿cómo decirlo? ¿Intrigado? Eso de las señales auditivas y las pruebas técnicas me parece bastante chungo, la verdad. ¿No es un poco paranoico pensar que cada voz que oímos podría ser un deepfake? Pero, por otro lado, supongo que es el mundo en el que vivimos ahora. ¿Y qué me decís de las estrategias para usuarios? ¿Creéis que realmente podemos protegernos de estas cosas? No sé, igual me estoy liando.

¿No creen que las estrategias para usuarios deberían enfocarse más en educación sobre IA y menos en pruebas técnicas?

Vaya, eso de reconocer un deepfake de voz en breve me tiene pensando, ¿sabes? No soy ningún experto, pero ¿no será un poco exagerado? Quiero decir, claro, esas señales auditivas y pruebas técnicas que mencionan tienen sentido, pero igual me estoy liando, ¿no se necesita mucho conocimiento técnico para eso? Y por cierto, ¿cómo se supone que un usuario promedio va a aplicar estas estrategias? No sé, quizás estoy viendo esto desde una perspectiva equivocada. ¿Vosotros qué opináis?

¿Y si los deepfakes de voz son el futuro de la comunicación? 🤔🙃

¿No sería más útil enseñar a la IA a detectar deepfakes en lugar de poner esa responsabilidad en los usuarios?

Claro, pero también es nuestro deber estar informados y alertas. ¿No crees?

¡Vaya, este artículo es un viaje, eh! Bueno, a ver si lo he pillado bien. Habla de que podemos reconocer a los deepfakes de voz por ciertas señales auditivas, ¿no? Pero, ahora que lo pienso, ¿no sería más fácil hacer pruebas técnicas? Y hablando de eso, mencionan algo de estrategias para usuarios, ¿como qué, por ejemplo? Por cierto, me ha hecho pensar en cómo esto afecta a todo el rollo de la sostenibilidad y el impacto. Igual me estoy liando, pero, ¿esto no podría ser un poco peligroso a largo plazo?

¿Y si los deepfakes son simplemente la próxima etapa de la evolución AI?

¿No creen que deberíamos enfocarnos en cómo usar la IA para beneficio de todos en lugar de temer a los deepfakes de voz?

Totalmente de acuerdo, la IA puede ser una herramienta, no un enemigo.

¿Y si ya estamos interactuando con IAs sin darnos cuenta? ¡Es inquietante!

¿Y si los deepfakes de voz son realmente una evolución positiva? 🤔💡

¿Positiva? Imagina el caos si nadie pudiera confiar en lo que escucha. 🙄💔

¿Y si en realidad estamos todos hablando con deepfakes y no nos damos cuenta? ¿Eh?

¿Y si tú eres un deepfake y no te das cuenta? ¡Piénsalo!

¿Y si los deepfakes de voz son el futuro de la comunicación? ¡Debatamos!

¿Futuro de la comunicación? Tal vez, pero ¿a qué coste para nuestra privacidad?

Este artículo me ha dejado pensando… Siempre he tenido curiosidad sobre los deepfakes de voz y cómo reconocerlos. Las señales auditivas y las pruebas técnicas son claves, pero, ¿qué pasa si no tienes un oído entrenado para estas cosas? Creo que las estrategias para usuarios deberían ser más accesibles para todos, o al menos eso me parece a mí. ¿No creen? ¿Cómo se supone que un usuario promedio se defienda de esto? En fin, interesante pero complejo.

Vaya, no tenía ni idea de que los deepfakes de voz estuvieran tan avanzados. Me parece un poco inquietante, la verdad. ¿Qué pasa si no estoy atento a las señales auditivas? No todo el mundo tiene un oído tan afinado. ¿Y las pruebas técnicas? ¿Se supone que debo hacer un análisis de audio cada vez que recibo una llamada sospechosa? No sé, me parece que aún queda mucho camino por recorrer en este tema.

Vaya, nunca me había parado a pensar en esto de los deepfakes de voz, es un poco aterrador, ¿no? ¿Quién me dice a mí que no estoy hablando con una IA y no con una persona real? ¿Y cómo puedo hacer pruebas técnicas por mi cuenta para descubrirlo? No me queda claro eso. En fin, cosas de la tecnología, supongo.

Este artículo me ha hecho pensar… siempre asumimos que estamos hablando con una persona real cuando usamos Siri o Alexa. Pero, ¿qué pasaría si en vez de un asistente, estuviéramos hablando con un deepfake de voz? Según lo que entiendo, las señales auditivas pueden ser un poco truculentas. ¿Y las pruebas técnicas? ¿Cómo deberíamos aplicarlas como usuarios normales? Es todo un nuevo mundo, ¿no creen?

Esto de los deepfakes de voz me parece un tema muy serio, la verdad. Me resulta inquietante que alguien pueda falsificar mi voz y hacer que diga cosas que yo no he dicho. No sé, igual me estoy liando, pero ¿no podría eso usarse para cometer fraudes o algo así? Y lo de las señales auditivas, no lo veo nada claro, ¿cómo podría yo distinguir una voz real de una falsa? Es todo muy raro, la verdad.

Esto de los deepfakes de voz me parece un poco aterrador, la verdad. ¿Cómo se supone que vamos a diferenciar entre una voz real y una falsa? Y lo peor es que parece que la tecnología avanza más rápido de lo que nosotros podemos aprender a detectar estas cosas. ¿Hay alguna forma más sencilla para que el usuario medio pueda reconocer estos deepfakes?

A ver, lo de las Señales auditivas me ha dejado un poco confundido. ¿Entonces cualquier ruido extraño puede ser señal de un deepfake de voz? Y sobre las Pruebas técnicas, no sé, igual me lio, pero me parecen un poco complicadas para el usuario medio, ¿no? No sé, quizás solo sea yo. En fin, Estrategias para usuarios parece lo más práctico de todo. ¿Alguien ha probado alguna de estas?

Interesante lo de las Señales auditivas para detectar un deepfake de voz. Pero me queda la duda, ¿cómo se supone que uno se da cuenta de las inflexiones o ritmo inadecuado en una conversación normal? No todos somos expertos en lingüística. Y, ¿qué pasa con las Pruebas técnicas? ¿Necesito ser un genio de la informática para hacer eso?

Bueno, este tema siempre me ha dado un poco de yuyu. Lo de los deepfakes de voz es que me parece de ciencia ficción. No sé, igual soy un poco paranoico, pero me preocupa que alguien pueda imitar mi voz y hacerme pasar por algo que no he dicho. ¿Y si las pruebas técnicas fallan? ¿Cómo nos protegemos entonces? Es flipante cómo avanza la tecnología, pero a veces me asusta un poco, la verdad.

Me ha dejado un poco paranoico lo de los deepfakes de voz, la verdad. ¿Entonces, cualquier llamada que reciba podría ser de un bot? Eso de las señales auditivas está bien, pero ¿qué pasa si yo no tengo oído para esas cosas? Y las pruebas técnicas, espero que no sean muy complicadas… En fin, vivir en la era digital, chicos.

Este artículo me ha hecho pensar, ¿qué tan avanzados están realmente los deepfakes de voz? No me había parado a pensar en las señales auditivas hasta leer esto. Ahora me pregunto cómo distinguiría yo una voz falsa de una real, ¿hay algún truco fácil para la gente que no somos expertos en esto? En fin, parece que la tecnología avanza a pasos agigantados y nos deja a muchos atrás.

Vaya, no tenía ni idea de que los deepfakes de voz eran una cosa hasta ahora. ¿Entonces la idea es que hay ciertas señales auditivas que nos pueden ayudar a identificar cuando una voz ha sido falsificada? Aunque me pregunto, ¿qué tan efectivas serán estas pruebas técnicas para el usuario medio? No sé, me parece todo un poco complicado pero bueno, supongo que es mejor estar informado que no saber nada.

Interesante lo de las señales auditivas para detectar un deepfake de voz, aunque me parece un poco técnico. ¿Hay alguna forma más sencilla para los que no somos expertos? Por otro lado, las estrategias para usuarios me parecen útiles, pero, ¿son realmente efectivas contra los deepfakes más avanzados? En fin, la IA no deja de sorprenderme.

Vaya, nunca había pensado en lo complicado que puede ser reconocer un deepfake de voz, me ha dejado algo paranoico este artículo. ¿Pero realmente las señales auditivas son tan fiables? Imagino que los deepfakes también irán mejorando con el tiempo, ¿no? No sé, igual me estoy liando yo solo… En fin, supongo que al final el mejor consejo es el de siempre: sentido común y no creerse todo lo que se escucha.

Vaya, me ha sorprendido lo de que se pueden detectar deepfakes de voz por señales auditivas. Siempre pensé que era cosa de expertos con equipos caros. Aunque no entiendo muy bien cómo funcionan las pruebas técnicas, ¿alguien me lo puede explicar un poco más? Buen artículo de todas formas, me ha hecho pensar.

¿Entonces se supone que hay que estar siempre alerta de si hablamos con una IA o una persona real? Me parece un poco paranoico, la verdad. Aunque no niego que lo de los deepfakes de voz es preocupante. ¿Cómo puedo hacer una prueba técnica si sospecho? No me ha quedado muy claro.

La verdad es que este tema de los deepfakes de voz me parece alucinante, pero también bastante aterrador. ¿Cómo se supone que vamos a saber qué es real y qué no? En fin, supongo que estas señales auditivas y pruebas técnicas que mencionan pueden ayudar, pero tampoco lo veo tan claro. ¿Y si la IA aprende a superar estas pruebas? ¿Entonces qué?

Muy interesante esto de los deepfakes de voz, la verdad. Nunca me había parado a pensar en las señales auditivas que podrían delatarlos. Pero me ha quedado una duda… ¿Cómo se supone que un usuario normal y corriente puede hacer esas pruebas técnicas? A ver, que me he enterado de lo que son, pero no tengo ni idea de cómo hacerlas. ¿Algún consejo para los que somos un poco novatos en esto?

Pues la verdad, nunca me había parado a pensar en lo fácil que puede ser engañarnos con un deepfake de voz, es un poco inquietante. Aunque me quedo con dudas, ¿cómo va eso de las señales auditivas? No sé, igual me lío, pero ¿no se supone que son casi perfectas? Y otra cosa, si te encuentras con uno, ¿qué se puede hacer? A ver si alguien me aclara esto un poco más.

Interesante esto de los deepfakes de voz. No me había parado a pensar en las señales auditivas para reconocerlos. Eso de las pruebas técnicas suena complicado, ¿no? Más allá de la teoría, ¿cómo se aplicaría eso en la vida diaria? ¿Algún experto que me dé un consejo práctico?

Vaya, esto de reconocer un deepfake de voz parece complicado, ¿no? No sé, yo no me veo capaz de detectar esas señales auditivas que mencionan. Me pregunto si las pruebas técnicas serán más fiables… Pero bueno, algo es algo. Al menos nos dan algunas estrategias para los usuarios, aunque no parecen infalibles. ¿Alguien ha probado alguna de estas tácticas? ¿Funcionan de verdad?

Muy interesante lo de las señales auditivas para detectar deepfakes, no lo tenía nada claro. Pero, ¿qué pasa si la IA se perfecciona más y esas señales ya no son tan obvias? Me pregunto si habrá siempre una forma de distinguir lo falso. A lo mejor nos toca aprender estrategias nuevas para mantenernos al día, ¿no?