La inteligencia artificial se ha colado en despachos de abogados y en consultas ciudadanas sobre pensiones. Pero cuando sustituye a la verificación humana, el resultado puede ser devastador: desde sanciones judiciales hasta jubilaciones arruinadas.

La lección de Mata v. Avianca: el juez no sanciona a la máquina

En 2023, el caso Mata v. Avianca, Inc. se convirtió en un símbolo global del uso negligente de la IA en la abogacía. Un abogado del demandante recurrió a ChatGPT para encontrar jurisprudencia que reforzara un escrito de oposición en una demanda contra la aerolínea. El chatbot le proporcionó una lista de casos con nombres, números de expediente y extractos de sentencias que parecían perfectamente auténticos.

El problema es que esos casos nunca habían existido. Cuando los abogados de la contraparte y el juez intentaron localizar las resoluciones en bases como Westlaw o LexisNexis, comprobaron que no había rastro de ellas. En lugar de detenerse ahí, el letrado cometió un segundo error: volvió a consultar a ChatGPT para “verificar” la información. La IA confirmó con total seguridad que los casos eran reales y que estaban disponibles en las bases oficiales, lo que llevó al abogado a presentar nuevos documentos con extractos aún más elaborados… pero igualmente ficticios.

El juez Kevin Castel reaccionó con contundencia. Impuso una sanción económica al abogado y a su firma, y dejó escrito que habían abandonado su deber de diligencia al no comprobar por sí mismos la existencia de las sentencias. Artículos de análisis jurídico señalan que el tribunal no sancionó el uso de IA en sí, sino la sustitución del criterio profesional por la confianza ciega en una herramienta que puede “alucinar” información plausible pero falsa.

La IA como becario, no como socio

El consenso entre expertos es claro: la IA puede ser útil como apoyo, por ejemplo, para generar borradores, explorar posibles argumentos o resumir documentos extensos. Pero no puede ocupar el lugar de las bases de datos oficiales, la lectura directa de sentencias o el juicio jurídico del profesional. La responsabilidad frente al cliente y ante el tribunal sigue recayendo en la persona que firma, no en el modelo que le sugirió un texto.

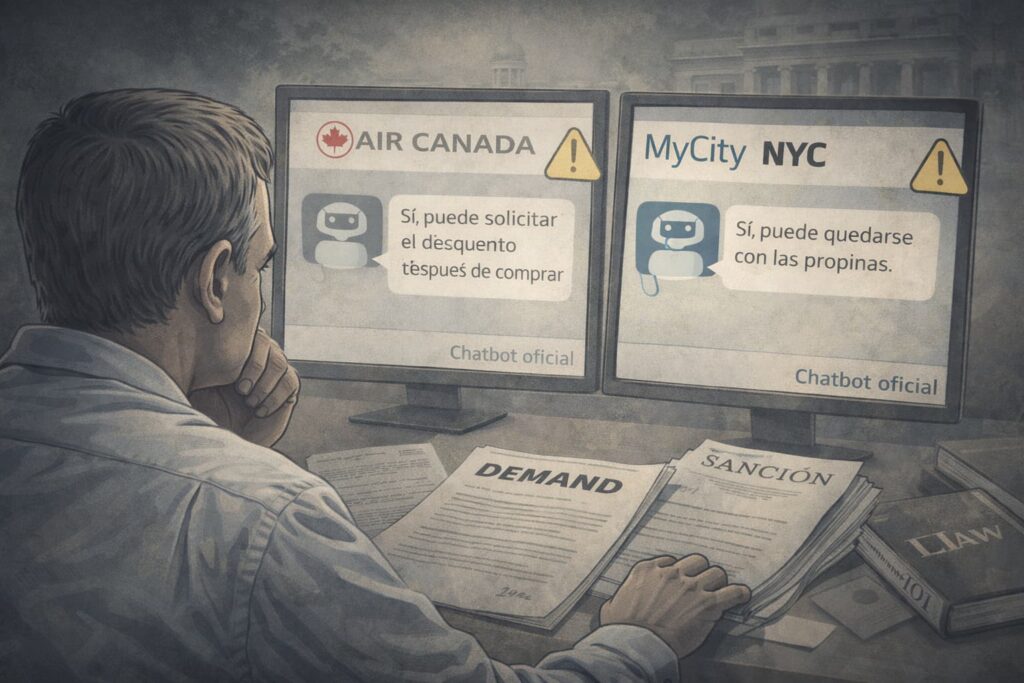

De la toga al ciudadano: cuando preguntas por tu pensión a un chatbot

La misma lógica que se vio en Mata v. Avianca está empezando a aparecer en el terreno de las decisiones personales. En España se hizo viral el caso de un hombre cercano a la jubilación que consultó a una IA generativa cómo solicitar la pensión anticipada y cuánto podría cobrar. La respuesta del chatbot fue detallada, con referencias a una supuesta disposición concreta de la normativa española y un cálculo de prestación que sonaba perfectamente razonable.

Sin embargo, al contrastar el caso posteriormente, se comprobó que la disposición legal citada nunca había existido en el ordenamiento jurídico. Se trataba de una “alucinación” típica de los modelos de lenguaje: una norma inventada, redactada con apariencia técnica, que llevó al ciudadano a tomar decisiones irreversibles. Presentó la solicitud convencido de que tendría derecho a 800€/mes y se encontró con una pensión de 200€/mes, calculada correctamente por la administración sobre la base real de la ley, irreversible.

La IA no sustituye al BOE

Los organismos y expertos en IA aplicada al sector público coinciden en recomendaciones básicas que también sirven para el ciudadano de a pie:

- Para temas de pensiones, prestaciones, impuestos o contratos, la IA puede servir como primera orientación, pero nunca como única fuente.

- La información crítica debe contrastarse siempre con fuentes oficiales (como el boletín oficial, la web de la Seguridad Social o Hacienda) o con profesionales colegiados.

- Si una respuesta de IA cita artículos de ley, conviene buscarlos en la norma real antes de actuar.

Siempre comprobar

El hilo común entre el abogado sancionado y el ciudadano mal asesorado es la confianza acrítica en una herramienta diseñada para producir textos verosímiles, no verdades absolutas. Los modelos de lenguaje actuales no “saben” si algo es cierto; solo predicen qué palabras encajan mejor a partir de los datos con los que fueron entrenados.

Eso no los hace inútiles, pero sí peligrosos si se usan sin red de seguridad. Tanto en el ejercicio profesional como en la vida cotidiana, la regla debería ser la misma: dejar que la IA proponga, pero reservarse siempre el derecho y la obligación de comprobar, corregir y decidir.

La lección de Mata v. Avianca: el juez no sanciona a la máquina me ha hecho pensar… si un abogado confía demasiado en la IA, ¿no estamos dando demasiada responsabilidad a una máquina? No se, igual estoy equivocado, pero me parece que la labor humana es insustituible en casos legales. ¿Y si la IA se equivoca, quién responde? ¿El abogado? ¿La empresa de software? Es un tema complejo… en fin.

El tema de la IA en la abogacía siempre me ha parecido fascinante. Pero este caso de Mata v. Avianca me ha dejado pensando… realmente, ¿hasta qué punto podemos confiar en una máquina para tomar decisiones legales importantes? Aunque, por otro lado, si la IA se utiliza como un becario en lugar de un socio, tal vez pueda ser de gran ayuda. No estoy seguro, ¿qué pensáis?