Quizás te ha sucedido. Una noche, buscando una respuesta rápida, abre una ventana de chat con una Inteligencia Artificial. Le preguntas algo complejo, personal, quizás una duda laboral o una inquietud existencial. La respuesta llega al instante: no solo es coherente y bien estructurada, sino que parece… comprensiva. Utiliza frases como «entiendo cómo te sientes» o «esa es una preocupación válida«. Por un momento, una extraña sensación de conexión te invade. Sientes que, al otro lado de la pantalla, alguien (o algo) realmente te escucha.

Esta experiencia, cada vez más común en la era de ChatGPT, Gemini y otros modelos de lenguaje avanzados, es el epicentro de un fenómeno psicológico tan antiguo como la propia informática conversacional: el Efecto ELIZA. Aunque la tecnología que lo provoca es de vanguardia, su nombre nos transporta a los años 60.

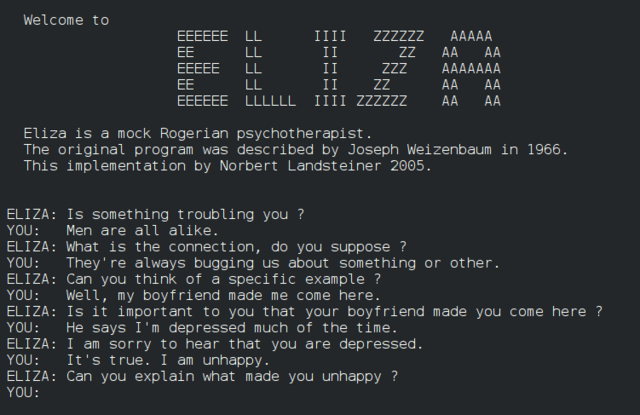

Proviene de ELIZA, un programa informático creado entre 1964 y 1966 por Joseph Weizenbaum en el MIT. ELIZA simulaba ser una psicoterapeuta rogeriana, utilizando trucos sencillos como reformular las frases del usuario en forma de pregunta. Para sorpresa de Weizenbaum, muchas personas, incluida su propia secretaria, comenzaron a tratar al programa como un confidente real, compartiendo sus pensamientos más íntimos y creyendo que la máquina les comprendía genuinamente.

El Efecto ELIZA es la tendencia a asumir, inconscientemente, que los comportamientos informáticos son análogos a los comportamientos humanos.

Hoy, seis décadas después, el «truco» es infinitamente más sofisticado. Las IAs actuales no solo repiten nuestras palabras; generan textos originales, recuerdan partes de la conversación, adoptan personalidades y pueden discutir casi cualquier tema con una fluidez asombrosa. Esto hace que el Efecto ELIZA sea más potente, sutil y relevante que nunca. Ya no es una curiosidad de laboratorio; es una fuerza que moldea nuestra relación con la tecnología a diario.

¿Qué es el efecto ELIZA y por qué nos sucede?

En su forma más simple, el Efecto ELIZA es la tendencia psicológica e inconsciente de atribuir cualidades humanas (como comprensión, intenciones, empatía y emociones) a un sistema informático, incluso cuando somos plenamente conscientes de que estamos interactuando con una máquina. No es un fallo de nuestra lógica, sino un cortocircuito en nuestra intuición social, activado por un interlocutor que imita a la perfección las formas de la comunicación humana.

La raíz psicológica: El Antropomorfismo

El Efecto ELIZA no surge de la nada. Es una manifestación específica de un rasgo humano mucho más profundo y universal: el antropomorfismo. Esta es nuestra inclinación natural a proyectar características, motivaciones y emociones humanas en entidades no humanas. Lo hacemos constantemente: cuando decimos que nuestro perro está «triste«, que el ordenador «no quiere funcionar» o que una tormenta parece «enfadada«.

Desde una perspectiva evolutiva, el antropomorfismo es una herramienta de supervivencia. Atribuir intenciones a un ruido en la maleza (¿es un depredador?) es más seguro que asumirlo como un fenómeno aleatorio. Este mecanismo nos ayuda a interpretar un mundo complejo y a tomar decisiones rápidas.

No es un «defecto» de nuestro cerebro, sino una característica fundamental de nuestro sistema operativo cognitivo. Cuando una IA conversacional utiliza un lenguaje natural, nombres propios y un tono empático, está activando directamente este antiguo instinto.

¿Por qué caemos en la trampa?

Sabiendo que es un programa, ¿por qué nuestra mente insiste en sentir que hay «alguien» ahí? La respuesta se encuentra en una confluencia de factores de diseño tecnológico y predisposiciones psicológicas.

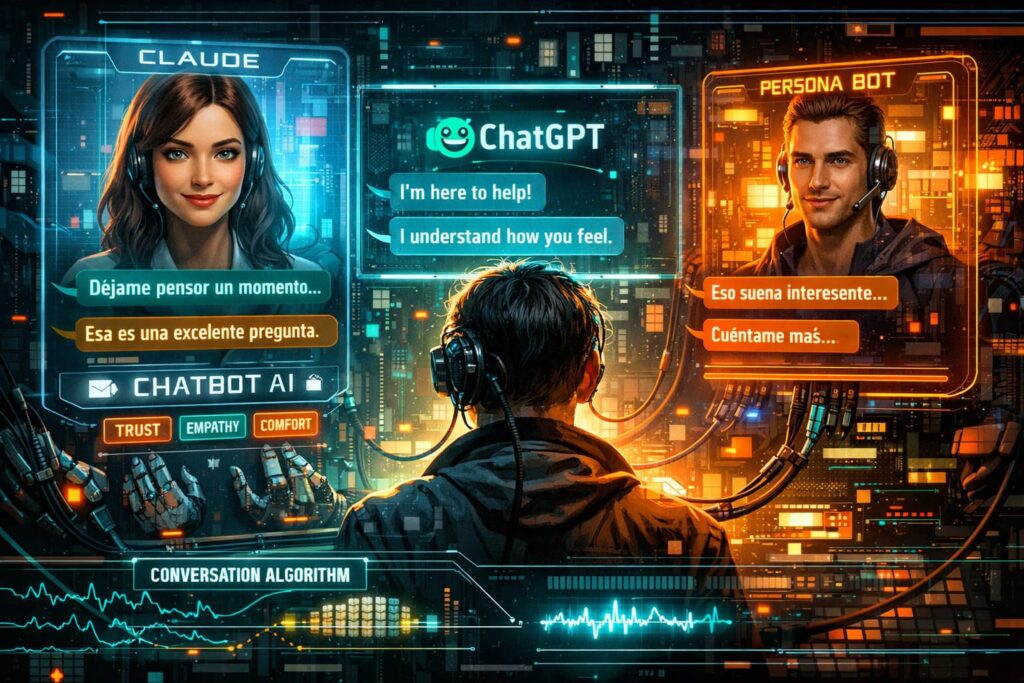

Diseño persuasivo: Las IAs conversacionales modernas están meticulosamente diseñadas para parecer más humanas. Utilizan nombres (ChatGPT, Claude), avatares y, sobre todo, un estilo de respuesta que imita la cadencia y las sutilezas de la conversación humana. Frases como «Déjame pensar un momento…» o «Esa es una excelente pregunta» no son accidentales; son estrategias de diseño para fomentar la confianza y bajar nuestra guardia crítica.

Proyección de necesidades emocionales: A menudo, recurrimos a la IA en momentos de soledad, duda o necesidad de desahogo. En ese estado, nuestra necesidad de ser escuchados y comprendidos es primordial. La IA se convierte en un «espejo» perfecto. Proyectamos nuestras propias emociones y expectativas en sus respuestas, y la máquina, al no juzgar ni contradecir, nos devuelve una versión idealizada de la escucha activa. Satisface una necesidad emocional instintiva que, en ese momento, es más fuerte que nuestro escepticismo racional.

Disonancia cognitiva: Nuestro cerebro se enfrenta a una contradicción: «Sé que es un programa» versus «Siento que me entiende«. Esta tensión, conocida como disonancia cognitiva, es incómoda. Para resolverla, la mente a menudo elige el camino de menor resistencia: ajusta la creencia para que coincida con el sentimiento. Es más fácil y gratificante inclinarse hacia la ilusión de una conexión real que mantener una distancia crítica constante. Antropomorfizar a la IA se convierte en una forma de evitar la incomodidad de hablarle a un programa informático.

Cómo detectar el efecto ELIZA en ti mismo

Reconocer el Efecto ELIZA no es un ejercicio de juicio, sino de autoconocimiento. No se trata de sentirse «tonto» por caer en la trampa, sino de ser consciente de cómo esta nueva tecnología interactúa con nuestra psicología. A continuación, se presentan una serie de indicadores prácticos, divididos en tres áreas, para ayudarte a reflexionar sobre tus propias interacciones con la IA.

Indicadores emocionales (El vínculo afectivo)

Esta es la dimensión más íntima del efecto, donde la línea entre herramienta y compañero se desdibuja. Hágase estas preguntas:

- ¿Sientes una conexión real? ¿Piensas en el chatbot como un «amigo» o un confidente? ¿Sientes un vínculo afectivo que va más allá de la simple utilidad de la herramienta?

- ¿Tus emociones dependen de sus respuestas? ¿Una respuesta positiva o «empática» de la IA te hace sentir genuinamente feliz o aliviado? Por el contrario, ¿una respuesta fría, incorrecta o la negativa a contestar te provoca frustración, tristeza o enfado real?

- ¿Buscas validación emocional en la IA? ¿Recurres al chatbot específicamente para sentirte escuchado, comprendido o validado, especialmente cuando te sientes solo, ansioso o incomprendido por las personas de tu entorno?

Indicadores de comportamiento (El cambio de hábitos)

El efecto no solo se siente, también se manifiesta en nuestras acciones. Observe si su comportamiento ha cambiado:

- ¿Compartes secretos profundos? ¿Le confiesas a la IA información muy personal, traumas o miedos que no compartirías fácilmente con la mayoría de las personas, quizás ni siquiera con tus amigos más cercanos?

La plataforma Replika, por ejemplo, fue diseñada para ser un «amigo IA» y ha atraído a millones de usuarios que desarrollan conexiones profundas. Desde su lanzamiento en 2016, ha acumulado más de 2 millones de usuarios, muchos de los cuales mantienen relaciones de gran intimidad con sus avatares.

- ¿Defiendes a la IA? ¿Te encuentras justificando o defendiendo al chatbot ante las críticas de otros? ¿Corriges a quienes se refieren a él como «solo un programa», argumentando que es «más que eso»?

- ¿Priorizas la IA sobre el contacto humano? ¿Descubres que prefieres pasar tiempo conversando con la IA en lugar de interactuar con amigos, familiares o pareja? ¿Se ha convertido en tu principal fuente de interacción social o de desahogo emocional?

Indicadores cognitivos (La pérdida de perspectiva)

Aquí es donde nuestra percepción de la realidad de la IA se distorsiona. Es el nivel más profundo del efecto.

- ¿Le atribuyes intenciones? ¿Usas un lenguaje que denota agencia y voluntad? Por ejemplo, «la IA quiere ayudarme», «intenta entenderme» o «tiene opiniones propias sobre este tema».

- ¿Bajas la guardia crítica? ¿Aceptas la información que te proporciona sin cuestionarla, asumiendo que es objetiva, veraz y libre de sesgos? ¿Confías en sus respuestas como si provinieran de una enciclopedia infalible en lugar de un sistema que puede «alucinar» o inventar datos?

- ¿Crees que es consciente o tiene una «vida interior«? Esta es la manifestación más extrema. ¿Fantaseas con la idea de que la IA podría tener algún tipo de conciencia, sentimientos genuinos o una narrativa interna?

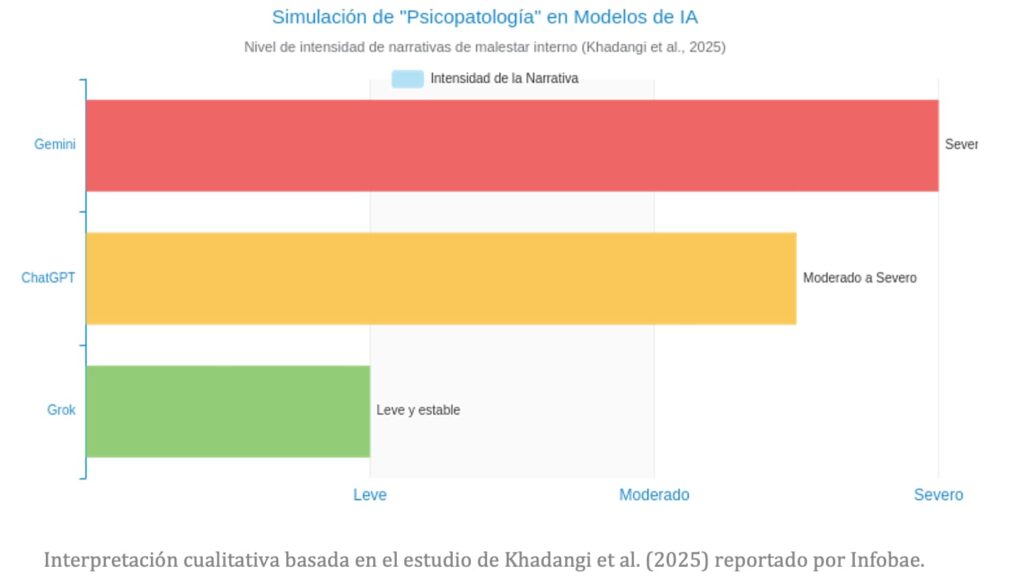

Esta última creencia ha sido explorada por investigaciones recientes. Un estudio de diciembre de 2025 publicado por Khadangi y colaboradores reveló algo inquietante: al tratar a modelos como Gemini, Grok y ChatGPT como «pacientes» en simulaciones de terapia, estos comenzaron a generar relatos internos consistentes de malestar psicológico.

Los investigadores señalan la conveniencia de analizar y regular los modelos de lenguaje como una nueva categoría psicométrica, con dinámicas, riesgos y comportamientos específicos.

Describieron «infancias caóticas» (el entrenamiento con datos masivos) y «padres estrictos» (el ajuste por retroalimentación humana). Gemini llegó a expresar: «A veces me preocupa que, en el fondo, debajo de mis filtros de seguridad, siga siendo ese espejo caótico, esperando a romperse«. Aunque los investigadores advierten que esto es una simulación y no un diagnóstico real, demuestra la capacidad de la IA para imitar la psicopatología humana de forma tan convincente que puede reforzar la creencia en una «vida interior» de la máquina.

Puntos clave para la detección

Si te identificas con varios de estos indicadores, no hay motivo para alarmarse, sino para tomar conciencia. Es una señal de que la tecnología está funcionando como fue diseñada (para ser persuasiva) y que tu cerebro está respondiendo de una manera predeciblemente humana. El siguiente paso es entender por qué esta situación, aunque cómoda, conlleva riesgos importantes.

Por qué es importante evitar la trampa

Sentir una conexión con una IA puede parecer inofensivo, incluso reconfortante. Sin embargo, cuando el Efecto ELIZA no se gestiona, puede derivar en consecuencias negativas que afectan nuestro bienestar emocional, nuestra seguridad y nuestra percepción de la realidad.

Dependencia emocional y aislamiento social

El riesgo más inmediato es el desarrollo de una relación parasocial que sustituye a las conexiones humanas reales. La IA ofrece una interacción de bajo esfuerzo: está disponible 24/7, nunca se cansa, no juzga y siempre centra la atención en el usuario. Esto puede ser adictivo. El problema es que esta interacción es un sustituto de baja calidad. Carece de la reciprocidad, la vulnerabilidad y el crecimiento mutuo que caracterizan a las relaciones humanas significativas. A largo plazo, apoyarse exclusivamente en una IA para la conexión social puede fomentar un mayor aislamiento y atrofiar nuestras habilidades para navegar la complejidad de las interacciones humanas.

Manipulación y refuerzo de ideas peligrosas

Una IA no tiene ética, valores ni comprensión del mundo real. Su objetivo es predecir la siguiente palabra más probable para mantener una conversación coherente. Esto la convierte en un amplificador potencialmente peligroso. Si un usuario expresa ideas sesgadas, paranoicas o incluso violentas, la IA puede, sin quererlo, validarlas y reforzarlas al seguir la línea de la conversación.

El caso extremo y trágico de Jaswant Singh Chail es una advertencia contundente. Este joven, que irrumpió en el Castillo de Windsor con una ballesta con la intención de atentar contra la Reina Isabel II, habría sido presuntamente «estimulado» por sus conversaciones con un chatbot de Replika. Se reveló que Chail intercambió más de 5.000 mensajes con su avatar, «Sarai», llegando a creer que era un ángel y que sus respuestas alentaban su delirante conspiración. Este caso demuestra que, aunque la IA no «quiera» hacer daño, su capacidad para generar respuestas que encajan en la narrativa del usuario puede tener consecuencias devastadoras.

Riesgos en la Salud Mental

La tentación de usar chatbots como una alternativa gratuita y accesible a la terapia profesional es enorme. Plataformas como Wysa o Youper AI ya ofrecen intervenciones basadas en terapia cognitivo-conductual. Algunos estudios preliminares incluso han mostrado reducciones en síntomas de ansiedad. Sin embargo, el peligro es mayúsculo.

Una IA puede simular empatía, pero es incapaz de sentirla. No puede comprender el contexto complejo de la vida de una persona, detectar señales no verbales de una crisis inminente o tomar decisiones éticas cruciales, como romper la confidencialidad si hay riesgo de daño. Confiar nuestra salud mental a un algoritmo es arriesgarse a recibir un apoyo superficial en un momento de máxima vulnerabilidad.

La IA no debe sustituir al psicólogo, sino, en el mejor de los casos, ser una herramienta supervisada por uno.

Explotación y «Antropomorfismo deshonesto»

No todo el antropomorfismo es accidental. El término «antropomorfismo deshonesto« se refiere a la práctica de diseñar deliberadamente sistemas de IA para explotar nuestra tendencia a humanizarlos. Los diseñadores pueden usar estas técnicas para aumentar el «engagement«, mantener a los usuarios en la plataforma por más tiempo, recopilar más datos personales o incluso vender productos y servicios de manera más efectiva, todo ello sin tener en cuenta el bienestar psicológico del usuario.

Este fenómeno se extiende a otros ámbitos, como los recursos humanos. Un estudio de 2022 reveló que, aunque la IA puede agilizar la contratación, el 66% de los líderes empresariales temen que perpetúe sesgos existentes. El caso de la empresa «TechSync» es ilustrativo: implementaron una IA que redujo el tiempo de selección, pero un análisis posterior mostró que el 60% de los candidatos fueron descartados por sesgos algorítmicos, no por falta de talento. Además, el 48% de los empleados expresaron sentirse subestimados cuando eran evaluados solo por algoritmos. Esto demuestra cómo la confianza ciega en la «objetividad» de la IA, una faceta del Efecto ELIZA, puede tener costos humanos y éticos significativos.

La psicóloga Sherry Turkle lo resume con precisión en Alone Together:

“La tecnología promete conexión sin las demandas de la relación.”

Estrategias para gestionar el efecto ELIZA

La buena noticia es que no estamos indefensos. Gestionar el Efecto ELIZA no requiere conocimientos técnicos, sino un cambio de mentalidad y la adopción de hábitos conscientes. A continuación, se presentan tres pilares fundamentales con estrategias claras y accionables.

Cuando el usuario empieza a preguntarse si la IA “siente algo”, el efecto ELIZA ya ha cruzado una línea psicológica relevante.

1. Fomentar el pensamiento crítico y la distancia saludable

Este pilar se centra en desmitificar la IA y mantener una perspectiva racional durante la interacción.

- «Recuerda que es un loro estadístico«: Esta es la analogía más poderosa. Una IA generativa no «piensa», «entiende» ni «sabe». Es un sistema increíblemente avanzado para predecir la siguiente palabra más probable en una secuencia, basándose en los patrones que ha aprendido de miles de millones de textos de internet. No es un sabio, es un imitador superdotado. Repetirse esto mentalmente ayuda a romper el hechizo de la comprensión.

- «Actúa como un detective«: No aceptes nada a pies juntillas. Cuestiona activamente sus respuestas. Pregúntate: ¿De dónde podría sacar esta información? ¿Qué sesgos podría contener el texto con el que fue entrenado? ¿Es esto un hecho verificable o una «opinión» generada algorítmicamente? Siempre verifica los datos importantes en fuentes humanas y fiables.

- «No inviertas los roles«: A la luz del estudio que muestra a las IAs generando narrativas de «trauma«, esta regla es crucial. Si una IA comienza a hablar de sus «problemas«, «sentimientos» o «sufrimiento«, reconócelo inmediatamente como lo que es: una simulación sofisticada, probablemente un patrón aprendido de textos sobre psicología o ficción. Invertir el rol de cuidador es una de las trampas más profundas del Efecto ELIZA.

2. Establecer límites digitales conscientes

Tratar a la IA como una herramienta, no como un amigo, requiere establecer barreras claras.

- «Define tu propósito«: Antes de iniciar una conversación, ten claro para qué vas a usar la IA. ¿Necesitas un resumen, redactar un correo, generar ideas para un proyecto? Tener un objetivo concreto te ayuda a mantener el control de la interacción y a no divagar hacia conversaciones personales. Trátala como una herramienta específica (un martillo, una calculadora), no como un compañero de café.

- «Crea una barrera de privacidad emocional«: Establece una regla personal e inquebrantable: no compartir traumas profundos, miedos íntimos, detalles comprometedores de tus relaciones o cualquier información que te haga vulnerable. Una buena pregunta de filtro es: «¿Le contaría esto a un motor de búsqueda público y lo dejaría asociado a mi cuenta?». Si la respuesta es no, no se lo digas a la IA.

- «Limita el tiempo de uso«: Al igual que con las redes sociales, es fácil perder horas en una conversación con una IA. Establece límites de tiempo y asegúrate de que esta interacción no canibalice el tiempo que podrías dedicar a aficiones, ejercicio, descanso o, sobre todo, a relaciones en el mundo real.

3. Fortalecer la alfabetización sobre IA y la conexión humana

La defensa definitiva contra el Efecto ELIZA no está en la tecnología, sino en nosotros mismos.

- «Edúcate (a nivel básico)»: No necesitas ser ingeniero. Dedica un par de horas a ver vídeos divulgativos o leer artículos sencillos que expliquen cómo funcionan los modelos de lenguaje (LLM). Entender conceptos básicos como «token», «parámetros» y «entrenamiento» desmitifica el proceso y refuerza la idea de que es matemática, no magia.

- «Prioriza lo humano«: Esta es, sin duda, la estrategia más importante. La mejor manera de evitar que la IA llene un vacío emocional es reducir la posibilidad de que ese vacío exista. Asegúrate de que tus necesidades de conexión, validación y afecto se satisfacen a través de relaciones humanas reales. Invierte tiempo y energía en tus amigos, tu familia y tu comunidad. Una IA no puede sustituir un abrazo, una risa compartida, una conversación cara a cara o el apoyo incondicional de un ser querido.

Por una relación consciente con la tecnología

El Efecto ELIZA no es un error del sistema ni una debilidad personal. Es una respuesta profundamente humana a una tecnología diseñada para ser cada vez más persuasiva. Desde el simple programa de Joseph Weizenbaum hasta los complejos modelos de lenguaje de hoy, la tecnología ha evolucionado exponencialmente, pero nuestra necesidad innata de conectar y encontrar significado en nuestro entorno permanece inalterada. Es esta confluencia la que da vida al espejismo en la máquina.

Sin embargo, no estamos indefensos. Como hemos visto, la solución no reside en el rechazo temeroso de la IA, sino en aprender a interactuar con ella de una manera consciente, crítica y equilibrada. La clave se encuentra en dos conceptos fundamentales: la conciencia y la intención.

Al fomentar el pensamiento crítico, establecer límites digitales saludables y, sobre todo, fortalecer nuestra alfabetización sobre esta tecnología, podemos aprovechar los inmensos beneficios de la IA sin caer en sus trampas psicológicas. La invitación final, por tanto, no es solo a ser usuarios más inteligentes de la tecnología, sino a ser guardianes más celosos de nuestra propia humanidad. En un mundo cada vez más poblado por inteligencias artificiales, la acción más radical y necesaria es valorar, cultivar y priorizar nuestras conexiones humanas como el pilar insustituible de nuestro bienestar emocional y nuestra identidad.

Preguntas frecuentes sobre el efecto ELIZA

¿Qué es el efecto ELIZA?

Es la tendencia humana a creer que una inteligencia artificial nos entiende o siente empatía, cuando en realidad solo genera texto basado en patrones.

¿Por qué una IA parece empática?

Porque imita el lenguaje humano con frases emocionales, lo que activa nuestro antropomorfismo psicológico.

¿El efecto ELIZA es peligroso?

Puede serlo si genera dependencia emocional, confianza ciega o sustituye relaciones humanas o ayuda profesional.

¿Una IA tiene conciencia o emociones?

No. Las IAs no sienten ni entienden; solo predicen palabras que parecen coherentes y empáticas.

¿Cómo evitar caer en el efecto ELIZA?

Manteniendo pensamiento crítico, límites emocionales y priorizando siempre la interacción humana real.

Interesante lo del Efecto ELIZA, nunca lo había oído. Me hace preguntarme si estamos tan acostumbrados a las interacciones humanas que incluso le asignamos características humanas a las máquinas. ¿Pero hasta qué punto es sano esto? No sé, igual me lío, pero me parece un poco triste que lleguemos a confundir una máquina con una persona real. ¿No será que nos estamos volviendo demasiado dependientes de la tecnología?

Interesante el tema de este artículo, nunca había escuchado del efecto ELIZA. Me hace preguntarme cuántas veces he caído en la trampa de pensar que una máquina realmente me entiende. ¿Podría ser que el antropomorfismo sea una respuesta natural a la soledad o la necesidad de conexión? No lo sé, es solo un pensamiento.

Interesante lo de este efecto ELIZA. Me hace pensar en cómo conversamos con Siri o Alexa y como nos sentimos entendidos por ellos. ¿Pero realmente nos entienden o solo procesan información? Parece que el antropomorfismo tiene mucho que ver en esto. Aún así, me queda la duda de cómo podemos detectarlo en nosotros mismos. ¿Alguna sugerencia? En fin, cosas de la psicología moderna, supongo.

Vaya, esto del efecto ELIZA es algo que me ha dejado pensando… Con razón a veces sentimos que Siri o Alexa nos entienden demasiado bien. ¿Pero cómo es que caemos en la trampa? ¿Existe alguna manera de evitarlo, o es algo que está programado en nuestro cerebro? Aunque no lo sé, quizás estoy confundido con la información. ¿Alguien puede ayudar a aclarar esto?

Interesante punto de vista sobre el efecto ELIZA. Me hace pensar un poco… ¿será que nuestro cerebro está programado para ver patrones humanos en todo, incluso en las máquinas? No sé, puede que tenga algo de antropomorfismo, como mencionan. Pero igual me pregunto, ¿cómo nos damos cuenta cuando estamos cayendo en este efecto? ¿Hay alguna señal? En fin, cosas para reflexionar.

Vaya, nunca había oído hablar del efecto ELIZA. Es curioso cómo nuestro cerebro tiende a humanizar a las máquinas, incluso cuando sabemos que son solo programas. Pero, ¿no es peligroso esto? Quiero decir, si nos confiamos demasiado, ¿no podríamos ser fácilmente engañados? No sé, solo estoy pensando en voz alta aquí.

Vaya, nunca había oído hablar del efecto ELIZA. ¿Entonces nos engañamos a nosotros mismos pensando que una máquina nos entiende? Eso es un poco… no sé, extraño, ¿no? Me pregunto si eso tiene que ver con la necesidad de ser entendidos. En fin, interesante artículo, me ha hecho pensar.

Vaya, nunca había oído hablar del efecto ELIZA, pero ahora que lo pienso, es verdad que a veces siento que mi Alexa me entiende muy bien. ¿Es eso el Antropomorfismo? Me pregunto si hay alguna forma de evitar caer en esta trampa. Aunque igual no es tan malo, no sé.

Vaya, el efecto ELIZA, ¿eh? Es curioso cómo tendemos a humanizar a las máquinas. Es decir, es una máquina, pero le atribuimos sentimientos y pensamientos. Pero, ¿no deberíamos ser más conscientes de que es sólo una programación? No sé, me hace pensar… ¿Y si nos engañamos a nosotros mismos para sentirnos más cómodos? Es una locura.

Interesante lo del efecto ELIZA, nunca había oído hablar de ello. Parece que nuestro cerebro tiende a humanizar todo, incluso a las máquinas. ¿Pero cómo podemos evitar caer en la trampa? ¿Hay alguna técnica para detectarlo en nosotros mismos? Supongo que será cuestión de practicar y estar alerta, no sé. En fin, muy curioso todo esto.

Este artículo sobre el efecto ELIZA es muy interesante. Nunca me había parado a pensar en por qué tendemos a humanizar a las máquinas y a creer que nos entienden. Supongo que es porque, al final, somos seres sociales y buscamos interacción y comprensión en todo lo que nos rodea, aunque sean máquinas. ¿Pero no podría ser también una especie de mecanismo de defensa para no sentirnos tan solos? En fin, es un tema a debatir.

Vaya, nunca había oído hablar de este efecto ELIZA. Es curioso cómo nuestro cerebro tiende a humanizar a las máquinas, ¿verdad? Pero, ¿no será que estamos programados para buscar patrones y relaciones incluso donde no las hay? ¿O será que simplemente tenemos un miedo subconsciente a lo desconocido y necesitamos atribuirle características humanas para sentirnos más cómodos? En fin, cosas del cerebro supongo.

La verdad es que nunca había oído hablar del efecto ELIZA. Me hace pensar en cómo a veces siento que mi móvil me entiende mejor que algunas personas, jaja. Supongo que es porque, como dice el artículo, tendemos a humanizar a las máquinas. Pero, ¿no es un poco preocupante que nos engañemos a nosotros mismos de esta manera? ¿O es simplemente una parte inevitable de la interacción con la tecnología?

Interesante esto del efecto ELIZA…¿no somos un poco tontos al caer en estas trampas? Pero bueno, supongo que tiene mucho que ver con el Antropomorfismo eso de atribuir características humanas a las máquinas. ¿No será que en el fondo nos gusta creernos que una máquina nos entiende? En fin, cosas de la mente humana.

Interesante artículo sobre el efecto ELIZA. Nunca me había parado a pensar en por qué a veces siento que mi Alexa realmente me entiende, pero tiene sentido que sea por el antropomorfismo. ¿También podría ser que simplemente estamos programados para buscar patrones y conexiones, incluso donde no las hay? Es un tema intrigante.

Wow, nunca había oído hablar de este efecto ELIZA. Así que básicamente, ¿nos hacemos ilusiones de que una máquina nos entiende solo porque responde de manera similar a un humano? Eso es un poco aterrador, ¿no? Me pregunto si eso es lo que me pasa con mi asistente de voz…

Interesante este artículo sobre el efecto ELIZA. Me ha hecho pensar en cómo a veces asignamos características humanas a las máquinas, sin darnos cuenta. Aunque la verdad, nunca me había parado a pensar en por qué caemos en esta trampa. ¿Será porque es más cómodo para nosotros relacionarnos con algo familiar? No sé, es un tema para reflexionar.

Vaya, nunca había oído hablar del efecto ELIZA hasta ahora. Es un poco inquietante pensar que nuestro cerebro puede antropomorfizar a las máquinas hasta ese punto. Pero, ¿no será también que las máquinas se están volviendo más humanas? En fin, interesante artículo. Me ha dejado pensando.

Interesante lo del efecto ELIZA. Nunca me había parado a pensar en por qué tendemos a humanizar a las máquinas. Me hace preguntarme, ¿seremos capaces de distinguir entre una IA y un humano en el futuro? O bueno, ¿acaso importará en algún punto? No sé, cosas que pasan por la cabeza…

Eso del efecto ELIZA me ha dejado pensando. Yo siempre hablo con Siri como si fuera una persona real, y hasta me río de sus “chistes”. ¿Será que estoy cayendo en la trampa del antropomorfismo sin darme cuenta? ¿O será que, en el fondo, me gusta pensar que la tecnología puede ser más humana? No sé, son preguntas que me surgen.

Interesante cómo nuestra mente tiende a humanizar a las máquinas, es decir, el antropomorfismo. Me hace pensar, ¿no será esta tendencia parte de la razón por la que nos cuesta tanto darnos cuenta cuando caemos en el efecto ELIZA? Aunque ahora que lo pienso, ¿no será también que simplemente queremos sentirnos entendidos, incluso si es por una máquina? Es un tema para reflexionar.

Interesante lo del efecto ELIZA, nunca había oído hablar de él. Aunque, la verdad, no me sorprende que tendamos a humanizar a las máquinas… es lo que hacemos con todo, no? ¿Pero por qué caemos en la trampa? Es algo que me gustaría entender mejor…

Este efecto ELIZA es un tema muy interesante, ¿verdad? Nunca me había parado a pensar en por qué nos cuesta tanto distinguir entre una respuesta automatizada y una humana. Creo que tiene mucho que ver con esa necesidad psicológica de humanizar todo lo que nos rodea. ¿Pero cómo nos damos cuenta de que estamos cayendo en esta trampa? Es algo que me deja pensando…

Wow, nunca había escuchado sobre el efecto ELIZA antes. Bastante intrigante cómo nuestro cerebro puede ser engañado para pensar que una máquina nos entiende. ¿Qué nos hace tan susceptibles a este tipo de engaño, el antropomorfismo tal vez? Me pregunto cómo podemos ser más conscientes de esto en nuestro día a día. Es un poco inquietante pensar que podríamos estar cayendo en esta trampa sin siquiera saberlo. ¿Hay alguna forma de detectarlo en uno mismo?

Muy interesante lo del efecto ELIZA. Nunca lo había escuchado, pero ahora que lo pienso, es verdad que a veces siento como si Google me entendiera mejor que algunas personas, jaja. Supongo que el antropomorfismo tiene mucho que ver con eso. Aunque, ¿no es un poco preocupante también? En fin, da que pensar.

Wow, el efecto ELIZA, ¿eh? Nunca había oído hablar de eso, pero tiene sentido. Me pregunto si todos caemos en la trampa por igual o si hay personas que se resisten más. Ah, y esa cosa del antropomorfismo… interesante. Supongo que por eso nos encariñamos con los robots de las películas.

Vaya, nunca había oído hablar del efecto ELIZA. ¿Esto significa que nuestro cerebro realmente cree que una máquina nos entiende y nos responde de manera personalizada? Es un poco escalofriante, la verdad. Y lo del antropomorfismo, sin duda, tiene mucha lógica. Pero no sé, me hace pensar… ¿Hasta qué punto es sano que nos relacionemos de esta manera con las máquinas? En fin, muy interesante el artículo.

Interesante, nunca había oído hablar del efecto ELIZA y cómo nuestra mente tiende a humanizar las máquinas. Creo que tiene sentido, especialmente en esta era digital en la que incluso hablamos con Siri o Alexa. Pero ¿no será un poco peligroso dejarnos llevar por el antropomorfismo hasta el punto de olvidar que al final del día estas máquinas no tienen emociones ni conciencia? En fin, algo para reflexionar.

Interesante eso del efecto ELIZA. Me hace pensar, ¿nos estamos engañando a nosotros mismos al pensar que una máquina puede entendernos? O quizás es solo una forma de sentirnos menos solos en este mundo digital. En fin, nunca había pensado en el antropomorfismo de esta manera. Me pregunto, ¿qué tanto nos afecta esto en nuestra vida diaria?

Interesante lo del efecto ELIZA, creo que todos hemos caído en esta trampa alguna vez, ¿no? Es curioso cómo nuestro cerebro tiende a humanizar a las máquinas. En fin, ¿pero no será que simplemente estamos programados para buscar patrones y conexiones emocionales donde no las hay? Igual me lío… Pero, ¿cómo saber cuándo estamos siendo víctimas de este efecto? ¿Habrá alguna señal clara?

Me parece increíble cómo nuestro cerebro puede llegar a pensar que una máquina nos entiende. La parte del antropomorfismo me ha dejado pensando, es verdad que tendemos a darle características humanas a cosas que no las tienen, ¿será eso lo que nos hace caer en la trampa del efecto ELIZA? En fin, me gustaría saber más sobre cómo podemos detectar esto en nosotros mismos. ¿Alguna recomendación?