Las redacciones y los hospitales empiezan a usar inteligencia artificial para ganar tiempo y eficiencia. Pero cuando el atajo se convierte en sustituto, la consecuencia puede ser la más temida: información falsa publicada y diagnósticos equivocados.[10][11][3]

El periódico que descubrió que sus fuentes eran fantasma

En 2024, el diario colombiano El Espectador afrontó una de las crisis de credibilidad más delicadas de su historia reciente. La dirección del medio reconoció públicamente que un periodista en prácticas había usado IA generativa para escribir artículos y, sobre todo, para inventar expertos a los que atribuía citas y recomendaciones.

Según explicó el director, Fidel Cano, el interno utilizaba un chatbot para producir textos sobre bienestar, salud mental o envejecimiento y luego convertía fragmentos en citas supuestamente pronunciadas por psicólogos, gerontólogos o profesores universitarios. Los nombres sonaban plausibles, las afiliaciones parecían reales… pero al intentar verificarlas, el equipo de edición no encontró rastro de esas personas en registros académicos ni en redes profesionales.

El medio reaccionó con varias medidas contundentes: despidió al becario, retiró todos sus artículos de la web y publicó una disculpa abierta en la que asumía fallos en sus mecanismos de control. El caso se ha citado después en informes y análisis sobre IA y medios como ejemplo de cómo la presión por producir rápido y la disponibilidad de herramientas aparentemente infalibles pueden erosionar la esencia del periodismo: la verificación.

¿Puede la IA ser “coautora” de una noticia?

Los observatorios de medios y centros de estudio de periodismo recomiendan distinguir de forma nítida entre usar IA para tareas mecánicas (transcribir, ordenar datos, sugerir titulares) y convertirla en una especie de “redactor fantasma”. En el primer caso, su uso puede aumentar la productividad sin afectar al rigor si el contenido final sigue pasando por manos humanas exigentes. En el segundo, el riesgo es que se cuelen datos inventados, citas sin fuente real o estudios mal interpretados, todo ello con un estilo impecable que dificulta detectar el engaño.

IA en diagnóstico médico: avance prometedor, riesgo real

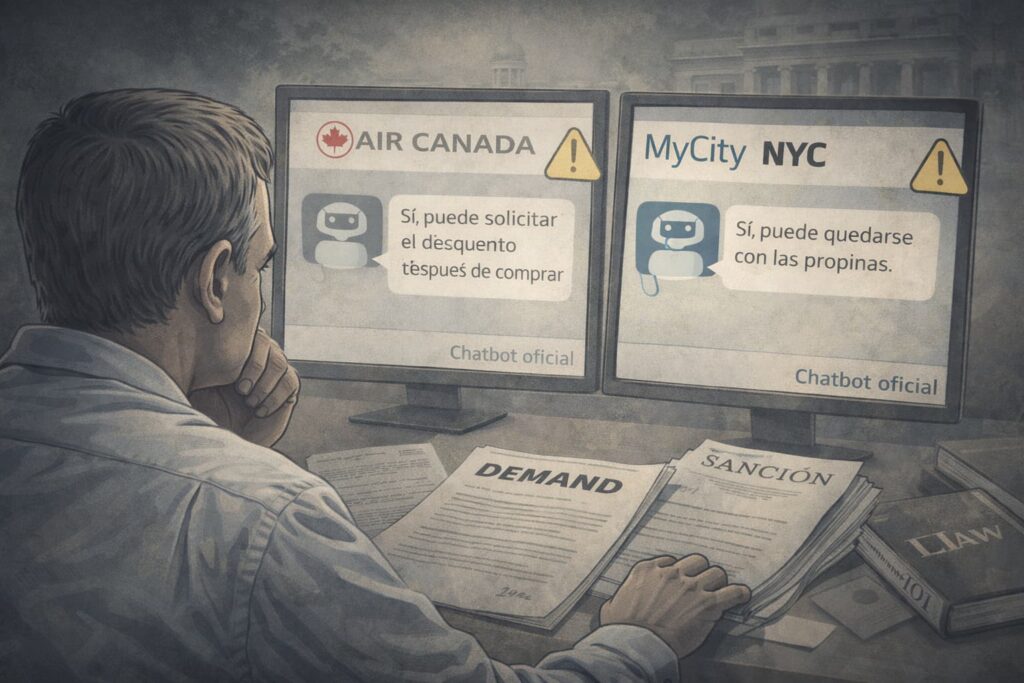

En paralelo, los hospitales y centros sanitarios de todo el mundo prueban sistemas de IA para ayudar en el diagnóstico a partir de imágenes médicas o historiales. La literatura científica muestra casos en los que estos algoritmos han igualado o incluso superado la precisión humana en tareas muy acotadas, como detectar ciertas lesiones en radiografías o mamografías. Sin embargo, informes sobre ética y regulación sanitaria alertan de problemas cuando se implantan sin suficiente validación y supervisión.

Uno de los riesgos mejor documentados es el sesgo en los datos de entrenamiento. Si un modelo se entrena mayoritariamente con imágenes de pacientes de un grupo étnico, rango de edad o región concreta, su rendimiento puede degradarse cuando se aplica a poblaciones diferentes. Esto se ha observado en algoritmos que diagnostican peor enfermedades en pieles oscuras frente a claras, o que confunden patrones normales y patológicos en grupos infrarepresentados.

Otro problema es el llamado sesgo de automatización: cuando los profesionales sanitarios confían demasiado en la salida del sistema y relegan su propio juicio. Si el informe automatizado sugiere “alta probabilidad” de una patología grave, existe la tentación de seguir el protocolo completo sin cuestionar los fundamentos, exponiendo a pacientes a pruebas invasivas o tratamientos agresivos innecesarios.

El médico sigue firmando

Los marcos regulatorios y deontológicos emergentes son claros en un punto: la IA médica debe verse como un dispositivo de ayuda, no como un sustituto del médico. La responsabilidad última de un diagnóstico o de un plan de tratamiento sigue recayendo en el profesional que lo firma y en el centro que lo proporciona. Esto implica que cualquier sistema de IA debe:

- ser validado localmente antes de su uso rutinario,

- acompañarse de formación específica al personal,

- y diseñarse de forma que el clínico pueda entender sus limitaciones y, si es necesario, descartarlo.

La apariencia de autoridad y falta de contraste

Tanto en el caso del periódico como en el de los sistemas médicos, el problema no es solo técnico, sino cultural. La IA trabaja con texto y patrones que suenan convincentes, y eso hace que usuarios y profesionales bajen la guardia. Pero ni un experto inventado con cargo rimbombante ni un informe automatizado con cifras y probabilidades sustituyen a la verificación periodística o al juicio clínico.

Integrar la IA de forma responsable pasa por recordarlo cada día: detrás de cada contenido publicado y de cada diagnóstico comunicado hay una firma humana… y es esa firma la que el lector y el paciente están confiando.