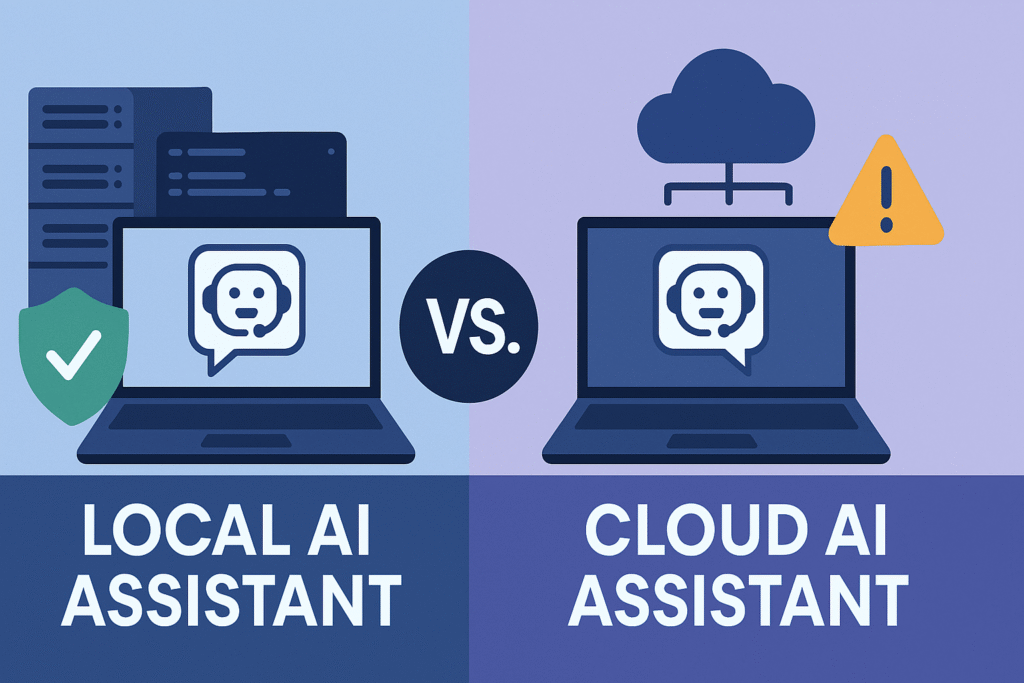

La decisión entre un asistente de IA local y uno en la nube a menudo se reduce a privacidad versus conveniencia.

- Si la privacidad del código y el ahorro de costes son importantes, un asistente local es la opción preferida.

- Si se busca potencia sin complicaciones y la máxima calidad, la nube es la ganadora.

Este es un resumen de las características más destacables a tener en cuenta a la hora de decidirnos por un modelo en local o en la nube:

| Característica | Asistente de IA Local | Asistente de IA en la Nube |

|---|---|---|

| Privacidad y Seguridad | ✅ Tu código nunca sale de tu máquina. | ⚠️ El código se envía a servidores de terceros (aunque con políticas de privacidad). Riesgo de fuga o uso indebido de información sensible. |

| Costes | 💰 Coste inicial de hardware, luego gratuito. A largo plazo, puede ser más económico. | 💰 Tarifas mensuales (entre $10 y $200/mes dependiendo del servicio). A corto plazo, más barato si no tienes GPU de alta gama. |

| Facilidad de Configuración | 🔧 Requiere configuración técnica inicial. | ✅ Plug-and-play, configuración mínima. Configuración más fácil. |

| Calidad de IA | 🟡 Buena, pero ligeramente por debajo de los modelos más avanzados en la nube. La brecha se está reduciendo. | ✅ Ofrecen los modelos más avanzados disponibles. Suelen tener una ventaja en capacidad de IA pura. |

| Confiabilidad | ✅ No depende de conexión a internet. | ⚠️ Requiere conexión estable, puede tener tiempo de inactividad. |

| Personalización | ✅ Control total sobre modelos y configuración. Permite ajuste fino para usos específicos. | 🟡 Limitado a lo que ofrece el proveedor. |

| Modelos | Modelos de código abierto (ej. Code Llama, Qwen, Mistral, Llama). | Modelos propietarios (ej. GPT-4 de OpenAI, Claude de Anthropic). |

Los 10 LLM más usados para instalación local

Esta es una lista que podemos consultar para ver el modelo que más se ajusta a nuestra capacidad y los usos que le vamos a dar.

| Modelo / Herramienta | Tipo / Plataforma | Ventajas Clave | Requisitos de Hardware | Usos Recomendados |

|---|---|---|---|---|

| GPT4All | App + marco LLM (Nomic AI) | Fácil de usar, gran biblioteca de modelos, GUI amigable | CPU o GPU (CUDA opcional), 8–16 GB RAM | Chat privado, análisis de documentos, integración API |

| LM Studio | App de escritorio con GUI | Descarga de modelos con un clic, servidor API, RAG | GPU recomendada (4–24 GB VRAM), CPU potente | Estudio, desarrollo, uso personal sin nube |

| Ollama | CLI para ejecutar modelos | Ligero, sin GUI, compatible con muchos modelos | GPU opcional, desde 8 GB RAM | Programación, terminal, integración con apps |

| Jan | Alternativa a ChatGPT | Interfaz limpia, operación offline, extensible | GPU NVIDIA/AMD/Intel, 8–16 GB RAM | Chat privado, personalización, uso diario |

| llama.cpp | Implementación C/C++ | Máxima eficiencia, base de muchas apps | GPU recomendada para velocidad | Desarrollo, despliegue flexible, optimización |

| llamafile | Ejecutable único | Sin instalación, multiplataforma, muy rápido | GPU automática, CPU optimizada | Distribución de modelos, portabilidad |

| AnythingLLM | App todo en uno | RAG, agentes IA, manejo de documentos | No especificado, funciona en CPU/GPU | Empresas, automatización, gestión de archivos |

| NextChat | App web/escritorio | Máscaras personalizadas, datos locales | Ejecutable en Windows/macOS/Linux | Chat privado, despliegue personal, multilenguaje |

| DeepSeek | Modelo de lenguaje | Alto rendimiento, código abierto | GPU recomendada, 16 GB RAM+ | Codificación, razonamiento, tareas complejas |

| Mistral | Modelo de lenguaje | Ligero, rápido, buena comprensión | GPU opcional, 8–16 GB RAM | Chat, escritura, tareas generales |

Glosario de tecnicismos

Si leyendo la tabla te has encontrado con algún término que no conoces, puedes buscarlo aquí:

- LLM (Large Language Model): Es un tipo de inteligencia artificial que puede entender y generar texto como si fuera humano. Se usa para tareas como chatear, escribir, traducir o responder preguntas.

- GUI (Interfaz Gráfica de Usuario): Es una pantalla visual con botones, menús y ventanas que permite usar un programa fácilmente, sin necesidad de escribir comandos.

- CLI (Interfaz de Línea de Comandos): Es una forma de interactuar con programas escribiendo instrucciones en una ventana de texto, como si estuvieras hablando con el ordenador por escrito.

- RAG (Retrieval-Augmented Generation): Es una técnica que permite a la IA buscar información en documentos antes de responder. Es como si la IA leyera tus archivos para darte respuestas más precisas.

- API (Interfaz de Programación de Aplicaciones): Es una especie de puente que permite que dos programas se comuniquen entre sí. Por ejemplo, puedes conectar un modelo de IA con una app para que trabajen juntos.

- GPU (Unidad de Procesamiento Gráfico): Es una parte del ordenador diseñada para manejar tareas pesadas como gráficos o cálculos de IA. Hace que los modelos funcionen mucho más rápido.

- CPU (Unidad Central de Procesamiento): Es el “cerebro” principal del ordenador. Puede ejecutar modelos de IA, pero suele ser más lento que una GPU para tareas complejas.

- VRAM (Memoria de Video): Es la memoria que usa la GPU. Cuanta más tenga, mejor podrá manejar modelos grandes sin que el ordenador se ralentice.

- CUDA: Es una tecnología creada por NVIDIA que permite que la GPU acelere los cálculos necesarios para que la IA funcione más rápido.

- Multiplataforma: Significa que el programa o modelo puede funcionar en distintos sistemas operativos, como Windows, macOS o Linux.

- Modelo ligero: Es un modelo de IA que ocupa poco espacio y funciona rápido, incluso en ordenadores que no son muy potentes.

- Agente IA: Es un sistema que puede tomar decisiones o realizar tareas automáticamente, como si fuera un asistente inteligente que trabaja por ti.

- Máscara personalizada: Es una configuración que cambia el comportamiento del modelo. Por ejemplo, puedes hacer que actúe como un profesor, un terapeuta o un personaje específico.

Eh, esto de los asistentes de IA, tanto en local como en la nube, es un tema que me pone a dar vueltas la cabeza, no sé. Por un lado, entiendo que en la instalación local, según el artículo, tienes más control sobre tus datos, pero ¿no es eso un poco contradictorio con la idea de la nube? Y por otro lado, ¿qué pasa con la sostenibilidad y el impacto en el contexto de la IA? No sé, igual me estoy liando un poco. ¿Alguien podría explicarme un poco más sobre esto?

¿No creen que los asistentes de IA en local podrían ser más seguros que los de la nube? ¿Alguien tiene experiencia con esto?

Totalmente de acuerdo. Los asistentes locales ofrecen mayor control y seguridad. ¡Comprobado!

¿No creen que los asistentes de IA locales podrían ofrecer mayor privacidad que los basados en la nube? ¡Debate interesante!

Ya veo, ya veo… así que hablamos de asistentes de IA en local o en la nube, ¿no? Me pone a pensar, si se trata de sostenibilidad, ¿qué impacto tendrá en el contexto global si todos optamos por la nube? Igual me estoy liando, pero eso debe consumir un montón de energía, ¿no? Por cierto, ahora que lo pienso, ¿no es más seguro tener tu propia IA en local? No sé, igual estoy un poco perdido. ¿Qué opináis vosotros?

¿No creen que los asistentes de IA en local ofrecen mayor privacidad que los basados en la nube? ¡Me parece un punto clave a debatir!

¿Mayor privacidad? Tal vez, pero ¿qué pasa con las actualizaciones y el rendimiento? ¡No estoy tan seguro!

Por cierto, este artículo tiene un toque interesante, ¿no? Habla de asistentes de IA, pero luego te lanza al ruedo con tecnicismos como sostenibilidad y contexto. Joder, igual me estoy liando, pero ¿no suena un poco raro hablar de impacto en términos de instalación local? Que ya sé que los LLM son importantes y eso, pero no sé… ¿Alguien más piensa que es un poco… confuso? ¿O solo soy yo?

¿Por qué nadie habla de la seguridad de los datos en los asistentes de IA en la nube? ¡Es un tema crucial, amigos!

¡Totalmente de acuerdo! Nadie parece preocuparse hasta que su información queda expuesta.

¿No creen que los asistentes de IA locales podrían ser más seguros que los de la nube? ¡El glosario de tecnicismos fue de gran ayuda!

¿Realmente es seguro tener asistentes de IA en la nube? A veces, creo que una instalación local podría ser más segura. ¿Qué opinan?

¿No creen que los asistentes de IA en local podrían ser más seguros que en la nube, a pesar de su menor accesibilidad?

¿Seguridad local? ¡Más bien una falsa sensación de seguridad! La nube es el futuro.

Oye, he estado pensando, después de leer esto, sobre el impacto que tiene el uso de la IA local versus en la nube. Es un tema que no suelo considerar, pero, ahora que lo pienso, es bastante relevante, ¿no? Me pregunto, ¿la sostenibilidad de estas tecnologías es la misma? Y otra cosa, ¿qué pasaría en un contexto donde no hay buena conexión a internet? Por cierto, me ha hecho gracia ver que utilizamos muchos tecnicismos sin conocer su significado exacto. ¿A ti te pasa lo mismo?

¿Por qué tanto alboroto con IA en la nube si la local funciona mejor?

¿No creen que la IA local es muchísimo más segura que la nube?

Seguridad sí, pero la IA en la nube ofrece mucho más potencial y escalabilidad.

¿No creéis que los asistentes de IA en local ofrecen mayor privacidad que los de la nube? Es un tema a debatir.

Vaya, siempre pensé que los asistentes de IA funcionaban en la nube, nada más. Pero, ahora que lo pienso, tiene sentido, ¿no? Lo de la instalación local es como un ordenador de sobremesa, ¿verdad? Eso de que aporta sostenibilidad e impacto al contexto local, todavía no me queda claro. ¿Alguien podría explicarme un poco más sobre eso? Por cierto, ¿son estos los mismos LLM mencionados en el glosario de tecnicismos? Igual me estoy liando.

¿Y si la IA local es más segura que la nube? ¡Debate abierto!

La IA local puede ser hackeada fácilmente. ¿Seguridad? ¡La nube es el futuro indiscutible!

¿No creen que los asistentes de IA en local ofrecen más seguridad que en la nube? Además, ¿no deberíamos explicar mejor los tecnicismos?

¿Y si los asistentes de IA locales sean más seguros que los de la nube?

Oye, igual estoy un poco liado, pero este artículo me ha dejado pensando… ¿No será que los asistentes de IA en local tienen un impacto en la sostenibilidad mayor que los de la nube? Aunque, ahora que lo pienso, supongo que también tiene mucho que ver con el contexto de uso, ¿no? A ver, tú que piensas, ¿es mejor en la nube o en local? Y, por cierto, ¿no parece que a veces usamos demasiados tecnicismos? Quiero decir, sostenibilidad suena muy bien, pero a veces creo que se nos va la cabeza con estas cosas.

Oye, a ver si entiendo bien esto. Dicen que si optamos por asistentes de IA en local, no sé, como que se tiene más control sobre la sostenibilidad, ¿no? Pero, por cierto, ¿no será más complicado el tema del mantenimiento? Ahora que lo pienso, ¿no se mencionaba algo sobre el impacto en el artículo? Igual me estoy liando, pero ¿no sería mejor en la nube? ¿Qué opináis, chicos?

¿No creen que una IA local podría ofrecer mejor privacidad que las basadas en la nube? Aunque supongo que depende del LLM usado.

¿Estamos seguros de que la IA local es mejor? ¡La nube es el futuro!

La nube puede ser el futuro, pero el presente es la IA local. ¡Adaptemosnos!

¿No creéis que los asistentes de IA locales ofrecen más privacidad que los basados en la nube? Aunque quizás sean menos eficientes…

¿No creen que los asistentes de IA locales podrían ofrecer más privacidad que los de la nube? Me parece un tema para debatir.

Totalmente de acuerdo, la privacidad local supera a la nube. ¡El debate está servido!

¿Alguien ha considerado la seguridad de los datos con los asistentes de IA en la nube frente a los locales?

Claro, pero ¿no es más riesgoso dejar tus datos al alcance de cualquier hacker en tu PC local?

Pues, ahora que lo pienso, me dejó un poco confuso la parte de Los 10 LLM más usados para instalación local. I mean, puedo entender la idea de tener un asistente de IA en local, pero en cuanto a sostenibilidad e impacto, ¿no sería más eficiente tenerlo en la nube? Igual me estoy liando, pero, ¿qué pasa con el consumo energético de mantener estos sistemas en local? ¿Alguien ha pensado en eso?

¿Alguien ha considerado la seguridad de los datos al usar asistentes de IA en la nube? No siempre es tan seguro como la instalación local.

La seguridad en la nube a menudo supera a la local. ¡Confía en la innovación tecnológica!

¿Y si los asistentes de IA locales superan a los de la nube pronto?

¡Imposible! La nube tiene una capacidad de procesamiento inalcanzable para los asistentes locales.

¿Y si los asistentes de IA locales son más seguros que los de la nube?

¿Seguros? Hasta que se vuelvan autónomos y decidan tomar el control. ¡Cuidado con la IA!

¿Por qué no hablaron del LLM de OpenAI? ¡Ese también se usa mucho localmente!

Tienes razón, el LLM de OpenAI también es clave. ¡Gracias por señalarlo!

¿No creen que la eficiencia de los asistentes de IA depende más de su programación que de si están en local o en la nube?