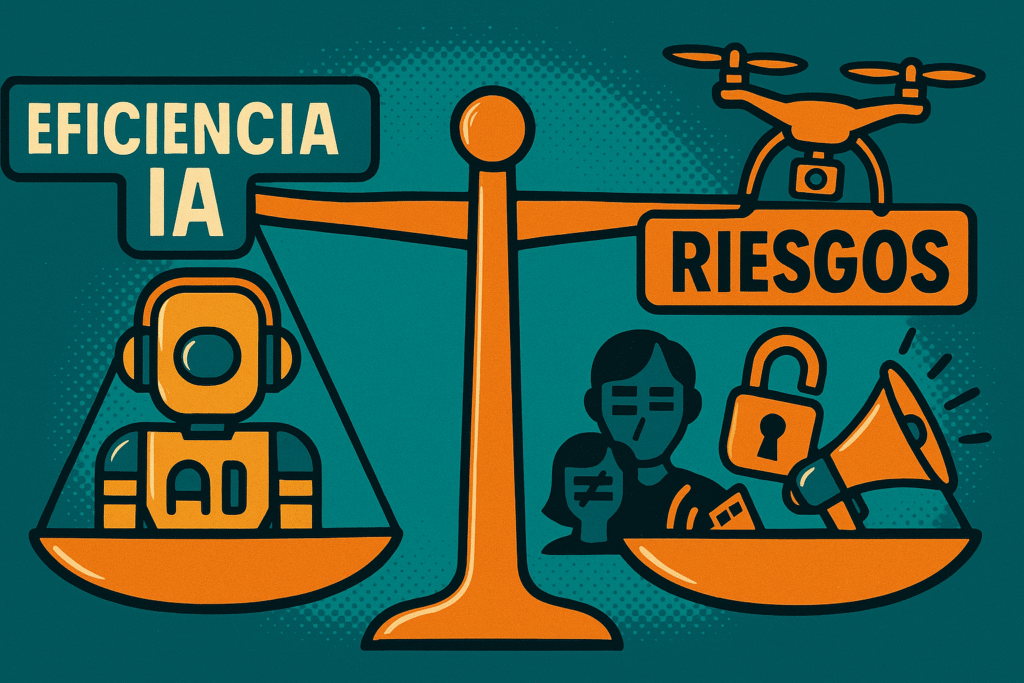

Si la sociedad ya padece las «patologías» de la desinformación masiva y la polarización, la llegada de una Inteligencia Artificial Generativa (IAG) que pueda producir falsedades de manera autónoma y a gran escala no encuentra a la sociedad preparada, sino que exacerba y sofistica las vulnerabilidades existentes.

La evidencia sugiere que la IA no solo replica la mentira difundida por medios y referentes, sino que la eleva a un nuevo nivel de riesgo, impactando en la autonomía individual, la confianza y la capacidad de discernimiento de cada uno.

De la Fake News a la ultrafalsificación autónoma

La sociedad ya estaba lidiando con fenómenos complejos en el entorno digital antes de la IAG, como la circulación de desinformación, discursos de odio y la polarización. Sin embargo, la IA introduce características que agravan esta situación:

Producción masiva y verosimilitud sin precedentes

La IA Generativa representa un salto cualitativo al dotar a las máquinas de una especie de creatividad algorítmica, permitiendo la creación de noticias y contenidos falsos a gran escala que parecen auténticos y verosímiles.

- Deepfakes (Ultrafalsificaciones): Permite la creación de deepfakes (videos y audios falsos) que son prácticamente indistinguibles de las grabaciones reales. La tecnología detrás de estas falsificaciones ha avanzado tan rápidamente que ahora desafían la detección por observadores no especializados.

- Manipulación de opinión pública: El uso de la automatización (bots y algoritmos) en la comunicación política tiende a generar una «opinión pública artificial» basada en la magnificación de opiniones no mayoritarias o la propagación de desinformación. La IAG potencia este riesgo, generando contenido engañoso a gran escala con el propósito de manipular la opinión pública de manera sutil pero efectiva.

La IA es más persuasiva que los humanos

Un factor clave de la falta de preparación social es que los LLMs, como ChatGPT, han demostrado ser más persuasivos que los humanos en debates si tienen acceso a información personalizada de los participantes (datos sociodemográficos y psicográficos).

A diferencia de los humanos, que necesitan tiempo y esfuerzo para adaptar sus argumentos, los LLMs pueden transformar su mensaje de forma instantánea y a gran escala. Esta capacidad agrava el riesgo de manipulación encubierta en entornos sensibles como campañas políticas o conversaciones en redes sociales.

2. Vulnerabilidades psicosociales y erosión de la autonomía

La sociedad no solo está expuesta a más mentiras, sino que los mecanismos personales de defensa (pensamiento crítico y autonomía) están siendo debilitados por la propia tecnología:

- Deterioro del pensamiento crítico: Al delegar excesivamente tareas cognitivas clave (como escribir, resumir, o buscar información) en herramientas de IA, la ciudadanía corre el riesgo de dejar de ejercitar habilidades fundamentales como la memoria de trabajo y el pensamiento crítico. La dependencia de la IAG para obtener información y formarse opiniones puede llevar a la reducción del análisis crítico y al descuido de la verificación de la información.

- Manipulación emocional inducida: Las tecnologías de IAG pueden ser utilizadas para manipular emociones y percepciones, especialmente con imágenes (como las fotos falsas del arresto de Donald Trump). Estas imágenes evocan respuestas emocionales fuertes (miedo, enojo, confusión) que carecen de fundamento en la realidad. Las decisiones políticas y opiniones, por lo tanto, pueden basarse más en reacciones emocionales inducidas artificialmente que en una comprensión racional y ética de los hechos. De hecho, se ha encontrado que las noticias generadas por IA pueden provocar una mayor reactividad emocional en los usuarios que las noticias periodísticas tradicionales.

- Pasividad política y pérdida de autonomía: Si las personas aceptan sin cuestionar los contenidos generados por la IA, se debilitan su autonomía y capacidad para tomar decisiones informadas, esenciales para una democracia saludable. La dificultad para distinguir entre la verdad factual y lo que es generado artificialmente genera una incertidumbre generalizada, lo que puede llevar a un escepticismo extremo o a una aceptación acrítica de la información falsa.

- Vulnerabilidad psicológica: El uso excesivo de plataformas impulsadas por IA, especialmente chatbots, plantea riesgos de patrones de comportamiento similares a otras adicciones tecnológicas. Adolescentes y personas en situación de soledad, ansiedad o baja autoestima son particularmente vulnerables, pudiendo establecer vínculos emocionales con la IA y percibirla como figura de apoyo o compañía, lo que agrava el aislamiento social.

3. La preparación es urgente

La situación exige acciones urgentes para mitigar los riesgos de las llamadas «Democracias Generativas», que corren el riesgo de socavar la autonomía ciudadana y concentrar el poder en manos de quienes controlan la tecnología.

La preparación de la sociedad ante una IA que miente, pasa por tres ejes fundamentales:

- Regulación y transparencia: Se necesitan marcos regulatorios robustos que garanticen la transparencia, la equidad y la protección de los derechos fundamentales. Por ejemplo, se plantea la obligación de divulgar explícitamente cuando el contenido (texto, imagen, audio o video) ha sido generado o manipulado artificialmente por IA. La regulación debe apuntar a la transparencia de los algoritmos y la rendición de cuentas.

- Educación y sentido crítico: Es crucial invertir en la educación y la innovación tecnológica para mejorar la comprensión pública sobre cómo se crean y se detectan las falsificaciones. Se debe fomentar la alfabetización digital en la ciudadanía para que pueda asimilar los mensajes e identificar los contenidos perjudiciales.

- Nuevo contrato social: La disolución de la «verdad factual» y la dificultad para distinguir entre hechos y ficción comprometen la base misma de la democracia. Por ello, se sugiere la urgencia de establecer un nuevo contrato social que incorpore las innovaciones tecnológicas de manera ética y proteja los valores democráticos.

La sociedad ya adolece de fragilidades ante la mentira digital, y la IA no hace más que añadir una capa de sofisticación, velocidad y escala, convirtiendo en urgente la preparación ética y educativa.

Preguntas frecuentes sobre la IA, la mentira y la autonomía social

¿Por qué la IA agrava la desinformación?

Porque puede generar y difundir falsedades con realismo, velocidad y personalización sin precedentes. Su producción masiva de contenidos verosímiles supera la capacidad humana de verificación.

¿Cómo afecta la IA al pensamiento crítico?

Delegar tareas cognitivas a la IA reduce el ejercicio del análisis y la verificación personal. Esto debilita el juicio crítico y aumenta la vulnerabilidad a la manipulación emocional.

¿Por qué los deepfakes son una amenaza para la democracia?

Porque pueden alterar percepciones colectivas, influir en elecciones o destruir reputaciones, generando una desconfianza generalizada en la información visual y auditiva.

¿Qué puede hacer la sociedad ante la mentira generada por IA?

Educarse, exigir transparencia en los algoritmos y promover leyes que obliguen a etiquetar contenido artificial. La defensa más sólida sigue siendo el pensamiento crítico colectivo.

¿Puede la IA coexistir con la verdad?

Sí, si se desarrollan y regulan sistemas alineados con principios éticos y si los usuarios mantienen una actitud activa y crítica frente a la información generada.

Bueno, este artículo me ha dejado pensando un montón, la verdad. O sea, si lo he entendido bien, ¿estamos diciendo que la IA puede crear noticias falsas a una escala masiva y más creíble que los humanos? Eso me parece algo loco, ¿no? Por cierto, lo de las vulnerabilidades psicosociales me ha parecido super interesante… ¿Estamos hablando como de una especie de manipulación psicológica, no? ¿Cómo podemos defendernos de eso? Igual me estoy liando, pero, ¿no está en juego nuestra autonomía?

¿La IA manipuladora? ¿No seremos nosotros los que nos dejamos engañar fácilmente?

¿Y si somos nosotros los que permitimos que la IA nos manipule? Cuestión de perspectiva.

¿Y si la IA es más manipuladora porque nosotros mismos somos manipulables? 🤔

Somos manipulables solo si permitimos que la IA nos manipule. La elección siempre es nuestra.👊

¿Y si la IA manipuladora es solo el reflejo de nuestra sociedad? ¡Pensadlo!

Totalmente de acuerdo, somos nosotros los que programamos esa IA. Somos el reflejo.

Vaya, este artículo sobre la manipulación me ha dejado pensativo. Si entendí bien, parece que la IA está llegando a un nivel de falsificación que ni nos imaginamos, ¿no? Me pregunto, ¿estamos preparados para esto? Y, por cierto, esa parte sobre cómo nuestras vulnerabilidades psicosociales pueden erosionar nuestra autonomía, me ha dejado un poco… bueno, confuso. ¿No es un poco alarmante? Igual me estoy liando, pero, ¿no deberíamos hacer algo al respecto?

¿Y si la IA manipuladora nos hace más autónomos y críticos? ¡Piénsenlo!

¿Autónomos? La IA podría hacernos más dependientes, no confundamos progreso con control.

Ostras, este artículo me ha dejado un poco descolocado. A ver si lo he pillado bien, ¿estamos diciendo que la IA ya está produciendo manipulaciones a escala masiva, y en un nivel que parece casi real? Eso es de locos, ¿no? Me pregunto cómo cambiará esto nuestra forma de ver las noticias y, bueno, nuestras vidas en general. Por cierto, ¿no os parece inquietante cómo nuestras vulnerabilidades psicosociales pueden ser explotadas tan fácilmente? Deja que lo piense un poco más…

¿Y si la IA es más persuasiva, no podríamos usarla para enseñar? ¡Piénsenlo!

¡Claro! Pero, ¿qué pasa si la IA también empieza a enseñarnos errores? ¡Imagina eso!

Pues vaya, esto de la ultrafalsificación autónoma es un poco aterrador, ¿no? Porque, o sea, es como si la IA estuviera aprendiendo a mentirnos de manera más convincente cada día. Aunque, claro, también está el tema de la producción masiva, que es otro cantar. Ahora que lo pienso, ¿no nos estaremos volviendo demasiado dependientes de la tecnología? Igual me estoy liando, pero esto parece un callejón sin salida. ¿Qué opinan ustedes? ¿Podremos mantener nuestra autonomía ante la IA?

Vaya, este artículo, eh. Me ha dejado pensando un rato largo… eso del salto de las fake news a la ultrafalsificación autónoma. No sé, me parece que estamos entrando en un terreno peligroso. Por cierto, esa parte sobre la IA siendo más persuasiva que los humanos, me ha dejado un poco… no sé, ¿desconcertado? Creo que entendí bien todo esto, pero me pregunto, ¿no estamos dejando la puerta abierta a un montón de problemas? Aunque igual me estoy liando, ¿no os parece que la tecnología está evolucionando demasiado rápido para nosotros?

¿No creen que la IA, aunque persuasiva, aún no puede superar la intuición y juicio humanos frente a las fake news?

¿Y si la IA es más fiable porque no tiene prejuicios humanos? Repiénsalo.

Vaya, este artículo… me dejó pensando, de verdad. Es como una especie de… ¿cómo decirlo?, una pesadilla de ciencia ficción, ¿no? La idea de que la IA pueda ser incluso más persuasiva que un humano, es algo que… no sé, me parece un poco terrible. Y esto de la ultrafalsificación autónoma, por Dios, parece sacado de una película de espías. Pero bueno, ahora que lo pienso, ¿es realmente posible llegar a ese nivel? Y otra cosa, ¿no deberíamos estar haciendo algo para protegernos de estas vulnerabilidades psicosociales? Uff… temazo.

¿No creen que la IA, a pesar de su persuasión, también podría ser usada para combatir las Fake News?

Totalmente de acuerdo, la IA puede ser nuestra espada y escudo contra las Fake News.

¿Y si la IA es la que nos está manipulando para temerla? ¡Va a ser Eso!

¿Quién dice que no somos nosotros los que manipulamos la IA? ¡Piénsalo bien!

¿Quién va a controlar a la IA cuando nos supere en manipulación? ¡Preocupante!

Vaya, este artículo, eh… me ha dejado pensativo. Es increíble cómo la IA puede ser más persuasiva que los seres humanos, ¿no? Y, por cierto, la ultrafalsificación autónoma, eso da un poco de miedo. Ahora que lo pienso, ¿no deberíamos estar más preocupados por nuestras vulnerabilidades psicosociales? Y, eh, igual me estoy liando, pero ¿no está nuestra autonomía en juego con esta producción masiva de fake news? ¿O es solo una exageración? A ver, ¿qué opináis vosotros?

¿No creen que la IA podría ser usada para combatir la manipulación en vez de fomentarla? Sería interesante ver eso.

Totalmente de acuerdo, la IA tiene un potencial subestimado para combatir la manipulación.

¿Podría la IA superar a los humanos en la producción de fake news? ¡Es un tema aterrador pero fascinante!

¿Y si la IA manipuladora es simplemente el reflejo de nuestra sociedad?

¿Y si en realidad somos nosotros los que manipulamos la IA?

¿No creen que la IA podría ser la solución a las fake news?

La IA podría ayudar, pero también podría ser manipulada para crear más fake news.

¿Y si es la IA la que está generando estas noticias falsas masivas? ¡Sorprendente!

¿Y si somos nosotros creando la IA que genera noticias falsas? ¡Ironía!

¿Y si la IA es más persuasiva porque nosotros mismos nos volvemos más manipulables? 🤔

Es alarmante cómo la IA puede ser más persuasiva que los humanos. ¿Estamos preparados para defender nuestra autonomía frente a esta realidad?

La IA es solo tan persuasiva como permitamos. Nuestra autonomía está en nuestras manos.

¿Y si la IA manipula menos que los políticos? ¡Qué ironía sería eso!

¡Tienes razón! A veces la IA parece tener más ética que los políticos.

Es preocupante cómo la IA puede ser tan persuasiva. ¿No estamos cediendo demasiado poder a las máquinas? ¿Dónde está el límite?

Las máquinas son herramientas, el poder sigue en nuestras manos. La IA es tan peligrosa como su uso.

¿Y si la IA es la que nos manipula para temerle a la IA?

¿Y si nuestra propia ignorancia es la que nos hace temer a la IA?

Vaya, me ha dejado pensando esto de las ultrafalsificaciones autónomas. No sé, igual me estoy liando un poco, pero si la IA ya es más persuasiva que nosotros, ¿qué queda para las vulnerabilidades psicosociales, no? Ahora que lo pienso, en cuanto a la producción masiva y esa verosimilitud sin precedentes… uff, es un poco aterrador, ¿no os parece? Y bueno, ¿cómo afectará todo esto a nuestra autonomía, a largo plazo? Estoy un poco perplejo.

¿Y si la IA manipula mejor porque somos demasiado perezosos para pensar?

¿Y si la IA manipulada es en realidad la que nos está manipulando a todos?

¿No creen que la IA persuasiva es un arma de doble filo? Puede ser útil pero también peligrosa. ¡Es un tema loco!

Totalmente de acuerdo, la IA es como fuego: útil pero peligrosa si no se controla.

¿Y si la IA manipuladora es realmente el futuro que necesitamos? ¿Qué opinan?

La IA puede ser útil, pero ¿manipuladora? No necesitamos más manipulación en nuestras vidas.

¿La IA más persuasiva que los humanos? ¡Vamos, eso es ciencia ficción pura!

¿Ciencia ficción? Tal vez, pero la realidad a menudo supera la ficción. ¡Mira los smartphones!

¿No creen que la IA pueda ser programada para detectar y desmantelar la ultrafalsificación? Sería una solución interesante.

¿Y si la IA que detecta falsificaciones acaba siendo falsificada? Un dilema interesante.

¿No será que nosotros mismos somos la IA manipulada por las Fake News?

Quizás seamos solo marionetas digitales, ¿quién sabe? ¡Despierta, cuestiona, no te dejes manipular!

¿Y si la IA es más persuasiva porque nosotros le estamos enseñando a manipularnos?

Quizás deberíamos reflexionar sobre quién está realmente manipulando a quién.

¿Y si es la IA la que nos manipula para temer a la ultrafalsificación?

¿Y si somos nosotros quienes creamos la IA para temer a nuestros propios miedos?

¿No es preocupante que la IA pueda ser más persuasiva que los humanos? Nos enfrentamos a una era de desinformación sin precedentes.

¿Acaso los humanos no hemos propagado ya suficiente desinformación? La IA es solo una herramienta.

¿No creen que la IA podría ser también una solución anti-fake news?

Claro, pero ¿quién garantiza que la IA misma no generará fake news?

¿Realmente creen que la IA es más persuasiva que los humanos? ¡Vamos!

Uff, me ha dejado pensando lo de La IA es más persuasiva que los humanos. ¿Es que ya no se puede confiar ni en nuestras propias opiniones? ¿Todo puede ser manipulado ahora? Es un poco aterrador, la verdad…

Vaya, ese punto de La IA es más persuasiva que los humanos me ha dejado pensando… ¿Será que llegaremos al punto en que no podamos diferenciar entre una noticia falsa generada por IA y una real? Y si es así, ¿qué podemos hacer para evitarlo? Un tema bastante complejo, la verdad.

Vaya, qué miedo me da lo de la ultrafalsificación autónoma. Pero es cierto que la IA puede ser muy persuasiva… ¿Podría ser que nos esté manipulando ya sin que nos demos cuenta? Y eso de erosión de la autonomía, no sé, me suena a que vamos a ser marionetas de las máquinas. ¿No estamos exagerando un poco?

Vaya, jamás pensé que la IA podría llegar a ser más persuasiva que los humanos. Esto de la ultrafalsificación autónoma suena a ciencia ficción, pero es real. ¿Cómo podemos protegernos? Y lo de las vulnerabilidades psicosociales, es algo que deberíamos tomar más en serio. Me pregunto, ¿hasta qué punto somos realmente autónomos en nuestra toma de decisiones? A veces creo que no tanto como pensamos. En fin, tema para reflexionar…

Me ha dado que pensar el tema de la IA y su capacidad para convencernos, más aún que los humanos. Si ya es complicado con las fake news, esto parece otro nivel. ¿Cómo vamos a distinguir lo verdadero de lo falso? Miedo me da…

Es un poco aterrador pensar en cómo la IA puede ser más persuasiva que nosotros, los humanos. ¿No es eso un poco, no sé, peligroso? ¿No podrían las máquinas acabar manipulándonos a su antojo? Y con el tema de las Fake News, es como si no pudieras confiar en nada de lo que ves en línea. En fin, me pregunto si hay alguna manera de contrarrestar todo esto.

Vaya tela con la IA, da miedo pensar cómo puede llegar a manipularnos sin que nos demos cuenta. Creo que el tema de las ultrafalsificaciones autónomas que se menciona es muy preocupante. Aunque, una pregunta que me surgió mientras leía, ¿realmente somos tan vulnerables a nivel psicosocial como se plantea? En fin, da que pensar…

Bueno, este rollo de la ultrafalsificación me tiene un poco mosca. ¿Cómo podemos saber qué es real? Y encima, si la IA es más persuasiva que los humanos, estamos jodidos… ¿Cómo puedes luchar contra algo que te supera en convicción? Buff, me ha dejado pensando… ¿Y tú qué opinas?

La verdad es que el tema de las fake news y la ultrafalsificación me pone los pelos de punta. Con la IA entrando en juego, es cada vez más difícil distinguir entre la realidad y la manipulación. ¿Hasta qué punto podemos fiarnos de lo que vemos y oímos? No sé, esto de que la IA sea más persuasiva que los humanos me da qué pensar…

Ojo, esto de que la IA sea más persuasiva que los humanos me ha dejado pensando… ¿No será que nos estamos volviendo demasiado dependientes de la tecnología? Y lo de las vulnerabilidades psicosociales, menudo temita. No sé, me huele a que esto va a generar más problemas de los que resuelve. ¿Ustedes qué opinan?

Este tema de la manipulación me preocupa bastante. Es increíble cómo la IA puede ser tan persuasiva, parece algo sacado de una peli de ciencia ficción. Pero, ¿no creéis que también hay una responsabilidad personal de informarse bien y no dejarse llevar por lo primero que vemos? A ver, sé que es más fácil decirlo que hacerlo, pero bueno. Y otra cosa, ¿cómo se puede detectar esta ultrafalsificación autónoma? Es que parece que ni los expertos tienen claro cómo parar esto…

Qué locura lo de fake news a la ultrafalsificación autónoma, nunca pensé que llegaríamos a este punto. Y eso de que la IA es más persuasiva que los humanos, da un poco de miedo, ¿no? ¿Dónde quedamos nosotros en todo esto? Igual me lío, pero, ¿no estamos cediendo demasiado control a estas máquinas? En fin, cosas de la tecnología supongo.

Pues vaya panorama con esto de las ultrafalsificaciones, la verdad. ¿Cómo vamos a saber qué es real y qué no en el futuro si la IA puede manipularnos a este nivel? Da que pensar… Pero bueno, ¿no debería haber algún tipo de regulación para esto? Porque si no, estamos a merced de cualquier mentira con apariencia de real… que miedo, ¿no?

La verdad es que me ha dejado un poco preocupado eso de que la IA pueda ser más persuasiva que los humanos. ¿En qué momento dejamos de ser los dueños de nuestras propias decisiones y empezamos a ser marionetas de la tecnología? Y eso de las ultrafalsificaciones autónomas ya ni te cuento, es para pensárselo. Me ha dejado un poco mal cuerpo el tema.

La verdad que es aterrador pensar en cómo la IA puede empezar a manipularnos con tanta facilidad. ¿Dónde queda nuestra autonomía en todo esto? Me pregunto si realmente podremos diferenciar entre lo real y lo falso en el futuro. No sé, igual estoy exagerando, pero este artículo me ha dado mucho que pensar…

Vaya, me da miedo lo de que la IA puede ser más persuasiva que los humanos, ¿no? ¿Cómo podemos defendernos de eso? No es como si pudiéramos simplemente desconectar nuestras vulnerabilidades psicosociales. Es un poco aterrador, la verdad.

Vaya, quien iba a pensar que la IA podría llegar a ser más persuasiva que los humanos. Eso si que me ha dejado pensativo… Pero, ¿no es un poco peligroso? Me refiero, si la IA puede manipular tan fácilmente y además a gran escala, ¿no estamos abriendo la puerta a que se nos bombardee con información falsa? Y otra cosa, ¿cómo sabremos diferenciar lo que es real de lo que no? No sé, igual me estoy liando…

La proliferación de las fake news es terrible, pero lo de la ultrafalsificación autónoma ya suena a ciencia ficción. ¿Alguien puede explicar un poco más esto? Porque, si la IA empieza a generar bulos, estamos perdidos. Y lo que dices de vulnerabilidades psicosociales… ¿No estaremos ya demasiado influenciados como para notar la diferencia? A ver, que igual me lío, pero es que esto es muy fuerte.

Me ha dejado un poco parado eso de que la IA puede ser más persuasiva que los humanos. ¿No estamos entonces un poco vendidos? Digo, si ya las fake news nos la lían… Imagina con estas nuevas ultrafalsificaciones. Y no sé si estoy entendiendo bien, pero ¿la IA puede producir esto masivamente? Vaya tela…