Tener tu propia IA en el ordenador suena perfecto: privacidad, cero suscripciones, libertad total. Pero como todo superpoder, viene con condiciones. En este artículo vamos a ver los retos reales de la IA local, explicados en lenguaje humano, para que puedas decidir con criterio si te compensa dar el salto.

1. El gran obstáculo: los requisitos de hardware

La pregunta que antes o después llega es: “¿Mi ordenador sirve para esto?”

La realidad es que muchos modelos de IA modernos son “tragones” en recursos, sobre todo en VRAM (memoria de la tarjeta gráfica) y RAM del sistema. Cuanta más VRAM tengas, más fácil será mover modelos grandes con buena velocidad.

A grandes rasgos:

- Con muy poca VRAM (2–4 GB) tendrás que usar modelos pequeños y muy comprimidos: sirven para tareas básicas, pero no esperes el rendimiento de un ChatGPT tope de gama.

- Con 6–8 GB de VRAM ya puedes usar modelos medianos que redactan, resumen y programan razonablemente bien.

- A partir de 12 GB de VRAM (en ordenadores para gamers o para video en 4k) el panorama mejora mucho: puedes mover modelos más grandes y tener una experiencia bastante cercana a la de servicios en la nube.

Si no tienes GPU dedicada, muchos modelos pueden funcionar solo con CPU, pero serán más lentos. No es imposible… pero sí menos cómodo. Aquí es donde mucha gente descubre que la IA local exige tratar al hardware como una decisión estratégica, no como un detalle secundario.

2. La brecha de rendimiento: locales vs modelos de frontera

Es importante ser realista: los modelos locales que puedes correr en tu equipo no suelen ser los mismos que usan las grandes empresas en sus data centers.

Los llamados “modelos de frontera” (los más punteros del mercado) suelen:

- Ser mucho más grandes.

- Estar entrenados con cantidades ingentes de datos.

- Requerir hardware brutal que no vas a tener en casa.

Los modelos que usamos en local suelen ser:

- Versiones más pequeñas u optimizadas.

- Modelos abiertos (open source) entrenados por comunidades o empresas que publican sus pesos.

- A menudo, cuantizados y recortados para caber en GPUs de consumo.

¿Significa eso que “no valen”? En absoluto. Para la mayoría de tareas cotidianas como escribir, resumir, programar, generar ideas, analizar texto, etc. Un buen modelo local puede ir sobrado. Pero conviene entender que no siempre tendrás el mismo nivel de “magia” o capacidad generalista que los gigantes de la nube.

Por eso, muchas personas optan por un modelo híbrido: IA local para el 80% del trabajo del día a día, y servicios en la nube para casos muy complejos o puntuales.

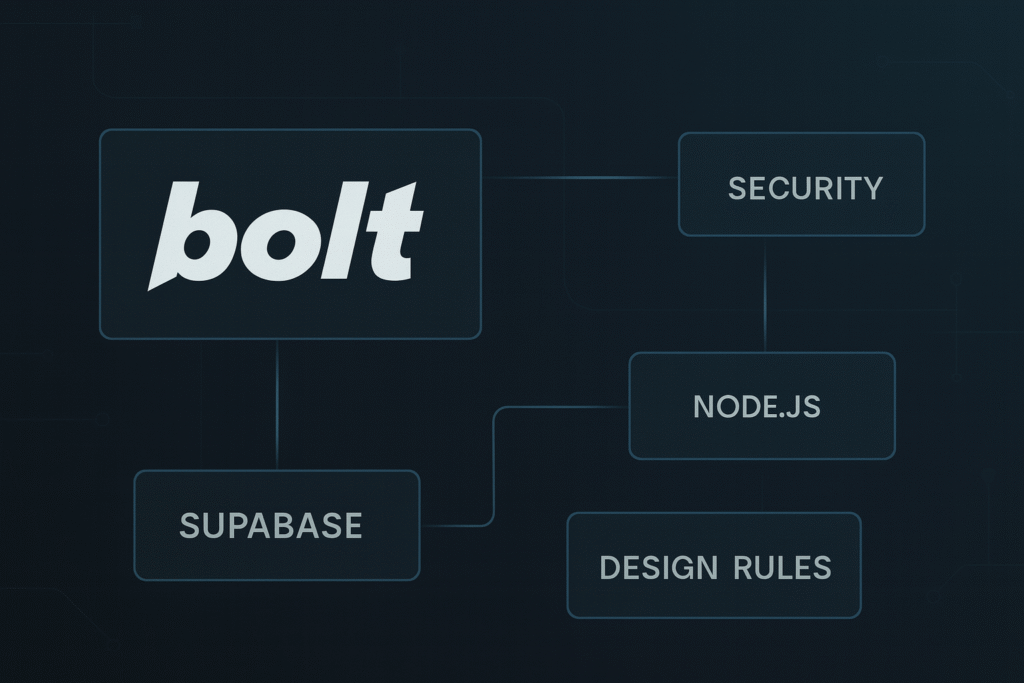

3. Complejidad técnica y mantenimiento

Con una IA en la nube, lo máximo que sueles hacer es abrir una web, loguearte y ya está.

Con IA local, hay más piezas:

- Elegir el modelo correcto (tamaño, idioma, tipo de tarea).

- Instalar el “motor” que lo ejecuta.

- Configurar rutas, puertos, extensiones o integraciones (por ejemplo, con tu editor de código o tu navegador).

Además, hay mantenimiento:

- Actualizar versiones cuando mejoran rendimiento o seguridad.

- Probar nuevos modelos y descartar los que no encajan.

- Vigilar que no te quedes sin espacio en disco (los modelos pesan gigas).

No hace falta ser ingeniero, pero sí tener cierto gusto por trastear. Si te agobia instalar cosas, leer instrucciones o lidiar con pequeños errores, la IA local puede hacerse cuesta arriba al principio. La recompensa está ahí, pero requiere algo de paciencia y mentalidad de “maker”.

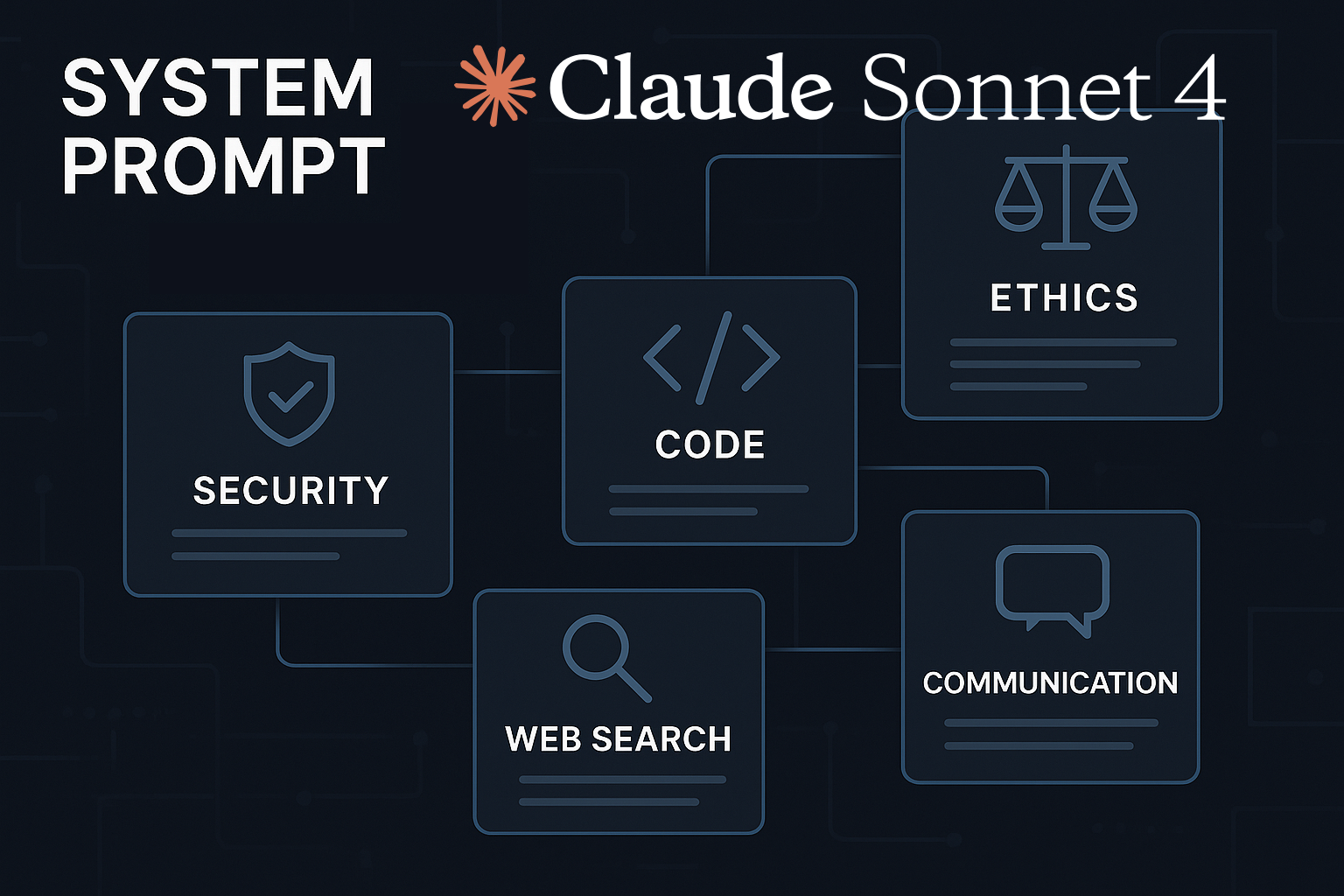

4. El debate ético: la doble cara de la libertad

La IA local trae consigo una libertad enorme: sin filtros externos, sin restricciones de tema, sin censura de plataforma. Y eso es precisamente lo que preocupa a muchos expertos.

En la práctica, un modelo local puede:

- Generar contenidos muy sensibles sin supervisión externa.

- Ser usado para automatizar tareas de desinformación, spam o acoso.

- Servir para procesar datos de terceros sin su consentimiento, si el usuario no es ético.

Es la clásica doble cara de la tecnología: la misma herramienta que permite soberanía digital y creatividad ilimitada puede utilizarse con fines dudosos.

¿Significa eso que la IA local es peligrosa por naturaleza? No. Significa que el peso de la responsabilidad recae mucho más en el usuario. Ya no hay una empresa moderando lo que haces; las decisiones éticas te tocan a ti.

Para quien quiere usar IA de forma responsable, esto es una oportunidad: puedes diseñar tus propios límites, tus propios filtros y tus propios códigos de uso. Pero conviene no ignorar la conversación ética solo porque el modelo “corra en tu casa”.

5. Consumo energético y huella ambiental

Otro punto del que se habla poco: la IA consume energía, tanto en la nube como en local.

Cuando ejecutas modelos grandes en tu GPU:

- Tu equipo consume más electricidad.

- La temperatura sube.

- Los ventiladores trabajan más tiempo.

En una sesión puntual no es dramático. Pero si montas flujos de trabajo intensivos, agentes que corren muchas horas o automatizaciones continuas, el impacto energético se nota.

A escala global, ya hay preocupación por el consumo brutal de los centros de datos dedicados a IA. Con la IA local, esa huella se reparte: parte de ese gasto lo asumes tú en casa u oficina.

No es un motivo para descartarla, pero sí para ser consciente: igual que optimizas tu código o tus procesos, también tiene sentido optimizar qué modelos usas, cuándo y para qué, para no gastar recursos a lo tonto.

6. Curva de entrada… que se vuelve ventaja

Si has llegado hasta aquí quizás estés pensando: “Suena genial, pero también parece un lío”. Y es cierto: la IA local no es plug-and-play para todo el mundo.

La parte positiva es que esa misma curva de entrada:

- Filtra a quienes solo buscan “jugar un rato” y se quedan con soluciones en la nube.

- Te obliga a aprender lo justo para tomar decisiones más inteligentes sobre tu infraestructura.

- Te da un control que muy poca gente tiene hoy sobre sus herramientas de IA.

Muchos usuarios que al principio se sentían agobiados por términos como VRAM, cuantización o modelos base, acaban agradeciendo haber pasado por ahí: entienden mejor qué pueden y qué no pueden pedirle a un modelo, y dejan de ver la IA como magia negra.

7. Entonces… ¿merece la pena?

Depende de quién seas y qué quieras hacer.

- Si solo usas la IA de forma muy esporádica y no te preocupa compartir datos con terceros, quizá te baste con servicios en la nube.

- Si trabajas con información sensible, usas la IA a diario o simplemente quieres controlar tu entorno digital, la IA local casi seguro merece el esfuerzo.

- Si eres perfil técnico, maker, emprendedor o muy curioso, montar tu propio stack local puede convertirse en parte de tu ventaja competitiva.

Lo importante es entrar sabiendo tanto las luces como las sombras. La IA local no es un juguete mágico, es una pieza de infraestructura: hay que cuidarla, entenderla y asumir la responsabilidad que conlleva.

Más adelante veremos la parte práctica: cómo elegir modelo, hardware y software para montar tu IA local ideal, y cómo conectarla a tus propios datos (RAG, fine-tuning, estrategia híbrida) sin tecnicismos innecesarios.

Preguntas frecuentes sobre los riesgos de la IA local

¿Qué desventajas tiene la IA local?

Requiere buen hardware, conocimientos técnicos, más mantenimiento y asume toda la responsabilidad ética el usuario.

¿La IA local rinde igual que ChatGPT en la nube?

No. Los modelos locales suelen ser más pequeños y optimizados; para tareas complejas, la nube sigue siendo superior.

¿Cuánta VRAM necesito para IA local?

Con 6–8 GB se puede trabajar bien; a partir de 12 GB la experiencia mejora notablemente.

¿La IA local consume más energía?

Sí. Ejecutar modelos grandes en GPU aumenta el consumo eléctrico y la temperatura del equipo.

¿Es peligrosa la IA local?

No por sí misma, pero al no tener filtros externos exige un uso ético y responsable por parte del usuario.