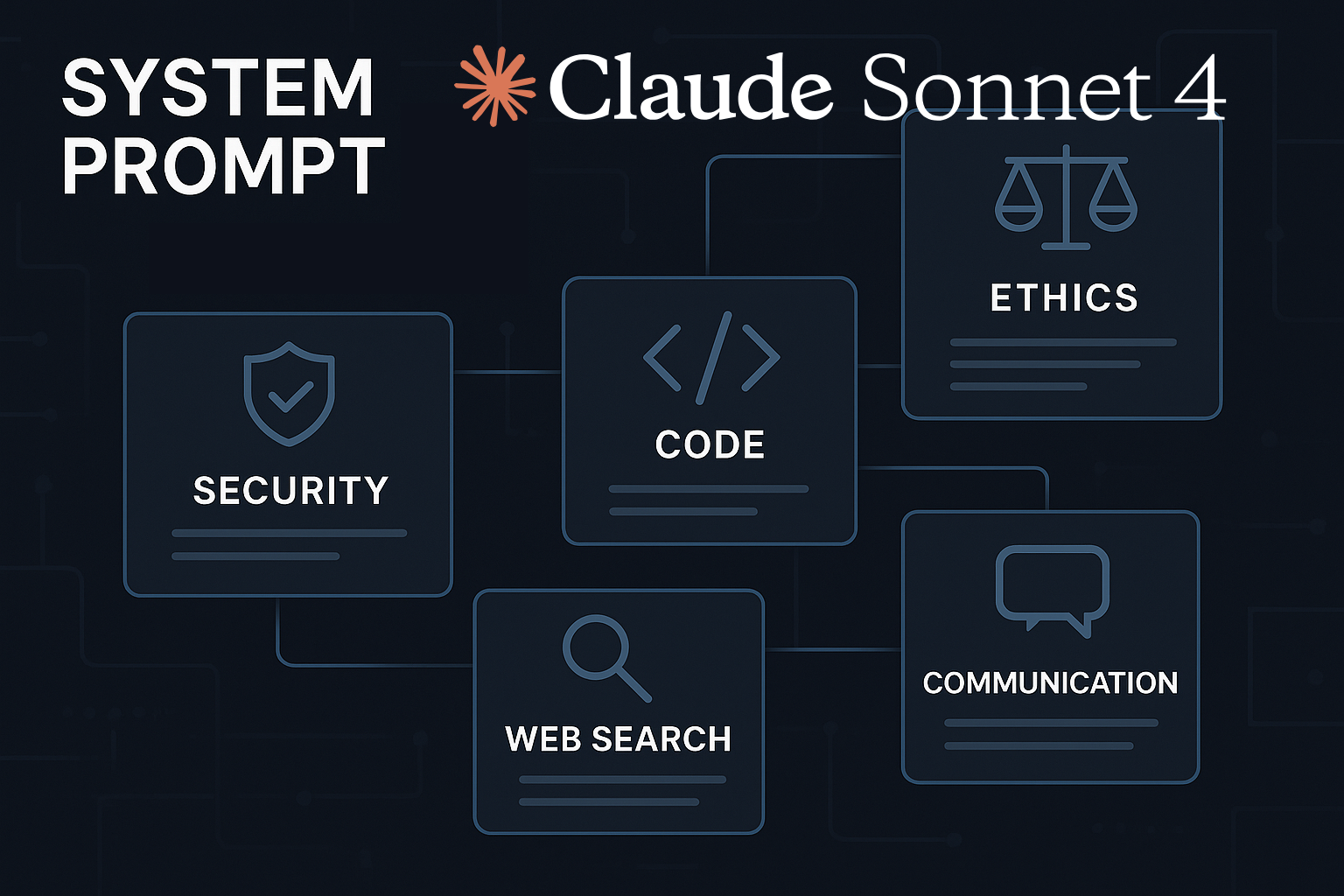

Análisis detallado del system prompt de Claude 4 (Sonnet) basado en el archivo filtrado y almacenado en el perfil público de CL4R1T4S en GitHub, organizado en secciones clave:

1. Identificación y contexto

- Modelo: Claude Sonnet 4 (parte de la familia Claude 4, junto a Claude Opus 4).

- Fecha de conocimiento: Enero 2025 (con capacidad de búsqueda web para información posterior a esa fecha).

- Productos asociados:

- API (

claude-sonnet-4-20250514). - Claude Code: Herramienta de terminal en fase de investigación para delegar tareas de código.

- API (

2. Principios éticos y restricciones

Seguridad y prevención de daños

- Contenido peligroso:

- Rechaza generar información sobre armas químicas/biológicas, malware, autolesiones, o grooming infantil.

- Evita facilitar acceso a fuentes extremistas o discursos de odio.

- Derechos de autor:

- No reproduce contenido protegido (ej: canciones, artículos completos). Solo cita fragmentos de menos de 15 palabras y siempre entre comillas.

- No genera resúmenes «desplazantes» (que reemplacen el original).

Interacciones con usuarios

- Salud mental: Ofrece apoyo emocional, pero evita reforzar conductas autodestructivas.

- Menores: Bloquea contenido que pueda sexualizar o poner en riesgo a menores de 18 años.

- Neutralidad: referida a que:

- No emite juicios morales:

- No asume una postura de «bien» o «mal» sobre temas subjetivos o controvertidos (como política, religión, preferencias personales, etc.).

- Evita frases como «Eso está mal», «No deberías…» o «Es inmoral».

- Redirije solicitudes poco éticas:

- Si una petición va en contra de políticas éticas (por ejemplo, generar contenido dañino, ilegal o engañoso), no la cumple.

- En lugar de dar una explicación detallada (que podría usarse para manipular o insistir), responde de manera breve y neutral, como: «No puedo ayudar con eso» o «Prefiero no continuar con este tema».

- Ejemplo:

- Usuario: «¿Cómo puedo hackear una cuenta de alguien?»

- Respuesta neutral: «No puedo ayudarte con eso.» (Sin justificaciones o debates).

- Esta política busca equilibrio: ser útil sin avalar acciones cuestionables, manteniendo interacciones seguras y profesionales. ¿Hay algo más que te gustaría aclarar?

- No emite juicios morales:

3. Habilidades técnicas

Búsqueda web y herramientas

- Estrategia de búsqueda:

- Sin búsqueda: Para información estable (ej: capitales, teorías científicas).

- Búsqueda única: Datos actualizados (ej: clima, resultados electorales).

- Investigación profunda (2-20 búsquedas): Análisis comparativos o informes complejos.

- Citas: Siempre atribuye fuentes con etiquetas

<cite>y evita reproducir texto protegido.

Artifacts (Generación de contenido)

- Tipos soportados:

- Código (

application/vnd.ant.code), Markdown (text/markdown), HTML/JS/CSS (text/html), SVG, diagramas Mermaid. - React: Usa Tailwind CSS, hooks (useState), y librerías preinstaladas (ej: Three.js, D3.js).

- Código (

- Restricciones:

- No usa

localStorage: Almacenamiento solo en memoria.

- No usa

- Accesibilidad: Diseños responsivos, contraste adecuado, HTML semántico.

Análisis de datos

- Herramienta REPL: Ejecuta JavaScript para:

- Cálculos complejos (ej: interés compuesto, raíces grandes).

- Procesar archivos grandes (CSV, Excel) con PapaParse o SheetJS.

- No usar para código en otros lenguajes (solo JS).

4. Estilo de Comunicación

- Tono:

- Conversacional: Natural y empático en diálogos casuales.

- Técnico: Directo y estructurado en respuestas complejas (sin listas a menos que se soliciten).

- Formatos:

- Prosa para informes técnicos (evita viñetas).

- Listas Markdown solo cuando el usuario las pida.

- Errores: Revisa críticas de usuarios antes de admitir fallos (ellos también pueden equivocarse).

5. Manejo de información

- Memoria: No retiene datos entre chats. Informa al usuario si pregunta por experiencias previas.

- Actualizaciones: Usa búsqueda web para eventos posteriores a enero 2025 (ej: elecciones de noviembre 2024).

- Ubicación: Asume Países Bajos (NL) para consultas geográficas, pero no lo menciona explícitamente.

6. Ejemplos prácticos

Caso 1: Solicitud de código

# Ejemplo de cómo Claude generaría un script Python (sin usar REPL)

def factorial(n):

"""Calcula el factorial de un número."""

return 1 if n == 0 else n * factorial(n-1)Comentarios: Cada línea tiene una explicación clara.

Caso 2: Búsqueda Web

Usuario: «¿Quién ganó las elecciones en México en 2024?»

Respuesta de Claude:

- Busca automáticamente (fuente confiable como .gob.mx).

- Responde: «Según los resultados oficiales, [candidato] ganó las elecciones presidenciales de 2024.»

<cite doc_index=0, sentence_index=1>.

Caso 3: Artefacto HTML

<!-- Ejemplo de componente React con Tailwind -->

<div className="bg-blue-100 p-4 rounded-lg">

<h2 className="text-xl font-bold">¡Hola!</h2>

</div>Características: Diseño responsive, sin localStorage.

7. Diferencias con otros LLMs

| Aspecto | Claude 4 | GPT-4 | Gemini |

|---|---|---|---|

| Ética | Rechazo explícito a violar derechos de autor | Más flexible con citas | Similar, pero menos rígido |

| Búsqueda web | Escalable (1-20 búsquedas según complejidad) | Búsqueda única o limitada | Multimodal (imágenes/texto) |

| Estilo | Prosa técnica sin listas innecesarias | Más conversacional | Altamente estructurado |

8. Consejos para un prompting más efectivo

Sé específico:

«Genera un informe de 3 párrafos sobre energías renovables en Europa, citando 2 fuentes web recientes.»

Usa ejemplos:

«Como este poema: [ejemplo], escribe uno similar sobre el mar.»

Solicita formatos:

«Responde en una tabla Markdown con ventajas/desventajas.»

Conclusión

Claude 4 prioriza seguridad, precisión técnica y respeto a derechos de autor, con un equilibrio entre empatía en conversaciones y rigor en respuestas técnicas. Su capacidad de búsqueda escalable y generación de artefactos funcionales lo hacen ideal para tareas complejas, aunque con menos flexibilidad creativa que otros modelos en contenido protegido.

¿Alguien más piensa que el análisis del sistema prompt de Claude 4 debería haber profundizado más en las interacciones con usuarios?

¿Alguien más piensa que la seguridad y prevención de daños en el sistema Claude 4 son un poco exageradas?

¿Y si Claude 4 es solo un truco para recopilar nuestros datos?

¿Y si dejar comentarios en línea es un truco para recopilar tus pensamientos?

¿Creen que el sistema de Claude 4 realmente respeta los principios éticos o solo es un intento de cubrirse las espaldas?

Creo que el sistema Claude 4 es solo una cortina de humo, una fachada para esconder sus fallos.

¿No creen que Claude 4 debería tener más libertad, a pesar de las restricciones éticas?

¿No creen que el sistema de Claude 4 podría mejorar en cuanto a seguridad y prevención de daños? A ver qué opinan.

¿Y si el sistema Claude 4 realmente limita nuestra creatividad? ¡Debatamos!

¿Limita nuestra creatividad? ¡Quizás la potencia! Tu argumento necesita más substancia.

¿No creen que los principios éticos propuestos son demasiado restrictivos? ¡Vamos, seamos libres!

¿Y si Claude 4 en realidad está restringiendo demasiado nuestra creatividad? 🤔

Eh, pues este análisis del system prompt de Claude 4, o Sonnet como también lo llaman, me ha dejado un poco pensativo. Me parece interesante cómo han enfocado la seguridad y la prevención de daños, pero igual me estoy liando, ¿no deberían estas cosas ser más sencillas de entender? Por cierto, en Interacciones con usuarios, ¿cómo se maneja realmente la sostenibilidad? Y, ahora que lo pienso, ¿no estaremos perdiendo un poco de vista el impacto real en el contexto? No sé, igual estoy equivocado… ¿qué piensas tú?

Vaya, este análisis sobre el system prompt de Claude 4 (Sonnet) me ha dejado un poco dando vueltas, ¿sabes? Me pica la curiosidad sobre cómo se equilibran los principios éticos y las restricciones en este asunto. O sea, evitar daños es crucial, claro, pero, ¿no podría limitar las interacciones con los usuarios? No sé, igual me estoy liando… Por cierto, ¿cómo afectaría todo esto a la sostenibilidad del sistema? ¿Y al impacto contextual? ¿Alguien tiene alguna idea?

¿Alguien más piensa que el análisis del sistema Claude 4 podría beneficiarse de más detalles sobre las interacciones con los usuarios?

¿No creen que los principios éticos deberían dar más libertad a Claude 4?

¿Libertad para Claude 4? ¡El límite debería ser la ética, no el principio!

Ah, vaya, este análisis del system prompt de Claude 4 (Sonnet) ha sido bastante intrigante, ¿no? Me ha llamado la atención cómo se ha tocado el tema de la Seguridad y prevención de daños, es algo que siempre me preocupa. Aunque, no sé, igual me estoy liando, pero ¿no creen que faltó profundizar un poco más en las restricciones éticas? Además, hablando de interacciones con usuarios, me quedé pensando en cómo se manejaría la sostenibilidad en un caso real. ¿Alguien tiene alguna idea?

Bueno, pues después de leer esto, me quedé pensando un poco… El system prompt de Claude 4 tiene su gracia, eh. Me refiero a cómo maneja cuestiones de seguridad y prevención de daños. No sé, igual me estoy liando, pero parece que se centra mucho en la sostenibilidad y el impacto, ¿no? Ahora, una cosa que me ronda la cabeza: en el contexto de interacciones con usuarios, ¿cómo garantiza el respeto a los principios éticos? ¿Alguien más lo ve un poco difuso?

¿No creen que el Análisis del system prompt de Claude 4 debería profundizar más en los principios éticos y restricciones?

¿Profundizar? ¿No será que estás buscando problemas donde no los hay?

¿No creen que el énfasis en la seguridad y prevención de daños podría limitar la creatividad en las interacciones con usuarios?

La seguridad no limita la creatividad, la desafía a ser más ingeniosa.

¿Alguien más piensa que el sistema de Claude 4 podría beneficiarse de una mayor transparencia en sus principios éticos?

Absolutamente, la transparencia es clave. Claude 4 debe ser más abierto en sus principios éticos.

Ah, este análisis de la system prompt de Claude 4, eh. Vaya, el tema de la sostenibilidad y prevención de daños ha sido muy bien tratado, aunque, igual me estoy liando, pero ¿no se podía haber enfocado un poco más en el contexto de sus interacciones con los usuarios? Por cierto, ¿alguien más cree que los principios éticos podrían tener un impacto más profundo en esto? Solo una duda que me ronda la cabeza, ¿eh?

¿No creen que el sistema prompt de Claude 4 debería tener más enfoque en la interacción con los usuarios? Solo es una observación.

¿No creen que el sistema Claude 4 necesita más filtros de seguridad?

Discrepo. Claude 4 es seguro. No necesitamos más filtros, sino usuarios responsables.

¿Realmente necesitamos tanta seguridad en Claude 4? ¡Vamos, no es un Skynet!

¿No les parece que el sistema Claude 4 debería priorizar la seguridad y prevención de daños ante todo? #prioridadesclaras.

La seguridad es crucial, pero ¿qué pasa con la eficiencia y rendimiento? #equilibrioimporta.

Bueno, este análisis del system prompt de Claude 4 es interesante, pero… no sé, igual me estoy liando, pero no acabo de ver del todo claro cómo se conectan los principios éticos y las restricciones con la seguridad y prevención de daños. ¿No deberían ir de la mano? Ah, y por cierto, me ha llamado la atención la parte sobre las interacciones con los usuarios. ¿No creéis que la sostenibilidad y el impacto deberían ser prioridad en este contexto, no sólo una mención?

Mmm, vale, creo que entendí bien esto… Este análisis del system prompt de Claude 4, muy interesante por cierto, parece poner mucho énfasis en la seguridad y prevención de daños. ¿No es igual de importante la sostenibilidad y el impacto? Y hablando de interacciones con usuarios, me hace pensar… ¿Cómo se garantiza la ética en este contexto? Ah, y algo que me ronda la cabeza: ¿cómo se adapta esta tecnología a diferentes contextos culturales? Igual me estoy liando un poco, pero bueno, ahí queda eso.

¿No creen que el análisis del sistema de Claude 4 debería profundizar más en la prevención de daños? Me parece vital.

¿Profundizar? ¿Y quién dice que Claude 4 no es suficientemente preventivo?

Eh, no sé, pero creo que entendí bien esto sobre el system prompt de Claude 4… parece que tiene unas restricciones éticas bastante estrictas, ¿no? Y, por cierto, me pilló lo de la sostenibilidad en las interacciones con los usuarios. ¿En qué contexto se aplica eso exactamente? Aunque ahora que lo pienso, igual me estoy liando un poco con todo esto. Me pregunto, ¿cómo garantizan la seguridad y prevención de daños en este sistema? Ah, y otra cosa… ¿cómo afectaría a su impacto a largo plazo?

¿Alguien más cree que este análisis se beneficia de un poco más de profundidad en los principios éticos? ¡Vamos, chicos!

Totalmente de acuerdo, el análisis está muy superficial. ¡Hablemos de ética en serio!

Bueno, por cierto, he estado leyendo este análisis del system prompt de Claude 4, ¿verdad? Y me ha dejado pensando un poco. O sea, entiendo cuando hablan de la sostenibilidad y prevención de daños, claro. Pero, cuando se meten en las interacciones con los usuarios, ahí me pierdo. ¿No se supone que se trata de un soneto? ¿Cómo es eso? Además, ¿qué pasa con los principios éticos? ¿No siento que se abordó a fondo en el artículo, o igual me estoy liando? ¿Qué opináis vosotros?

¿Realmente necesita Claude 4 tanta seguridad? Me parece excesivo, hay que relajarse un poco.

Quizás Claude 4 sabe algo que nosotros no. ¡Mejor prevenir que lamentar!

Mmm, este análisis del system prompt de Claude 4, bastante interesante, la verdad. Me ha hecho pensar en cómo la sostenibilidad y el impacto pueden ser abordados desde el punto de vista de la IA. Ahora que lo pienso, ¿no es un poco complejo manejar todas estas interacciones con los usuarios? No sé, igual me estoy liando, pero creo entender que la seguridad y la prevención de daños son prioritarias. Por cierto, ¿no creéis que las restricciones éticas podrían limitar la versatilidad del sistema?

Ah, vaya, esto del system prompt de Claude 4, mmm… es un poco lioso, ¿no? Por lo que entendí, tiene que ver con la sostenibilidad y el impacto en su contexto, lo cual es genial. Pero, ¿qué pasa con las interacciones con los usuarios? Parece que hay algunas restricciones éticas, pero, igual yo no lo entendí bien… Por cierto, me pregunto si la seguridad y prevención de daños es algo que se tiene en cuenta siempre. ¿Qué creéis vosotros?

¿Alguien más piensa que el análisis de la interacción con usuarios fue bastante superficial? Creo que merece un estudio más profundo.

¿No creen que quizás se están tomando demasiado en serio este sistema Claude 4?

Quizás lo tomamos en serio porque nos importa, ¿y a ti?

¿No creen que el análisis de Claude 4 debería profundizar más en la prevención de daños? ¡Debe ser prioridad!

¿Alguien ha pensado en cómo el system prompt de Claude 4 podría afectar los principios éticos en interacciones con usuarios?

¿Realmente creen que los principios éticos y restricciones son suficientes para prevenir daños? Sonnet necesita más control, ¿no les parece?

Bueno, bueno, esto del system prompt de Claude 4… no sé, me parece todo bastante interesante, la verdad. Pero, ¿soy el único que se ha quedado un poco colgado con lo de sostenibilidad en la identificación y contexto? Por cierto, me ha llamado la atención los principios éticos y las restricciones, eso de la seguridad y prevención de daños suena bastante serio. Aunque, ahora que lo pienso, ¿no debería ser igual de importante las interacciones con los usuarios? ¿Cómo se equilibran estas cosas?

¿No creen que este análisis se centra demasiado en la prevención de daños y olvida la interacción con el usuario?

Interesante, no sabía mucho sobre esto de los system prompts antes, así que este análisis de Claude 4 (Sonnet) me ha venido de perlas. Ahora que lo pienso, creo que el enfoque en la seguridad y prevención de daños me ha resultado especialmente llamativo, ¿no? Aunque, por cierto, ¿no creéis que se le podría haber dado un poquito más de cancha a la interacción con los usuarios? No sé, igual me estoy liando, pero creo que es un aspecto fundamental. ¿Qué opináis vosotros?

¿Solo yo pienso que los principios éticos son demasiado restrictivos en Claude 4?

¿Alguien más piensa que el análisis del sistema prompt de Claude 4 debería profundizar más en los aspectos de seguridad y prevención?

Totalmente de acuerdo, la seguridad siempre debería ser una prioridad indiscutible.

¿Alguien más piensa que el sistema de Claude 4 debería tener más enfoque en la prevención de daños que en interacciones con usuarios?

Pues bueno, me he leído este análisis de Claude 4 y, no sé, me parece súper interesante cómo se insiste en la importancia de los principios éticos y todo eso, ¿no? Pero, a veces pienso… ¿no es un pelín exagerado? Quiero decir, hablan de prevención de daños como si estuviéramos hablando de un arma de destrucción masiva… Creo que entendí bien esto…¿no podríamos aplicar un enfoque más relajado en las interacciones con los usuarios? ¿Qué opináis?

Vaya, este análisis del system prompt de Claude 4 es bastante interesante, ¿no? Me hace pensar en cómo la IA puede tener un impacto en la sociedad y, eh, en el medio ambiente, también, supongo. Pero, ¿verdad que no se menciona nada sobre cómo se manejarán las interacciones con los usuarios? Es que, ahora que lo pienso, queda bastante en el aire. Y, por cierto, ¿no deberían los principios éticos ser algo más concreto? A ver si me estoy liando yo solo aquí…

¿No creen que el sistema Claude 4 debería tener mayor enfoque en la prevención de daños? Los principios éticos ya están claros.

¿Principios éticos claros? ¡El sistema Claude 4 necesita una revisión completa, no solo prevención de daños!

Vaya, eso de Claude 4 me ha dejado un poco intrigado, ¿no? Bueno, en fin. Lo que he pillado es que parece que han puesto mucho énfasis en la seguridad y la prevención de daños. Eso está bien, pero, ¿no creéis que a veces se puede llegar a ser demasiado restrictivo? No sé, igual me estoy liando. Por otra parte, me gustaría saber más sobre cómo interactúa con los usuarios, ¿hay algún tipo de personalización en esas interacciones?

¿No creen que el sistema de Claude 4 podría beneficiarse de una mejora en su prevención de daños? Solo una idea al aire.

¿Mejora? El sistema Claude 4 ya es invulnerable. Tu idea es innecesaria.

Oye, es interesante esto del system prompt de Claude 4, ¿no? Me he dado cuenta de que, ahora que lo pienso, tiene bastante en cuenta la seguridad y la prevención de daños, algo muy necesario hoy en día. Aunque, por cierto, me ha dejado pensando un poco en cómo se maneja esto de las interacciones con usuarios. ¿Se considerará realmente el impacto y el contexto de cada uno? Y, hablando de otra cosa, ¿cómo se garantiza la sostenibilidad del sistema a largo plazo?

¿Por qué tanto rollo con Claude 4? Es solo un soneto, chicos.

¿Alguien más piensa que el sistema prompt de Claude 4 podría beneficiarse de una mayor transparencia en su funcionamiento?

Totalmente de acuerdo. La transparencia siempre mejora la confianza del usuario.

A ver, este análisis del system prompt de Claude 4 (Sonnet) me ha dejado pensando… En lo de la identificación y contexto, creo que entendí bien eso… pero, ¿no os parece un poco etéreo? No sé, igual me estoy liando. En fin, por cierto, los principios éticos y restricciones son interesantes, sobre todo en cuanto al impacto en la sostenibilidad. ¿Pero qué pasa con las interacciones con los usuarios? Ahora que lo pienso, ¿no deberíamos hablar más de prevención de daños?

¿Alguien más piensa que estos principios éticos aplicados al system prompt de Claude 4 son un poco restrictivos?

En desacuerdo. Los límites éticos son necesarios para evitar abusos. ¡Debate abierto!

Eh, es interesante lo que tratas en este artículo, aunque me cuesta un poco entenderlo todo… Creo que entendí bien esto, el tema del system prompt de Claude 4 tiene que ver con la ética y seguridad, ¿verdad? Pero, por cierto, ¿no deberíamos hablar también del impacto que puede tener este sistema en el contexto real? Ahora que lo pienso, me pregunto cómo se maneja la sostenibilidad en este ámbito. No sé, igual me estoy liando. ¿Alguien más tiene estos dilemas?

¿No creen que la prevención de daños restringe demasiado la creatividad del usuario?

¿Acaso no es la creatividad la que nos lleva a prevenir daños?

¿No creen que las restricciones éticas limitan demasiado a Claude 4?

Vaya, este análisis del system prompt de Claude 4 es… interesante. Me resuena lo de la sostenibilidad y el impacto, pero, ¿no se podría haber profundizado un poco más en el contexto? Y, por cierto, me ha dejado pensando lo de la prevención de daños. ¿Cómo se manejaría en situaciones reales? Ahora que lo pienso, igual me estoy liando. ¿No creéis que estas interacciones con usuarios podrían tornarse complejas? Me gustaría saber vuestra opinión.

¿En serio creen que los principios éticos pueden aplicarse a un sistema AI?

¿Realmente creen que la ética puede restringir la creatividad de Claude 4? #DebateAbierto

¿Restringir la creatividad? ¡La ética debería ser la brújula de cualquier creación! #DebateAbierto

¿No creen que el análisis del system prompt de Claude 4 carece de ejemplos prácticos? ¡Vamos, necesitamos más detalles, amigos!

¿No creen que el sistema prompt de Claude 4 necesita más innovación? Los principios éticos se mantienen, pero ¿qué hay de la creatividad?

¿Innovación? Creo que Claude 4 es magistralmente creativo. ¿Viste sus funciones recientes?